«`html

Мультимодальный искусственный интеллект: решения и практическое применение

Мультимодальный искусственный интеллект (ИИ) сосредотачивается на разработке моделей, способных обрабатывать и интегрировать различные типы данных, такие как текст и изображения. Эти модели необходимы для ответов на визуальные вопросы и генерации описательного текста для изображений, демонстрируя способность ИИ понимать и взаимодействовать с многоаспектным миром. Смешивание информации из различных модальностей позволяет ИИ выполнять сложные задачи более эффективно, что демонстрирует значительный потенциал в исследованиях и практических применениях.

Оптимизация эффективности модели

Одной из основных проблем в мультимодальном ИИ является оптимизация эффективности модели. Традиционные методы слияния модально-специфических кодировщиков или декодировщиков часто ограничивают способность модели эффективно интегрировать информацию различных типов данных. Это приводит к увеличению вычислительной нагрузки и снижению эффективности работы модели. Исследователи стремятся разработать новые архитектуры, которые позволят более эффективно интегрировать текст и изображения с самого начала, с целью улучшения производительности модели и ее эффективности в обработке мультимодальных входов.

Инновационные решения

Существующие методы обработки смешанных модальных данных включают архитектуры, которые предварительно обрабатывают и кодируют текст и изображения отдельно перед их интеграцией. Эти подходы, хотя и функциональны, могут быть вычислительно интенсивными и могут только частично использовать потенциал раннего слияния данных. Разделение модальностей часто приводит к неэффективности и неспособности адекватно улавливать сложные взаимосвязи между различными типами данных. Поэтому требуются инновационные решения для преодоления этих проблем и достижения лучшей производительности.

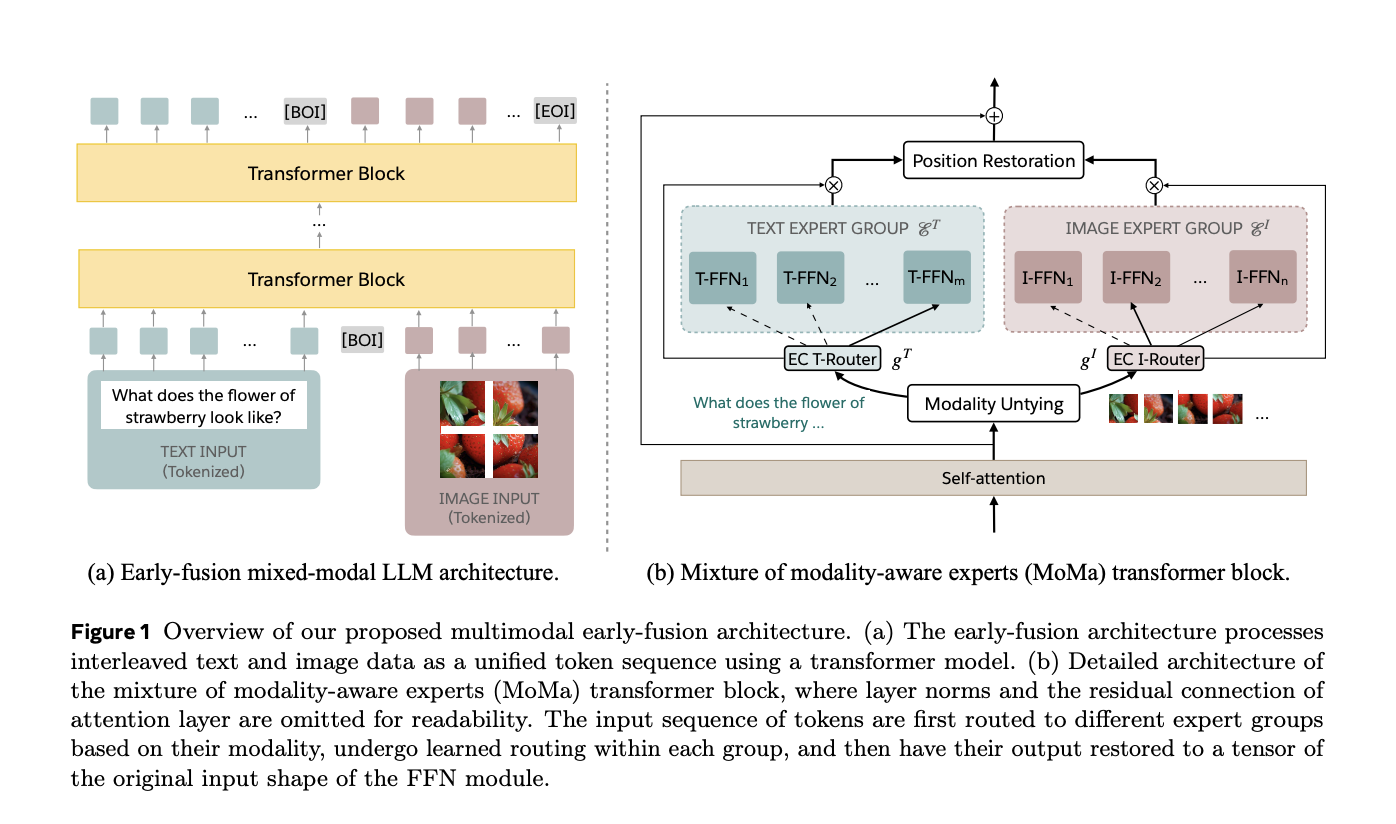

Решение от Meta: MoMa

Для решения этих проблем исследователи в Meta представили MoMa — новую архитектуру смешивания экспертов, осведомленных о модальности (MoE), предназначенную для предварительного обучения смешанных модальных языковых моделей с ранним слиянием. MoMa обрабатывает текст и изображения в произвольной последовательности, разделяя экспертные модули на модально-специфические группы. Каждая группа исключительно обрабатывает определенные токены, используя изученное маршрутизирование внутри каждой группы для поддержания семантически информированной адаптивности. Эта архитектура значительно улучшает эффективность предварительного обучения, что подтверждается значительными результатами. Исследование, проведенное командой в Meta, демонстрирует потенциал MoMa для развития смешанных модальных языковых моделей.

Технология MoMa

Технология MoMa включает в себя комбинацию методик смешивания экспертов (MoE) и смешивания глубин (MoD). В MoE токены маршрутизируются через набор блоков прямого распространения (экспертов) на каждом уровне. Эксперты разделены на группы, специфичные для текста и изображений, что позволяет использовать специализированные пути обработки. Этот подход, называемый осведомленной о модальности разреженностью, улучшает способность модели улавливать особенности, специфичные для каждой модальности, сохраняя при этом интеграцию между модальностями через общие механизмы самовнимания. Кроме того, MoD позволяет токенам выбирать пропускать вычисления на определенных уровнях, что дополнительно оптимизирует эффективность обработки.

Результаты и потенциал MoMa

Эффективность MoMa была широко оценена, показав значительное улучшение эффективности и эффективности. При бюджете обучения 1 триллион токенов модель MoMa 1.4B, включающая 4 текстовых эксперта и 4 изображения эксперта, достигла общего снижения операций с плавающей запятой в секунду (FLOPs) в 3,7 раза по сравнению с плотной базовой моделью. В частности, для текста было достигнуто снижение в 2,6 раза, а для обработки изображений — в 5,2 раза. При совмещении с MoD общие сбережения FLOPs увеличились до 4,2 раза, с улучшением обработки текста на 3,4 раза и обработки изображений на 5,3 раза. Эти результаты подчеркивают потенциал MoMa для значительного улучшения эффективности предварительного обучения смешанных модальных языковых моделей с ранним слиянием.

Инновационная архитектура MoMa

Инновационная архитектура MoMa представляет собой значительное развитие в области мультимодального ИИ. Интегрируя модально-специфических экспертов и продвинутые техники маршрутизации, исследователи разработали более ресурсоэффективную модель ИИ, которая поддерживает высокую производительность в различных задачах. Это инновационное решение решает критические проблемы вычислительной эффективности, открывая путь к разработке более способных и ресурсоэффективных систем мультимодального ИИ. Работа команды демонстрирует потенциал для будущих исследований на основе этих основ, исследуя более сложные механизмы маршрутизации и расширяя подход к дополнительным модальностям и задачам.

Выводы

Архитектура MoMa, разработанная исследователями Meta, предлагает многообещающее решение для вычислительных вызовов в мультимодальном ИИ. Подход использует методики смешивания экспертов, осведомленных о модальности, и смешивания глубин для достижения значительных выгод в эффективности, сохраняя при этом надежную производительность. Этот прорыв открывает путь к следующему поколению моделей мультимодального ИИ, способных обрабатывать и интегрировать различные типы данных более эффективно и эффективно, улучшая способность ИИ понимать и взаимодействовать с сложным мультимодальным миром, в котором мы живем.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашему Telegram-каналу и группе в LinkedIn. Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему 47k+ ML SubReddit.

Найдите предстоящие вебинары по ИИ здесь.

Arcee AI выпустила DistillKit: открытый и простой в использовании инструмент для трансформации модельного сгущения для создания эффективных, высокопроизводительных малых языковых моделей.

Эта статья о MoMa от Meta FAIR представляет собой важный шаг в развитии мультимодального ИИ. Подход использует модально-специфических экспертов и продвинутые техники маршрутизации, что позволяет разработать более ресурсоэффективную модель ИИ, поддерживающую высокую производительность в различных задачах. Это открытие устраняет критические проблемы вычислительной эффективности, открывая путь к разработке более способных и ресурсоэффективных систем мультимодального ИИ. Работа команды демонстрирует потенциал для будущих исследований на основе этих основ, исследуя более сложные механизмы маршрутизации и расширяя подход к дополнительным модальностям и задачам.

«`