«`html

Zamba2-2.7B: Новый уровень эффективности и производительности в мире малых языковых моделей

Zyphra выпустила Zamba2-2.7B, что является важным моментом в развитии малых языковых моделей, демонстрируя значительный прогресс в эффективности и производительности. Модель обучена на обширном наборе данных, состоящем примерно из 3 триллионов токенов, что позволяет ей достичь производительности аналогичной более крупным моделям, таким как Zamba1-7B, при этом значительно снижая требования к ресурсам для вывода, делая ее высокоэффективным решением для приложений на устройствах.

Улучшение времени до первого токена

Модель достигает двукратного улучшения времени до первого токена, что является критическим показателем для приложений, требующих взаимодействия в реальном времени. Это улучшение означает, что Zamba2-2.7B может генерировать начальные ответы вдвое быстрее своих конкурентов. Это критически важно для приложений, таких как виртуальные ассистенты, чат-боты и другие реактивные системы искусственного интеллекта, где быстрое время отклика является ключевым.

Эффективное использование памяти

Помимо скорости, Zamba2-2.7B разработана для более эффективного использования памяти. Она снижает издержки памяти на 27%, что делает ее подходящим вариантом для развертывания на устройствах с ограниченными ресурсами памяти. Это более умное использование памяти обеспечивает эффективную работу модели даже в условиях ограниченных вычислительных ресурсов, расширяя ее применимость на различных устройствах и платформах.

Снижение задержки генерации

Модель обеспечивает снижение задержки на 1,29 раза по сравнению с Phi3-3.8B, что улучшает плавность и непрерывность взаимодействий. Снижение задержки особенно важно для приложений, требующих бесперебойного общения, таких как боты для обслуживания клиентов и интерактивные образовательные инструменты. Поддержание высокой производительности при сниженной задержке позиционирует Zamba2-2.7B как ведущий выбор для разработчиков, стремящихся улучшить пользовательский опыт в своих приложениях на основе искусственного интеллекта.

Превосходная производительность

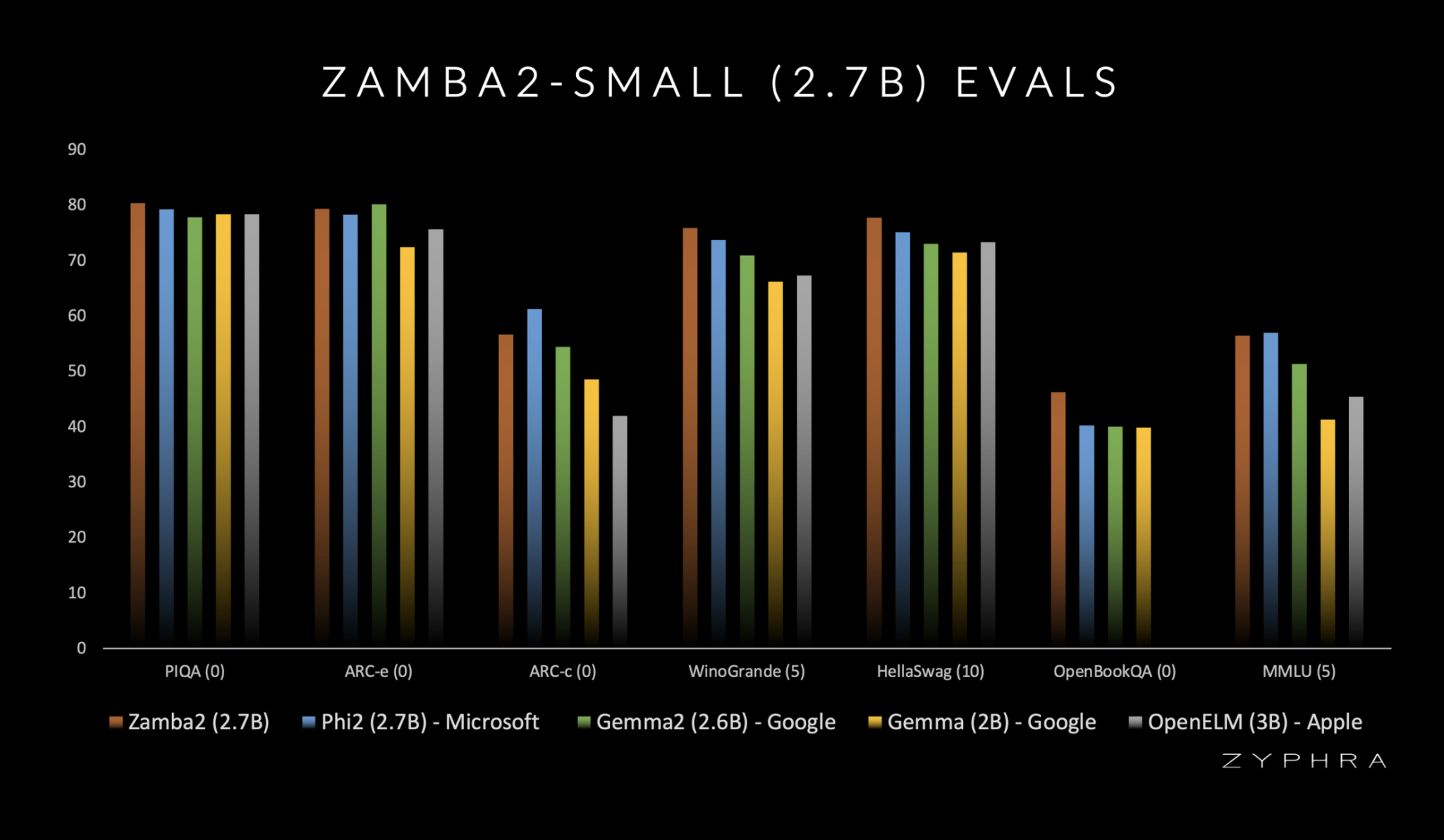

Сравнения показывают превосходную производительность Zamba2-2.7B по сравнению с другими моделями аналогичного масштаба. При сравнении с Gemma2-2.7B, StableLM-3B и Phi2-2.7B, Zamba2-2.7B последовательно превосходит своих конкурентов. Эта превосходная производительность свидетельствует о инновационном подходе Zyphra и преданности развитию технологий искусственного интеллекта. Обязательство компании к потенциалу малых языковых моделей явно проявляется в впечатляющих возможностях Zamba2-2.7B.

Улучшенная архитектура

Модель использует улучшенную схему внимания с общими блоками MLP и проекторами LoRA. Эта передовая архитектура позволяет модели более эффективно решать сложные задачи, обеспечивая высококачественные результаты с минимальными задержками. Переход от блоков Mamba1 к блокам Mamba2 дополнительно улучшает производительность модели, обеспечивая прочную основу для ее продвинутых возможностей. Эти инновации способствуют способности модели предоставлять более быстрые, более умные и более эффективные решения искусственного интеллекта.

Заключение

Выпуск Zamba2-2.7B от Zyphra является важным этапом в развитии малых языковых моделей. Объединяя высокую производительность с сниженной задержкой и эффективным использованием памяти, Zamba2-2.7B устанавливает новый стандарт для приложений искусственного интеллекта на устройствах. Модель соответствует и превосходит ожидания от малых языковых моделей, предлагая надежное решение для разработчиков и компаний, стремящихся интегрировать сложные возможности искусственного интеллекта в свои продукты.

Подробности и модель можно найти здесь.

Вся заслуга за это исследование принадлежит исследователям этого проекта.

Не забудьте подписаться на наш Twitter и присоединиться к нашему Telegram-каналу и группе в LinkedIn. Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему 47k+ ML SubReddit.

Найдите предстоящие вебинары по искусственному интеллекту здесь.

Оригинальная статья: Zamba2-2.7B Released: A State-of-the-Art Small Language Model Achieving Twice the Speed and 27% Reduced Memory Overhead.

«`

![Как написать предложение о партнерстве [Примеры + Шаблон]](https://saile.ru/wp-content/uploads/2025/04/itinai.com_beautiful_Russian_high_fashion_Sales_representativ_1842ca81-1c46-4a4f-a47a-e39d13635ca8_2-200x200.png)