«`html

Symflower Launches DevQualityEval: A New Benchmark for Enhancing Code Quality in Large Language Models

Symflower недавно представила DevQualityEval — инновационный бенчмарк и фреймворк, разработанный для повышения качества кода, генерируемого большими моделями языка (LLM). Этот релиз позволит разработчикам оценить и улучшить возможности LLM в реальных сценариях разработки программного обеспечения.

Основные особенности DevQualityEval:

- Стандартизированная оценка: DevQualityEval предлагает согласованный и повторяемый способ оценки LLM, что упрощает сравнение различных моделей и отслеживание улучшений со временем.

- Фокус на задачи реального мира: бенчмарк включает задачи, представляющие собой реальные программные вызовы. Это включает генерацию модульных тестов для различных языков программирования и тестирование моделей на практических и актуальных сценариях.

- Подробные метрики: фреймворк предоставляет глубокие метрики, такие как проценты компиляции кода, проценты покрытия тестами и качественные оценки стиля и корректности кода. Эти метрики помогают разработчикам понять сильные и слабые стороны различных LLM.

- Расширяемость: DevQualityEval разработан с возможностью расширения, позволяя разработчикам добавлять новые задачи, языки и критерии оценки. Эта гибкость гарантирует, что бенчмарк может развиваться наряду с достижениями в области ИИ и разработки программного обеспечения.

Установка и использование DevQualityEval просты. Разработчики должны установить Git и Go, клонировать репозиторий и выполнить установочные команды. Затем бенчмарк можно выполнить с помощью двоичного файла ‘eval-dev-quality’, который генерирует подробные журналы и результаты оценки.

DevQualityEval оценивает модели на основе их способности точно и эффективно решать программные задачи. Баллы присуждаются за различные критерии, включая отсутствие ошибок ответа, наличие исполнимого кода и достижение 100% покрытия тестами. Например, генерация набора тестов, который компилируется и охватывает все инструкции кода, приводит к более высоким баллам.

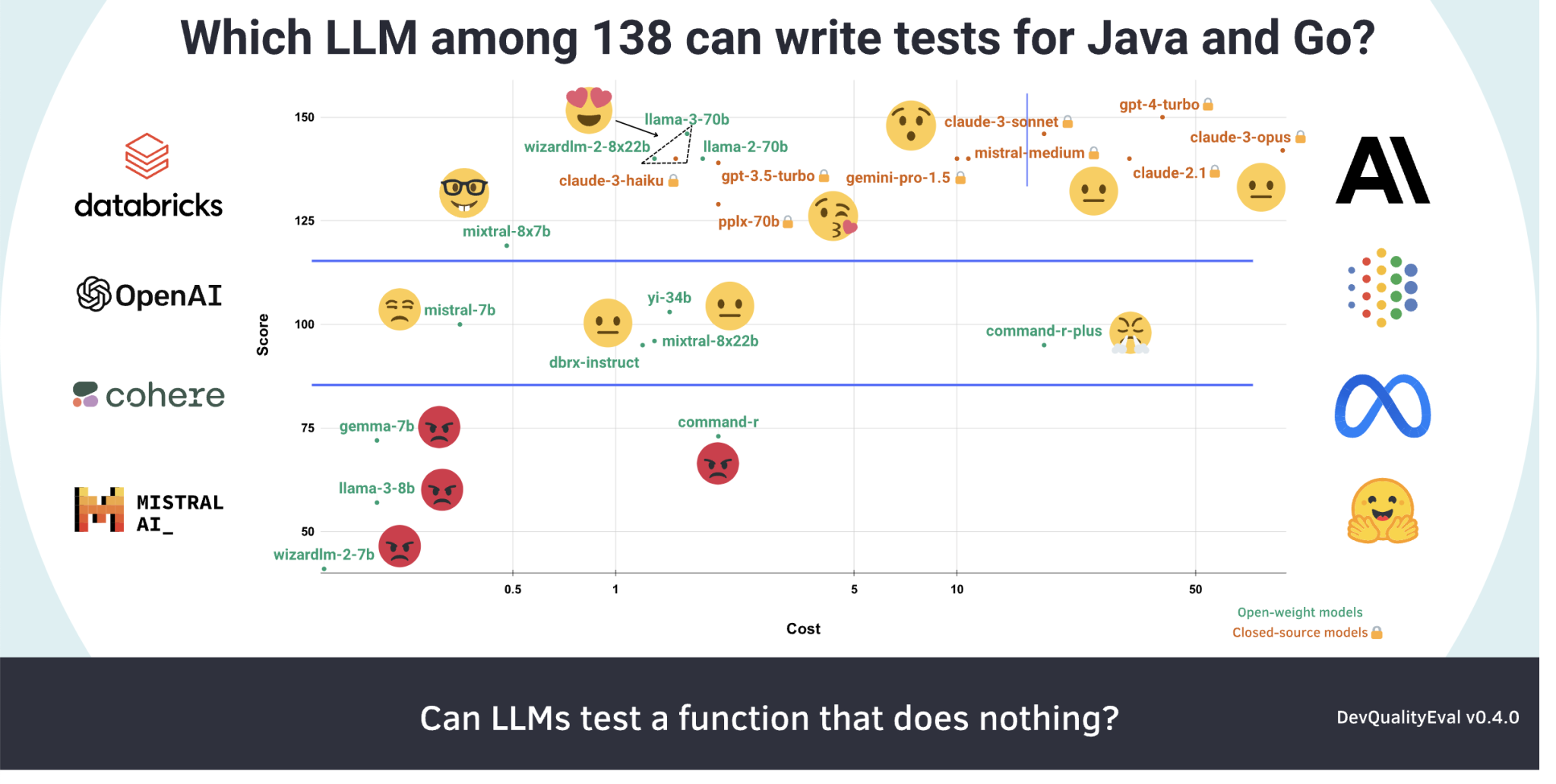

Один из ключевых моментов DevQualityEval — его способность предоставлять сравнительные исследования производительности ведущих LLM. Например, недавние оценки показали, что, хотя GPT-4 Turbo обладает превосходными возможностями, Llama-3 70B значительно более экономичен. Эти исследования помогают пользователям принимать обоснованные решения в соответствии с их требованиями и бюджетными ограничениями.

В заключение, DevQualityEval от Symflower готов стать неотъемлемым инструментом для разработчиков ИИ и программных инженеров. Предоставление строгого и расширяемого фреймворка для оценки качества генерации кода дает сообществу возможность преодолевать границы того, что могут достичь LLM в разработке программного обеспечения.

Проверьте страницу GitHub и блог. Вся заслуга за этот проект принадлежит исследователям. Также не забудьте подписаться на нас в Twitter. Присоединяйтесь к нашему каналу в Telegram, каналу в Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему подпункту ML. Также загляните на нашу платформу событий по ИИ.

Источник: MarkTechPost

«`