«`html

Преимущества SimPO для оптимизации предпочтений в обучении с подкреплением

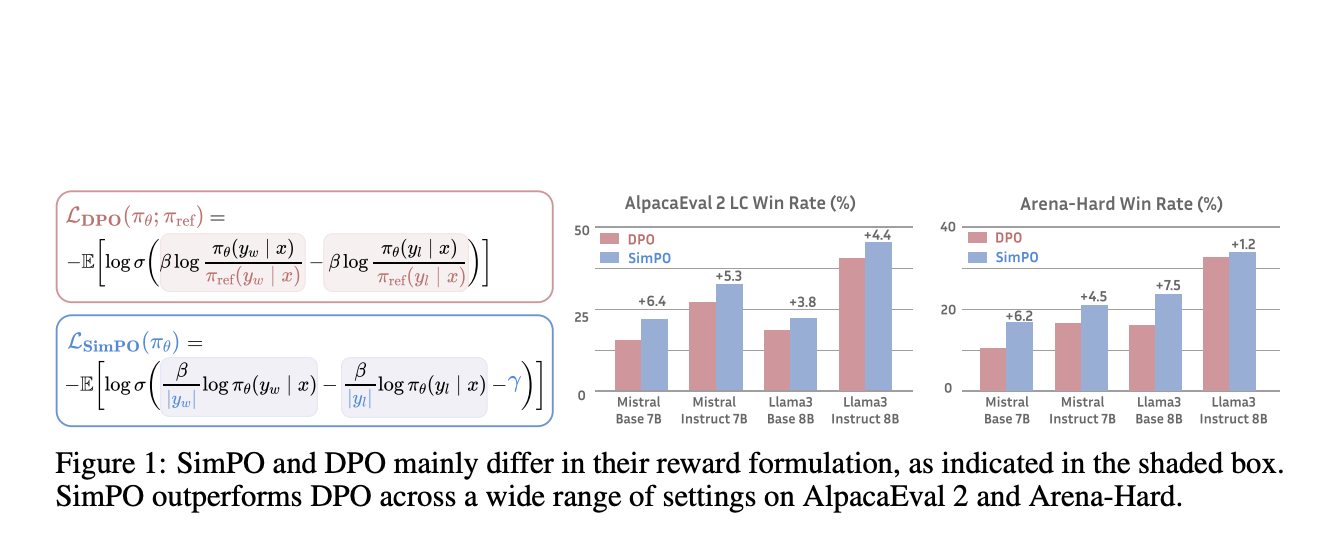

Искусственный интеллект продолжает развиваться, сосредотачиваясь на оптимизации алгоритмов для улучшения производительности и эффективности больших языковых моделей (LLM). Одной из основных проблем в этой области является оптимизация функций вознаграждения, используемых в обучении с подкреплением. Традиционные методы включают сложные многоэтапные процессы, требующие значительных вычислительных ресурсов и могут привести к субоптимальной производительности из-за расхождений между метриками обучения и вывода. Существующие исследования включают методы, такие как DPO, IPO, KTO и ORPO, которые предлагают вариации обработки данных предпочтений и оптимизации без ссылочных моделей.

SimPO: простое и эффективное решение

Исследователи из Университета Вирджинии и Принстонского университета представили SimPO, более простой и эффективный подход к оптимизации предпочтений. SimPO использует среднюю логарифмическую вероятность последовательности в качестве неявного вознаграждения, лучше соответствуя генерации модели и устраняя необходимость в ссылочной модели. Метод также включает целевую границу вознаграждения для обеспечения значительной разницы между победными и проигрышными ответами, что улучшает стабильность производительности.

Ядро инновации SimPO заключается в использовании нормализованного по длине вознаграждения, рассчитанного как средняя логарифмическая вероятность всех токенов в ответе. Этот подход обеспечивает соответствие вознаграждения метрике генерации, улучшая производительность модели. Кроме того, SimPO вводит целевую границу вознаграждения для цели Bradley-Terry для поощрения большей разницы между победными и проигрышными ответами.

Преимущества SimPO

SimPO значительно превосходит DPO и его последние варианты на различных настройках обучения, включая базовые и инструкционные модели. На бенчмарке AlpacaEval 2 SimPO превзошел DPO на 6,4 пункта, продемонстрировав значительное улучшение в генерации точных и релевантных ответов. Также SimPO показал еще более впечатляющую производительность на сложном бенчмарке Arena-Hard, превзойдя DPO на 7,5 пункта. Топовая модель, построенная на Llama3-8B-Instruct, достигла замечательной длинно-контролируемой победной ставки на AlpacaEval 2, превзойдя Claude 3 Opus в рейтинге, и 33,8% победной ставки на Arena-Hard, что делает ее самой мощной 8B моделью с открытым исходным кодом на сегодняшний день.

Практичность SimPO заключается в эффективном использовании данных предпочтений, что приводит к более точному ранжированию вероятности победы и поражения на проверочном наборе. Это переводится в лучшую модель политики, способную последовательно генерировать качественные ответы. Эффективность SimPO также проявляется в его вычислительных требованиях, снижая необходимость в обширных вычислительных ресурсах.

В заключение, SimPO представляет собой значительное достижение в оптимизации предпочтений для обучения с подкреплением, предлагая более простой и эффективный метод, который последовательно обеспечивает превосходную производительность. Внедрение целевой границы вознаграждения также гарантирует, что сгенерированные ответы не только релевантны, но также высокого качества, делая SimPO ценным инструментом для будущих разработок в области искусственного интеллекта.

Проверьте статью и GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter. Присоединяйтесь к нашему Telegram-каналу, Discord-каналу и группе LinkedIn.

Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему 43k+ ML SubReddit | Также, ознакомьтесь с нашей платформой AI Events.

Источник: MarkTechPost

«`