«`html

Alibaba представила Qwen2-VL: новейшую версию моделей языка и зрения на основе Qwen2 в семействе моделей Qwen

Исследователи из Alibaba объявили о выпуске Qwen2-VL, последней версии моделей языка и зрения на основе Qwen2 в семействе моделей Qwen. Эта новая версия представляет собой значительный прорыв в мультимодальных возможностях искусственного интеллекта, продолжая фундамент, заложенный предшественником Qwen-VL. Продвижения в Qwen2-VL открывают захватывающие возможности для широкого спектра приложений в области визуального понимания и взаимодействия, после года интенсивных разработок.

Источник изображения: https://qwenlm.github.io/blog/qwen2-vl/

Исследователи оценили визуальные возможности Qwen2-VL по шести ключевым измерениям: решение сложных задач уровня колледжа, математические способности, понимание документов и таблиц, мультиязычное понимание текста и изображения, ответы на общие сценарии, понимание видео и взаимодействие на основе агентов. Модель 72B продемонстрировала высочайшую производительность по большинству метрик, зачастую превосходя даже закрытые модели типа GPT-4V и Claude 3.5-Sonnet. Особенно Qwen2-VL проявила значительное преимущество в понимании документов, подчеркивая свою универсальность и продвинутые возможности обработки визуальной информации.

Источник изображения: https://qwenlm.github.io/blog/qwen2-vl/

Новая модель масштаба 7B Qwen2-VL сохраняет поддержку входных данных изображений, нескольких изображений и видео, обеспечивая конкурентоспособную производительность в более экономичном размере. Эта версия отличается в задачах понимания документов, что подтверждается результатами на бенчмарке DocVQA. Кроме того, модель проявляет впечатляющие возможности в мультиязычном понимании текста с изображений, достигая передовой производительности на бенчмарке MTVQA. Эти достижения подчеркивают эффективность модели и ее универсальность в различных визуальных и лингвистических задачах.

Источник изображения: https://qwenlm.github.io/blog/qwen2-vl/

Также была представлена новая компактная модель Qwen2-VL масштаба 2B, оптимизированная для потенциального развертывания на мобильных устройствах. Несмотря на свои небольшие размеры, эта версия проявляет высокую производительность в области понимания изображений, видео и мультиязычного понимания. Модель 2B особенно отличается в задачах, связанных с видео, понимании документов и ответах на общие сценарии по сравнению с другими моделями сходного масштаба. Это развитие показывает способность исследователей создавать эффективные и производительные модели, подходящие для ресурсоемких сред.

Источник изображения: https://qwenlm.github.io/blog/qwen2-vl/

Qwen2-VL вносит существенные улучшения в распознавание объектов, включая сложные многокомпонентные отношения и улучшенное распознавание рукописного текста и мультиязычное распознавание. Математические и кодировочные навыки модели были значительно улучшены, что позволяет ей решать сложные задачи анализа диаграмм и интерпретации искаженных изображений. Извлечение информации из изображений реального мира и диаграмм было усилено, а также улучшены возможности следования инструкциям. Кроме того, Qwen2-VL теперь отличается в анализе видеоконтента, предлагая резюмирование, ответы на вопросы и возможности реального времени. Эти усовершенствования позиционируют Qwen2-VL как универсального визуального агента, способного связывать абстрактные концепции с практическими решениями в различных областях.

Источник изображения: https://qwenlm.github.io/blog/qwen2-vl/

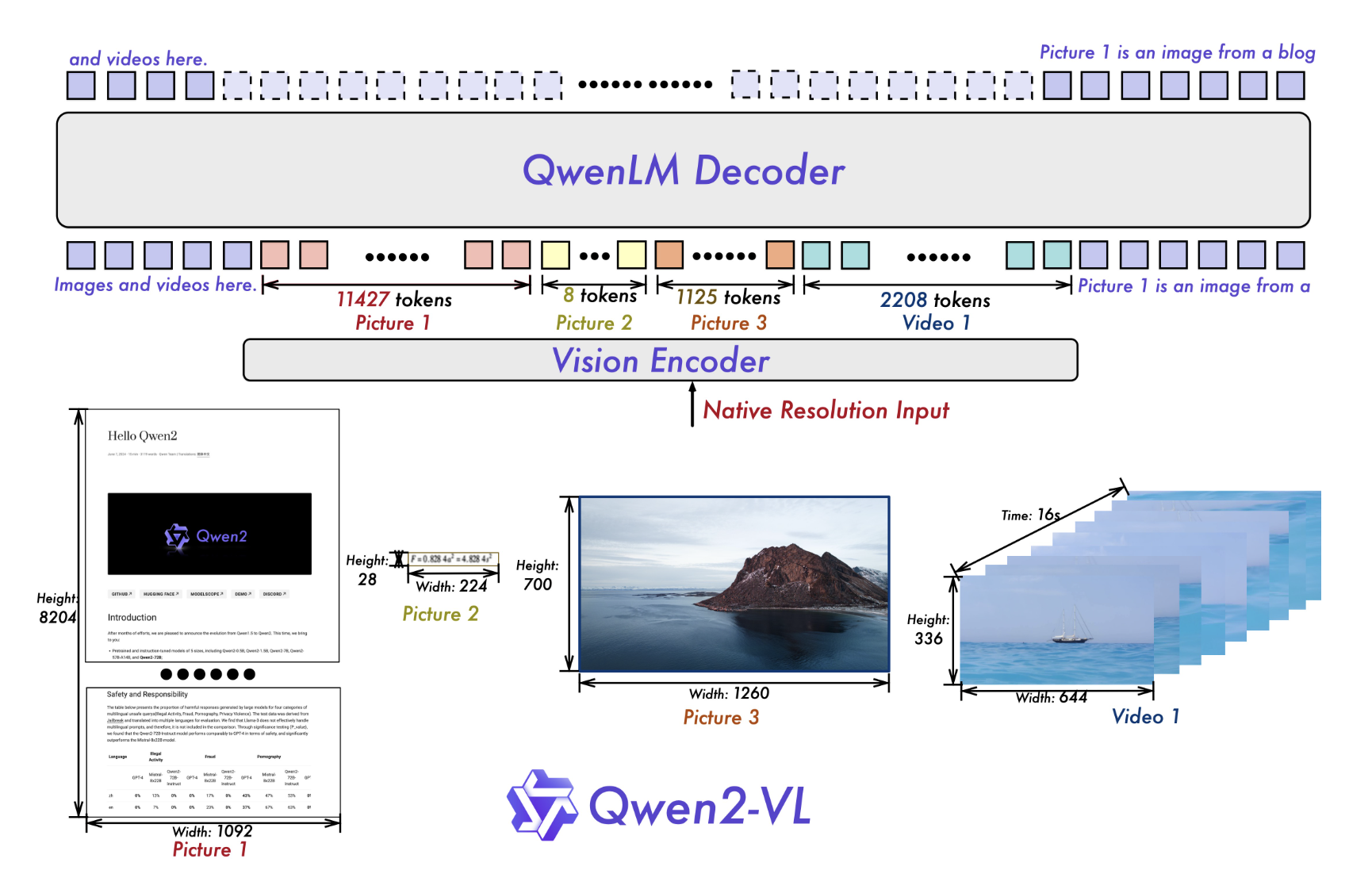

Исследователи сохраняют архитектуру Qwen-VL для Qwen2-VL, которая объединяет модель Vision Transformer (ViT) с моделями языка Qwen2. Все варианты используют ViT с приблизительно 600 миллионами параметров, способными обрабатывать как изображения, так и видео. Ключевые улучшения включают в себя реализацию поддержки Naive Dynamic Resolution, позволяющую модели обрабатывать произвольные разрешения изображений путем отображения их в динамическое количество визуальных токенов. Этот подход более точно имитирует визуальное восприятие человека. Кроме того, инновация Multimodal Rotary Position Embedding (M-ROPE) позволяет модели одновременно захватывать и интегрировать 1D текстовую, 2D визуальную и 3D видео позиционную информацию.

Источник изображения: https://qwenlm.github.io/blog/qwen2-vl/

Alibaba представила Qwen2-VL, последнюю модель языка и зрения в семействе Qwen, улучшая мультимодальные возможности искусственного интеллекта. Доступные в версиях 72B, 7B и 2B, Qwen2-VL отличается в решении сложных задач, понимании документов, мультиязычном понимании текста и изображений, и анализе видео, часто превосходя модели, такие как GPT-4V. Ключевые инновации включают улучшенное распознавание объектов, улучшенные математические и кодировочные навыки, и способность решать сложные визуальные задачи. Модель интегрирует Vision Transformer с поддержкой Naive Dynamic Resolution и Multimodal Rotary Position Embedding, что делает ее универсальным и эффективным инструментом для различных приложений.

«`