Ускорение обработки больших моделей языка с помощью AI-решения Huawei Kangaroo

Разработки в области обработки естественного языка получили значительный толчок за счет прорывов в области больших моделей языка (LLM). Однако их эффективность сдерживает медленная скорость вывода, затрудняющая использование в реальном времени.

Основные проблемы и практичные решения

Современные методы, такие как Medusa и Lookahead, разработаны для улучшения спекулятивного декодирования. Однако они по-прежнему сталкиваются с проблемой задержки исполнения, так как модели требуют значительных вычислительных ресурсов и обновлений параметров.

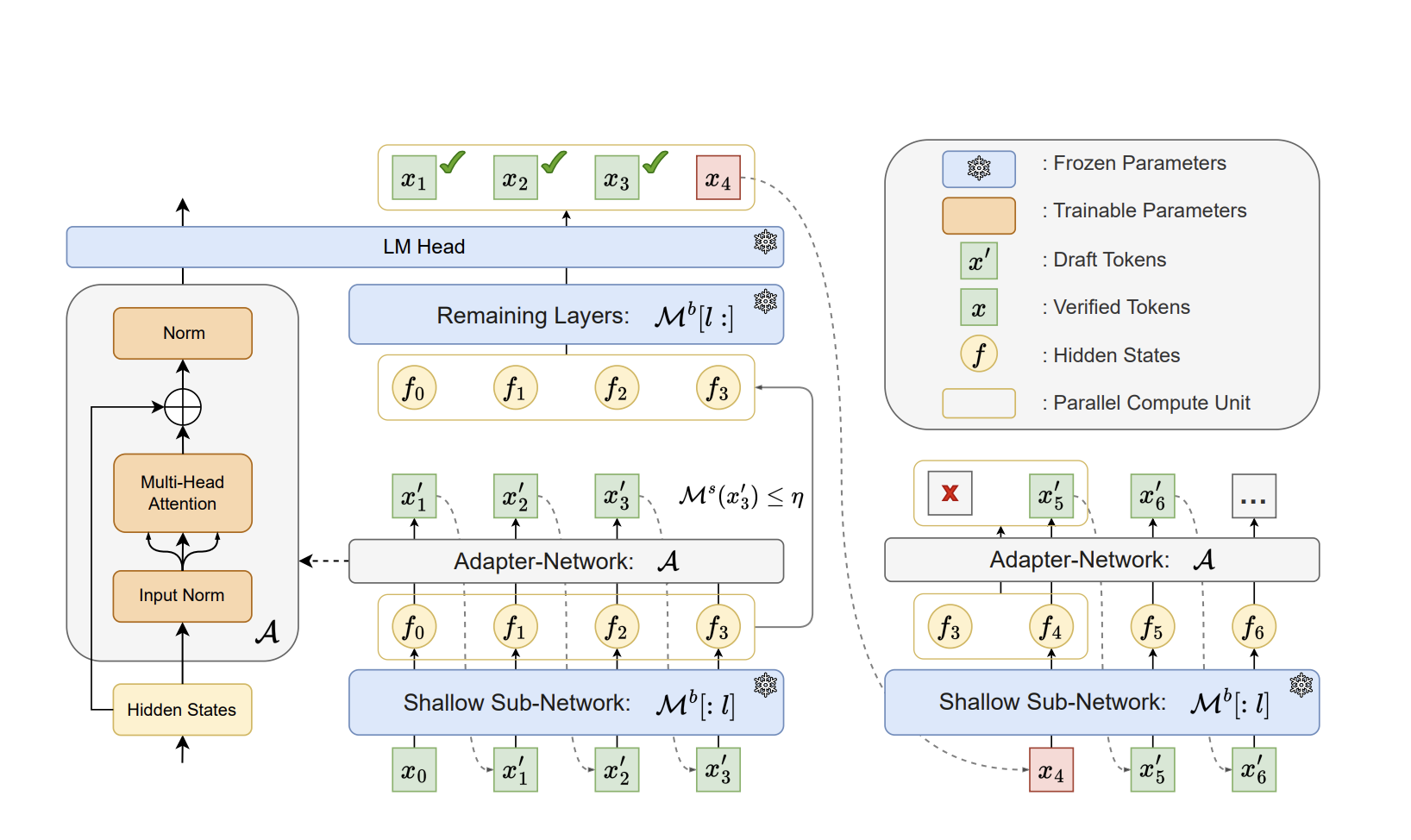

Исследователи Huawei Noah’s Ark Lab разработали инновационный фреймворк под названием Kangaroo, который решает проблему высокой задержки при спекулятивном декодировании. Kangaroo использует фиксированную поверхностную подсеть LLM в качестве модели-черновика и улучшает свою эффективность за счет встроенного механизма преждевременного завершения.

Эксперименты показывают, что Kangaroo позволяет ускорить процесс в 1,7 раза по сравнению с другими методами и снизить количество дополнительных параметров. Это открывает новые возможности для реального времени обработки естественного языка.

Заключение и практическая польза

Kangaroo представляет собой перспективное решение для ускорения вывода LLM, уменьшая задержку и не ущемляя точность. Это позволяет организациям эффективнее использовать большие языковые модели и создавать более отзывчивые и точные приложения обработки естественного языка.

Исследуйте нашу Paper and GitHub и не забудьте подписаться на нас в Twitter. Присоединяйтесь к нашему Telegram каналу и LinkedIn группе.

Обратитесь к нам для поддержки во внедрении ИИ-решений в ваш маркетинговый план через наш Telegram канал.

![13 способов, как ИИ может помочь вашему бизнесу [+ новые данные и подсказки по генеративному ИИ]](https://saile.ru/wp-content/uploads/2025/04/itinai.com_beautiful_Russian_high_fashion_Sales_representativ_a1922e6e-86c0-4f4f-ace3-d2864b5eacac_0-200x200.png)