«`html

Hex-LLM: Новый фреймворк для эффективного обслуживания открытых LLM на Google Cloud TPUs

В быстро развивающемся мире искусственного интеллекта большие языковые модели (LLM) стали важными инструментами для различных приложений, от понимания естественного языка до генерации контента. Однако эффективное использование и развертывание этих моделей остается вызовом, особенно в вопросах стоимости, производительности и задержки.

Преимущества Hex-LLM

Hex-LLM — это внутренний фреймворк обслуживания LLM от Vertex AI, оптимизированный для аппаратного обеспечения Google Cloud TPU. Он предлагает высокопроизводительное и недорогое решение для развертывания моделей с открытым исходным кодом. Hex-LLM выделяется благодаря своим передовым методам оптимизации, позволяющим эффективно обрабатывать большие объемы данных.

Ключевые особенности Hex-LLM

- Непрерывная пакетная обработка на основе токенов: Эффективное использование ресурсов TPU за счет обработки входящих токенов в непрерывном потоке, что значительно снижает стоимость обслуживания.

- Оптимизированные ядра PagedAttention: Использование XLA-оптимизированных ядер для минимизации задержки и вычислительной нагрузки, что обеспечивает низкую задержку вывода.

- Тензорный параллелизм: Распределение вычислений по нескольким ядрам TPU, что позволяет эффективно обслуживать большие модели.

- Динамические адаптеры LoRA и квантизация: Гибкая настройка моделей для конкретных задач без необходимости повторного обучения.

Интеграция с Hugging Face Hub

Hex-LLM напрямую интегрируется с Hugging Face Hub, что упрощает процесс развертывания моделей на Google TPUs. Пользователи могут быстро экспериментировать с различными LLM и внедрять их в производственные среды.

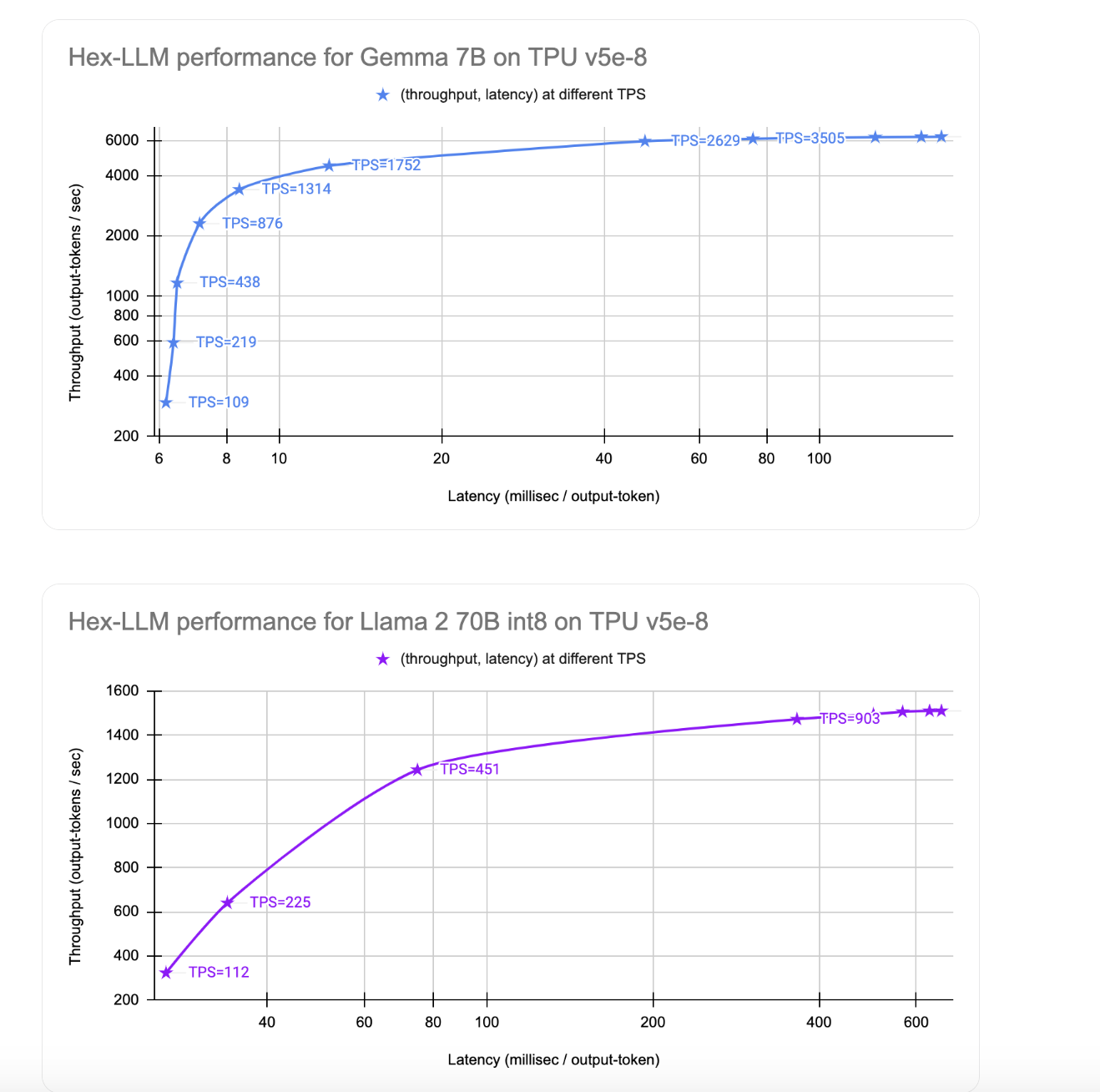

Показатели производительности: скорость и стоимость

Hex-LLM демонстрирует впечатляющую производительность, обеспечивая 1510 токенов вывода в секунду для Llama 2 70B с задержкой 26 миллисекунд на токен. Это делает его доступным для многих приложений.

Доступность в Vertex AI Model Garden

Hex-LLM доступен в Vertex AI Model Garden, что позволяет пользователям легко получать доступ и развертывать открытые LLM на TPUs без необходимости настройки инфраструктуры с нуля.

Заключение

Hex-LLM представляет собой значительный шаг вперед в эффективном обслуживании открытых LLM, предлагая мощное и экономически эффективное решение для развертывания моделей на Google TPUs. С такими функциями, как непрерывная пакетная обработка, оптимизированные ядра и интеграция с Hugging Face, Hex-LLM предоставляет пользователям возможность использовать мощь больших языковых моделей в своих приложениях.

Как использовать ИИ для развития бизнеса

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, грамотно используйте Hex-LLM.

- Проанализируйте, как ИИ может изменить вашу работу.

- Определите ключевые показатели эффективности (KPI), которые хотите улучшить с помощью ИИ.

- Подберите подходящее решение и внедряйте ИИ постепенно, начиная с малого проекта.

- На основе полученных данных расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам в Телеграм.

Попробуйте AI Sales Bot — это AI ассистент для продаж, который помогает отвечать на вопросы клиентов и генерировать контент для отдела продаж.

Узнайте, как ИИ может изменить процесс продаж в вашей компании с решением от saile.ru!

«`