«`html

Использование больших языковых моделей в ИИ: проблемы и решения

Большие языковые модели (LLM), такие как GPT-3 и Llama-2, имеют огромный потенциал в понимании и генерации человеческого языка. Однако их развертывание сталкивается с проблемой огромного объема вычислительных ресурсов. Это создает значительные вызовы, особенно в условиях ограниченных ресурсов.

Проблема развертывания больших языковых моделей

Основная проблема заключается в огромном размере моделей и соответствующей необходимости в обширной вычислительной мощности и памяти. Это существенно ограничивает их использование в ситуациях с ограниченными вычислительными ресурсами.

Решение: FLEXTRON

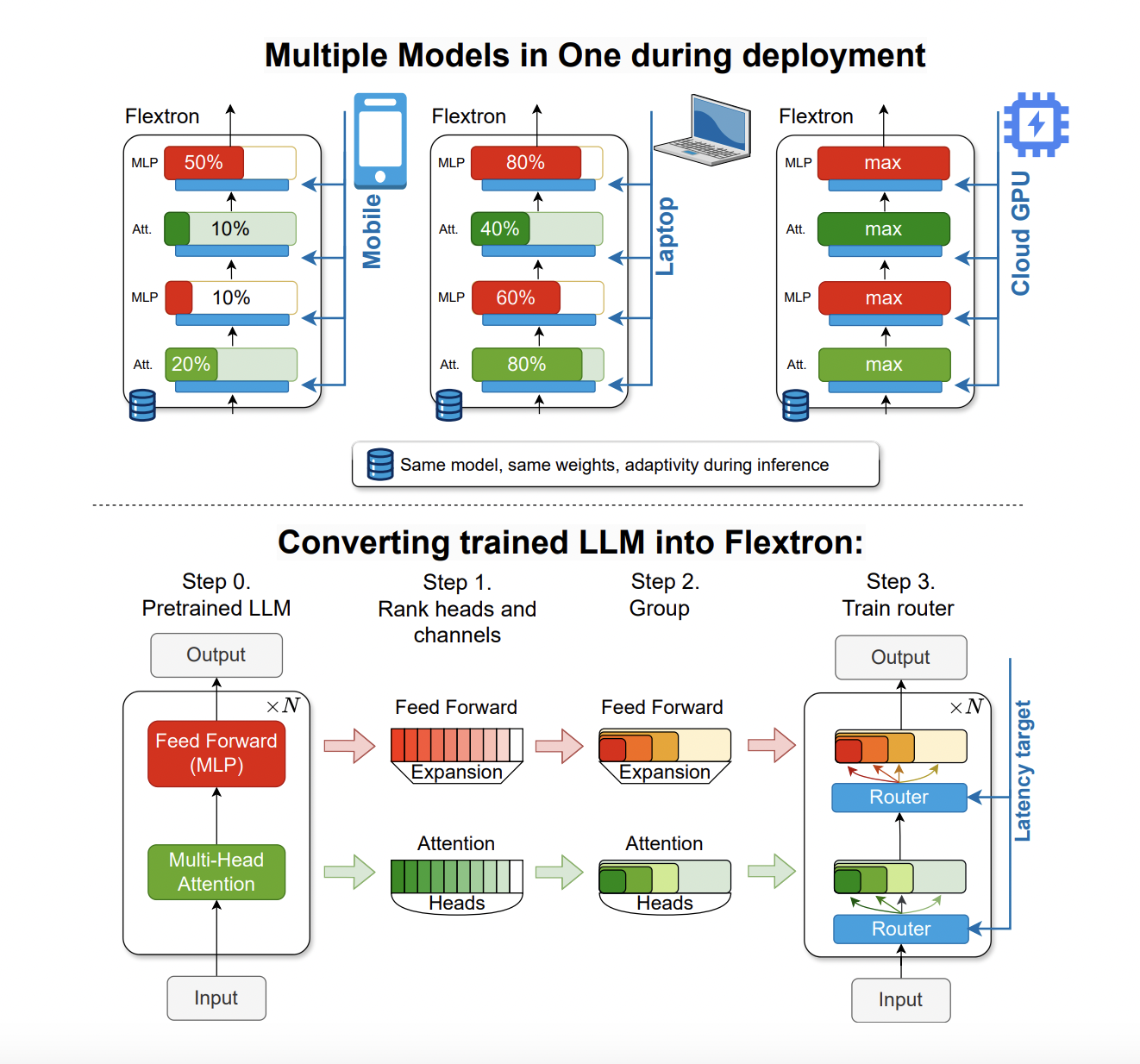

Исследователи из NVIDIA и Университета Техаса в Остине представили FLEXTRON — новую архитектуру гибкой модели и фреймворк оптимизации после обучения. FLEXTRON позволяет адаптировать модель к различным сценариям развертывания, не требуя дополнительной настройки, тем самым решая проблемы традиционных методов.

Эффективность FLEXTRON подтверждена в сравнении с другими моделями, такими как GPT-3 и семейство моделей Llama-2. Оценки показали, что FLEXTRON требует всего 7,63% обучающих токенов, используемых в исходном предварительном обучении, что приводит к существенной экономии вычислительных ресурсов и времени.

Применение в бизнесе

Использование FLEXTRON позволяет оптимизировать использование ресурсов и повысить производительность моделей ИИ, что особенно важно в различных вычислительных средах.

Если вы хотите узнать, как внедрить ИИ в ваш бизнес, свяжитесь с нами на Telegram или следите за новостями в нашем Телеграм-канале или в Twitter @itinairu45358.

Попробуйте AI Sales Bot здесь и узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru.

«`

![Искусственный интеллект в платежах: как бренды уже используют AI в торговле [+Примеры]](https://saile.ru/wp-content/uploads/2025/04/itinai.com_beautiful_Russian_high_fashion_Sales_representativ_0edfe09d-3b43-4794-add3-7ea2d8b87dbc_1-200x200.png)