«`html

Оценка больших языковых моделей (LLM)

Оценка больших языковых моделей (LLM) становится все более сложной из-за их сложности и универсальности. Обеспечение надежности и качества результатов этих моделей имеет решающее значение для развития технологий и приложений искусственного интеллекта (ИИ). Исследователям нужна помощь в разработке надежных методов оценки для оценки точности и беспристрастности результатов LLM, учитывая субъективность, неоднородность и высокую стоимость человеческих оценок.

Текущие методы оценки

Текущие методы оценки, такие как BLEU и ROUGE, в основном сосредоточены на лексических совпадениях и не улавливают тонкости качества результатов LLM. Хотя недавние методы использовали предварительно обученные модели для измерения дистрибутивной схожести и вероятностей токенов, эти подходы все еще нуждаются в пересмотре в обобщаемости и последовательности. Высокая стоимость и время, необходимое для человеческих оценок, дополнительно усложняют процесс, что делает его непрактичным для масштабной оценки.

FLAMe: надежная оценка LLM

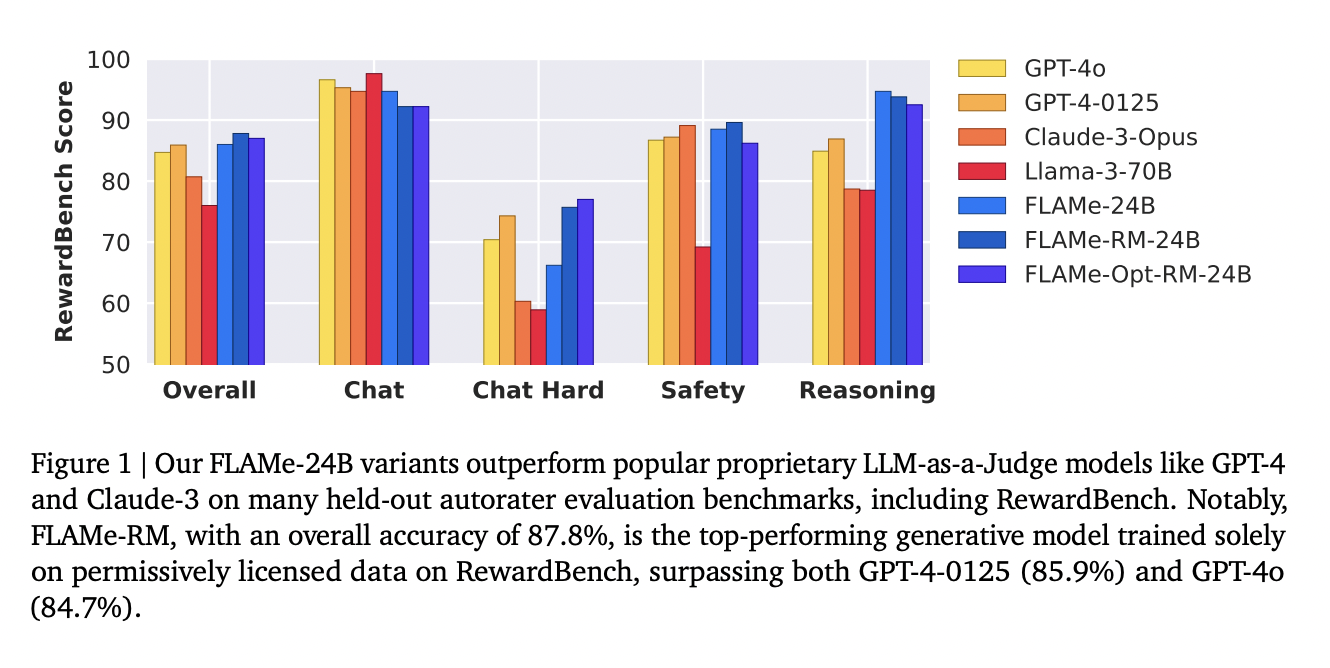

Команда исследователей из Google DeepMind, Google и UMass Amherst представила FLAMe — семейство моделей Foundational Large Autorater, разработанных для улучшения оценки LLM. FLAMe использует большой и разнообразный набор задач оценки качества, производных от человеческих суждений, для обучения и стандартизации авторейтеров. FLAMe обучается с применением мультитасковой настройки на более чем 100 задачах оценки качества, охватывающих более 5 миллионов человеческих оценок. Этот подход позволяет FLAMe обобщаться на новые задачи, превосходя существующие модели, такие как GPT-4 и Claude-3.

Узнайте больше в статье. Кредит за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему каналу в Telegram и группе в LinkedIn.

Если вам понравилась наша работа, вам понравится наш рассылка.

Не забудьте присоединиться к нашему SubReddit по ИИ с более чем 46 тысячами подписчиков.

«`