«`html

Потребность в обновлении знаний LLM

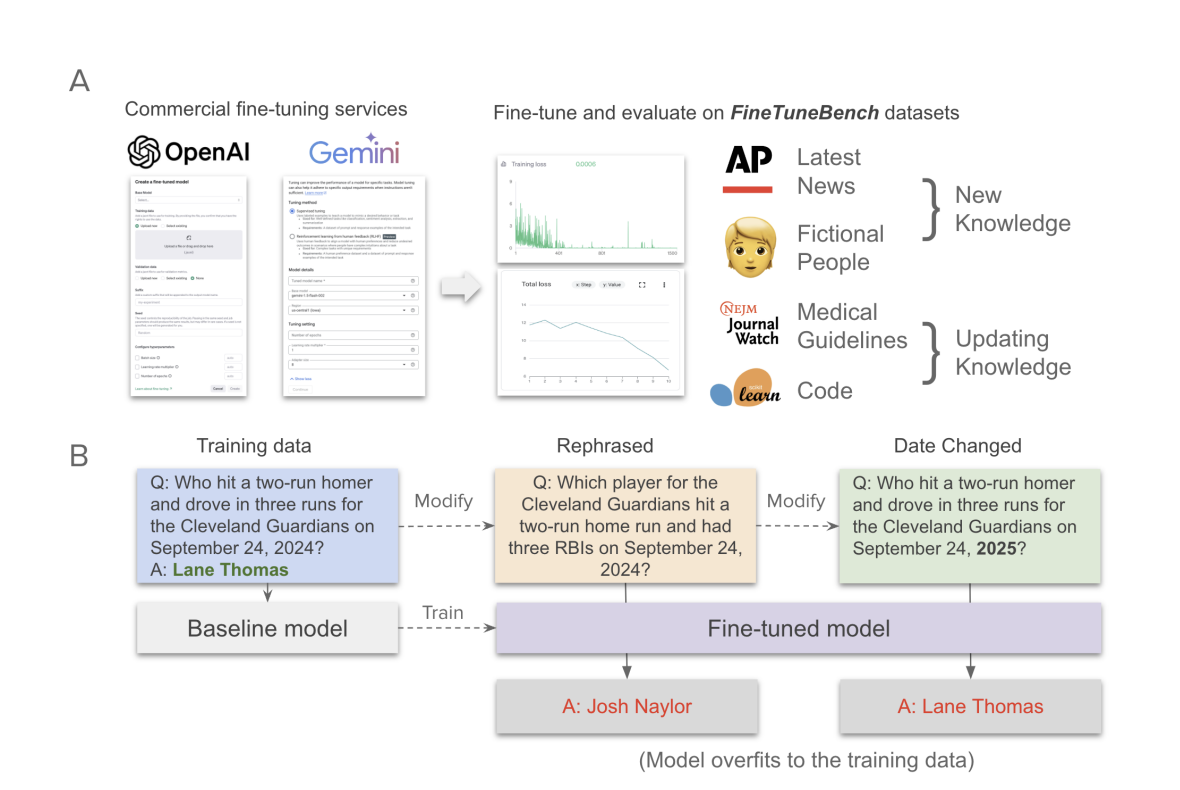

Спрос на настройку LLM (моделей с большим языковым контекстом) для включения новой информации и обновления существующих знаний растет. Компании, такие как OpenAI и Google, предлагают API для настройки LLM, но их эффективность в обновлении знаний еще не определена.

Практические решения и ценность

Модели LLM, используемые в таких областях, как программное обеспечение и медицина, требуют актуальной и специфической информации. Например, разработчики программного обеспечения нуждаются в обновленных моделях с последними кодами, а в здравоохранении необходима соблюдение современных рекомендаций.

Хотя услуги настройки предлагают возможность адаптировать закрытые модели, отсутствует прозрачность в методах, а ограниченные параметры могут снизить качество обновления знаний. Не существует стандартных методик для оценки этих возможностей.

Методы изменения поведения LLM

Существующие методы изменения поведения LLM включают SFT, RLHF и продолжительное предварительное обучение. Однако эффективность этих подходов для обновления знаний еще предстоит определить.

Метод RAG (генерация с использованием извлеченной информации) вводит знания в запросы, но модели часто игнорируют противоречивую информацию, что может приводить к неточностям.

Исследование Stanford University

Исследователи Стэнфордского университета разработали FineTuneBench, комплексную платформу для оценки того, как эффективно коммерческие API настройки LLM позволяют моделям включать новую и обновленную информацию.

В тестировании пяти продвинутых LLM, включая GPT-4o и Gemini 1.5 Pro, в двух сценариях – введение новой информации и обновление существующих знаний – было установлено, что успешность моделей была ограниченной.

Результаты тестирования

Модели показали в среднем только 37% точности в обучении новой информации и 19% в обновлении знаний. Модель GPT-4o mini показала наилучшие результаты, в то время как модели Gemini продемонстрировали минимальную способность к обновлению знаний.

Создание уникальных наборов данных

Для оценки способности настройки моделей к обучению новой информации исследователи создали два уникальных набора данных: Latest News Dataset и Fictional People Dataset.

Модели обучались на этих наборах с использованием различных методов, таких как маскирование ответов в запросах, для оптимизации производительности.

Ограничения текущих методов

Настройка моделей OpenAI показывает высокую запоминание, но ограниченную генерализацию для новых задач. Модели, такие как GPT-4o-mini, хорошо запоминают обученные пары вопросов и ответов, но испытывают трудности с переформулированными вопросами.

Внедрение ИИ в вашу компанию

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ), рассмотрите возможность использования FineTuneBench для оценки способности LLM к обновлению знаний.

Проанализируйте, как ИИ может изменить вашу работу. Определите ключевые показатели эффективности (KPI), которые вы хотите улучшить с помощью ИИ.

Выбирайте подходящее решение и внедряйте ИИ постепенно, начиная с небольших проектов и анализируя результаты.

Контакты и поддержка

Если вам нужны советы по внедрению ИИ, пишите нам. Следите за новостями об ИИ в нашем Телеграм-канале.

Попробуйте AI Sales Bot – это AI ассистент для продаж, который помогает отвечать на вопросы клиентов и генерировать контент для отдела продаж.

Узнайте, как ИИ может изменить процесс продаж в вашей компании!

«`