«`html

Введение

В последние годы языковые модели сталкиваются с необходимостью обработки все более длинных контекстов. Это создает проблемы в стандартных механизмах внимания, так как квадратичная сложность полного внимания начинает мешать работе с длинными последовательностями. В связи с этим, использование памяти и вычислительные затраты быстро растут, затрудняя практическое применение в многократных диалогах или сложных задачах рассуждения.

Решение от DeepSeek AI

Исследователи DeepSeek AI представляют NSA — механизм разреженного внимания, который быстро обучается и предназначен для обработки длинных контекстов. NSA сочетает алгоритмические новшества и оптимизации, совместимые с аппаратным обеспечением, что снижает вычислительные затраты. Он использует динамический иерархический подход, который включает сжатие токенов, выбор наиболее важных токенов и сохранение локального контекста.

Технические детали и преимущества

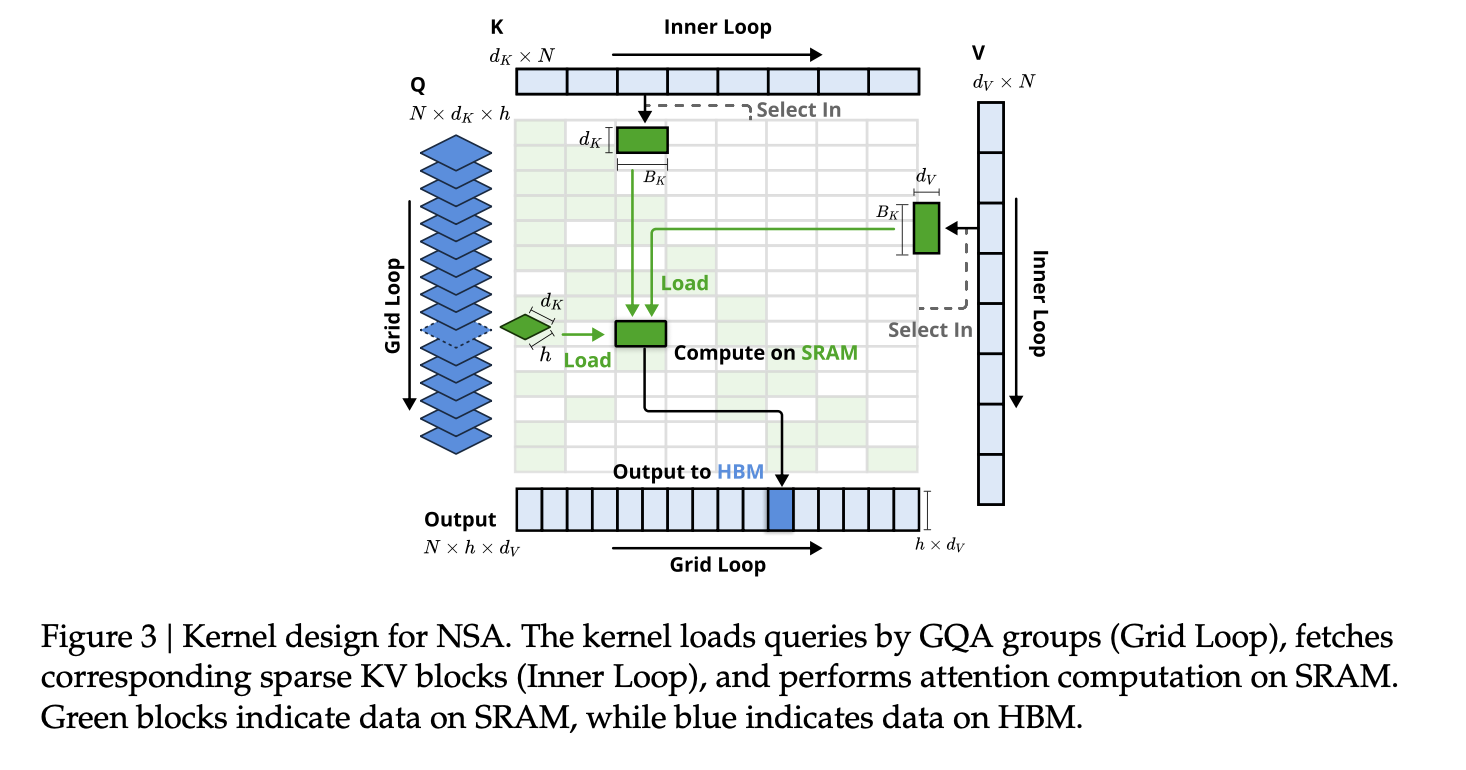

Архитектура NSA основывается на двух основных столпах: дизайне, учитывающем аппаратные ограничения, и алгоритме, удобном для обучения. Механизм сжатия использует многослойный перцептрон для агрегирования последовательных токенов, что позволяет захватывать высокоуровневые паттерны и снижать необходимость в полном разрешении обработки.

Ключевые компоненты NSA:

- Динамическая иерархическая стратегия разреженного внимания

- Сжатие токенов на грубом уровне

- Выбор токенов на тонком уровне

Результаты и выводы

NSA показывает высокую производительность на различных задачах и достигает результатов, сопоставимых с традиционными моделями полного внимания. Его иерархический дизайн позволяет эффективно обрабатывать длинные последовательности, сохраняя как глобальную, так и локальную точность.

Заключение

NSA представляет собой значительный шаг вперед в проектировании механизмов разреженного внимания. Его трехуровневый подход уменьшает вычислительные затраты и сохраняет важный контекст, благодаря чему ваш бизнес может эффективно использовать ИИ для улучшения процессов.

«`