«`html

Arcee AI анонсировала выпуск DistillKit: инновационного инструмента с открытым исходным кодом, разработанного для революционизации создания и распространения моделей малых языков (SLM).

DistillKit представляет собой проект с открытым исходным кодом, ориентированный на дистилляцию моделей, процесс, позволяющий передавать знания от крупных, ресурсоемких моделей к более компактным и эффективным. Этот инструмент направлен на снижение вычислительных ресурсов, необходимых для работы моделей и на расширение доступа к передовым возможностям искусственного интеллекта.

Введение в DistillKit

DistillKit создает более компактные модели, сохраняя при этом мощность и сложность крупных моделей, и оптимизированы для использования на менее мощных устройствах, таких как ноутбуки и смартфоны. Такой подход демократизирует доступ к передовым возможностям искусственного интеллекта и способствует энергоэффективности и экономии затрат при развертывании ИИ.

Методы дистилляции в DistillKit

DistillKit использует два основных метода передачи знаний: дистилляцию на основе логитов и дистилляцию на основе скрытых состояний.

Дистилляция на основе логитов: этот метод предполагает, что учительская модель (большая модель) передает свои вероятности вывода (логиты) модели ученика (более компактной модели). Модель ученика учится не только правильным ответам, но и уверенности учителя в своих предсказаниях. Эта техника улучшает способность модели ученика обобщать и эффективно выполнять задачи, имитируя распределение вывода модели учителя.

Дистилляция на основе скрытых состояний: модель ученика обучается воспроизводить промежуточные представления (скрытые состояния) модели учителя. Синхронизируя свое внутреннее обработка с моделью учителя, модель ученика получает более глубокое понимание данных. Этот метод полезен для дистилляции между моделями с различными токенизаторами.

Основные выводы DistillKit

Эксперименты и оценки производительности DistillKit позволяют сделать несколько ключевых выводов о его эффективности и потенциальных применениях:

- Общий прирост производительности: DistillKit продемонстрировал последовательное улучшение производительности на различных наборах данных и условиях обучения.

- Прирост производительности в домене: целенаправленный подход к дистилляции привел к заметным улучшениям в задачах, специфичных для определенной области.

- Гибкость и универсальность: способность DistillKit поддерживать различные методы дистилляции обеспечивает гибкость в выборе архитектуры модели.

- Эффективность и оптимизация ресурсов: DistillKit снижает вычислительные ресурсы и энергопотребление для развертывания ИИ, делая передовые возможности более доступными и способствуя устойчивым практикам в области исследований и разработок в сфере ИИ.

- Сотрудничество с открытым исходным кодом: открытый характер DistillKit приглашает сообщество к участию в его развитии, способствуя инновациям и улучшениям.

Результаты производительности

Эффективность DistillKit была тщательно проверена через серию экспериментов, оценивающих ее влияние на производительность и эффективность моделей.

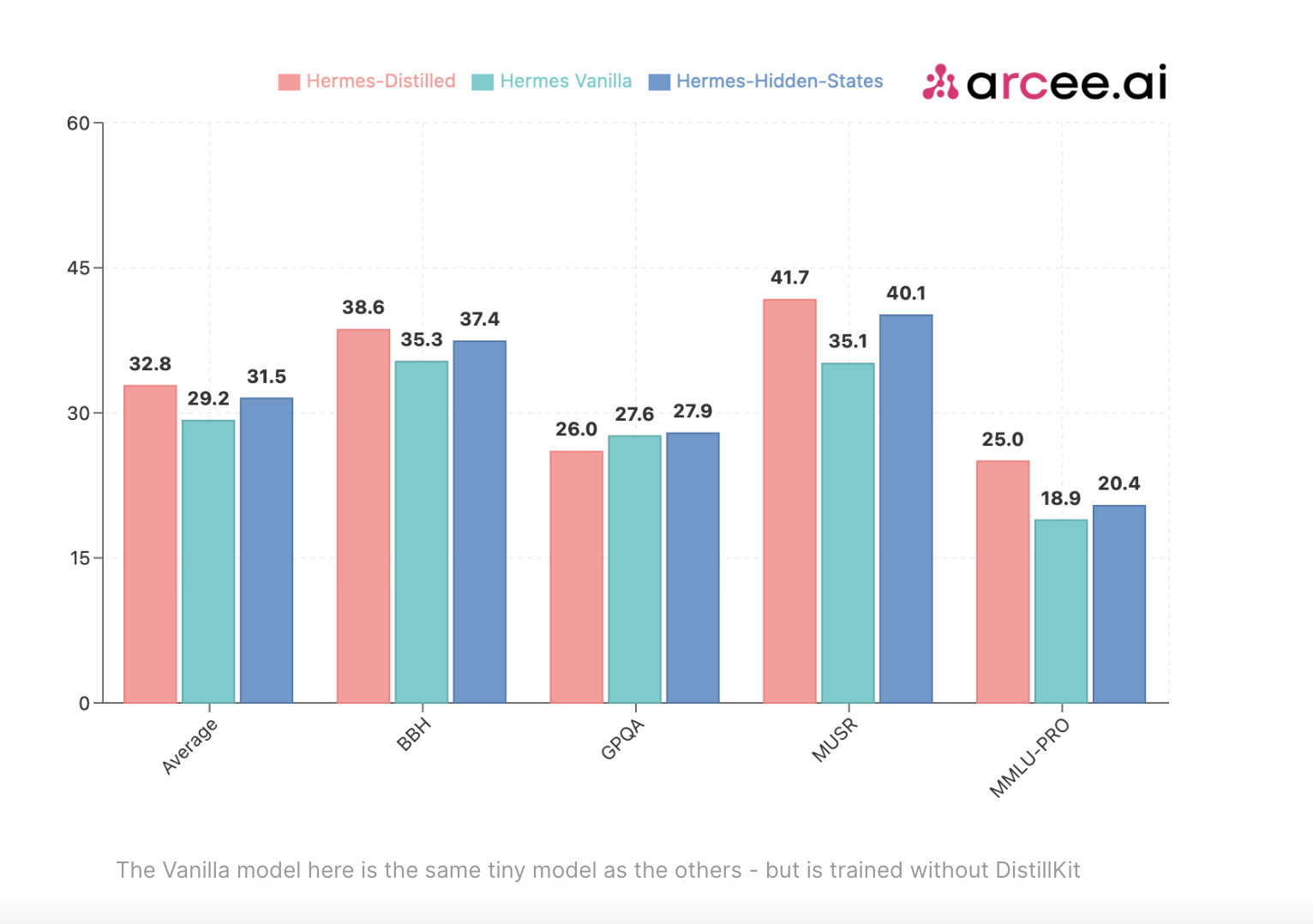

Сравнение методов дистилляции: первая серия экспериментов сравнивала производительность различных моделей, улучшенных с помощью методов дистилляции на основе логитов и скрытых состояний по сравнению со стандартным подходом к обучению (SFT). Результаты продемонстрировали значительное улучшение производительности для моделей, улучшенных с помощью дистилляции, по сравнению с базовым подходом SFT.

Эффективность в общих областях: дополнительные эксперименты оценили эффективность дистилляции на основе логитов в общей области. Улучшенная модель демонстрировала стабильное улучшение производительности по всем метрикам, подтверждая способность DistillKit создавать высокоэффективные модели, сохраняя при этом производительность учителя.

Влияние и будущие направления

Выпуск DistillKit предназначен для создания более компактных и эффективных моделей, делая передовые возможности искусственного интеллекта доступными для различных пользователей и приложений. DistillKit предлагает несколько преимуществ, включая снижение энергопотребления и операционных затрат.

Заключение

DistillKit от Arcee AI представляет собой значительный шаг в области дистилляции моделей, предлагая эффективный и гибкий инструмент для создания SLM. Результаты производительности и ключевые выводы подчеркивают потенциал DistillKit изменить подход к развертыванию ИИ, делая передовые модели более доступными и практичными. Компания Arcee AI приглашает сообщество принять участие в проекте, развивая новые методы дистилляции и оптимизируя использование памяти.

Если вы заинтересованы в использовании ИИ для развития вашего бизнеса, обратитесь к нам для консультации и подбора подходящего решения. Мы также предлагаем ознакомиться с AI Sales Bot, который может значительно улучшить ваши процессы продаж.

«`