«`html

Инновационные модели смеси экспертов (Mixture-of-Experts, MoE) в машинном обучении

Модели смеси экспертов (MoE) стали важной инновацией в машинном обучении, особенно в масштабировании крупных языковых моделей. Эти модели разработаны для эффективной обработки больших объемов данных путем использования нескольких специализированных экспертов внутри одной модели. Такой подход оказался полезным в обработке естественного языка, где одновременное решение разнообразных и сложных задач существенно для достижения точности и эффективности.

Проблемы и решения

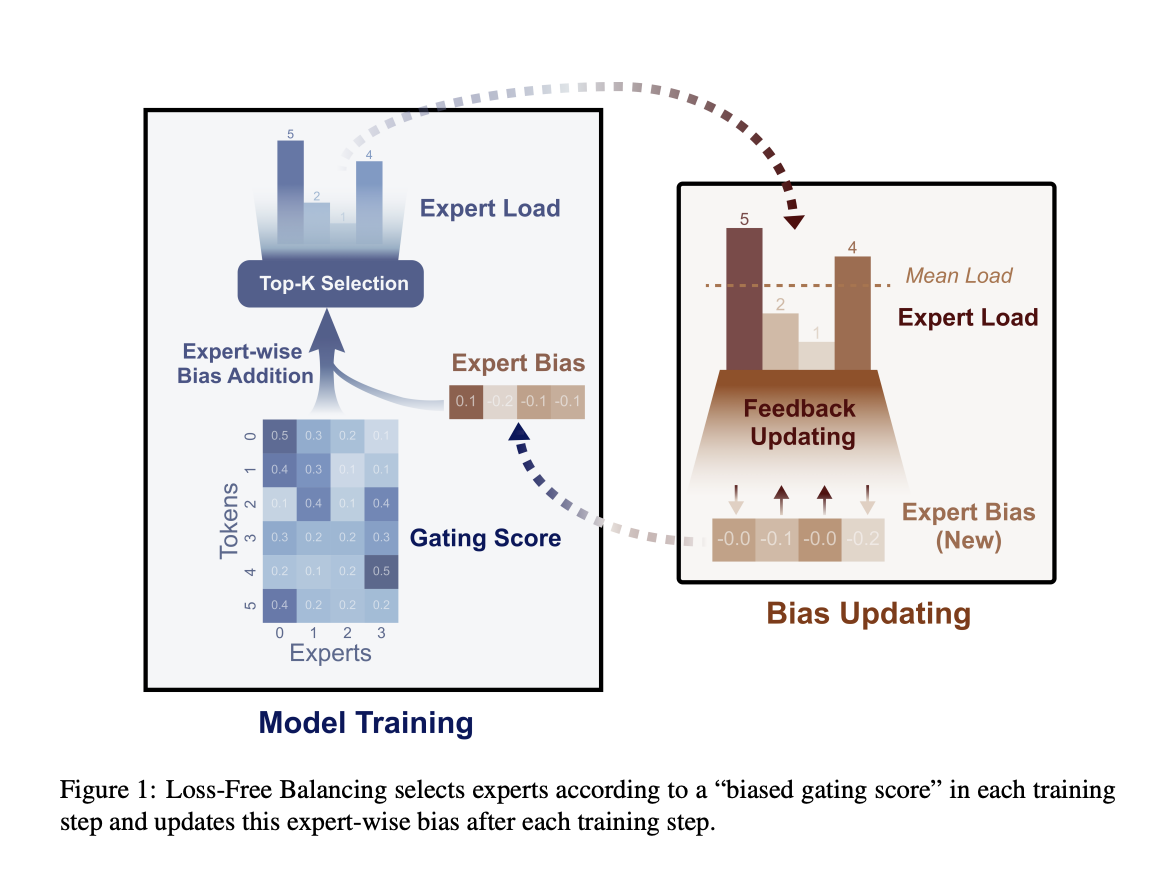

Одной из основных проблем MoE моделей является дисбаланс загрузки среди экспертов. Это может привести к снижению производительности и появлению ошибок маршрутизации. Традиционные методы используют вспомогательные функции потерь для балансировки нагрузки, однако это может вводить неожиданные градиенты, которые ухудшают производительность модели. Для решения этой проблемы был разработан метод Loss-Free Balancing, который динамически регулирует распределение задач между экспертами.

Эмпирические результаты

Empirically results attest to the effectiveness of the Loss-Free Balancing approach in maintaining a balanced load distribution while improving the model’s language processing capabilities.

Использование метода Loss-Free Balancing значительно улучшило результаты по сравнению с традиционными методами контроля нагрузки. Исследователи провели эксперименты на MoE моделях с 1B и с 3B параметрами на 100B и 200B токенах соответственно. Результаты подтвердили значительные улучшения как в балансе нагрузки, так и в общей производительности модели.

Заключение

Метод Loss-Free Balancing обеспечивает более эффективное и эффективное обучение крупномасштабных языковых моделей, решая проблемы дисбаланса нагрузки. Empirical results attest to the effectiveness of the Loss-Free Balancing approach in maintaining a balanced load distribution while improving the model’s language processing capabilities.

«`