«`html

Оценка производительности систем вывода больших языковых моделей (LLM)

Оценка производительности систем вывода больших языковых моделей (LLM) с использованием традиционных метрик представляет существенные вызовы. Метрики, такие как время до первого токена (TTFT) и время между токенами (TBT), не улавливают полного пользовательского опыта во время взаимодействия в реальном времени. Этот пробел критичен в приложениях, таких как чат и перевод, где отзывчивость напрямую влияет на удовлетворенность пользователя. Существует необходимость в более тонкой системе оценки, которая полностью охватывает тонкости вывода LLM для обеспечения оптимального развертывания и производительности в реальных сценариях.

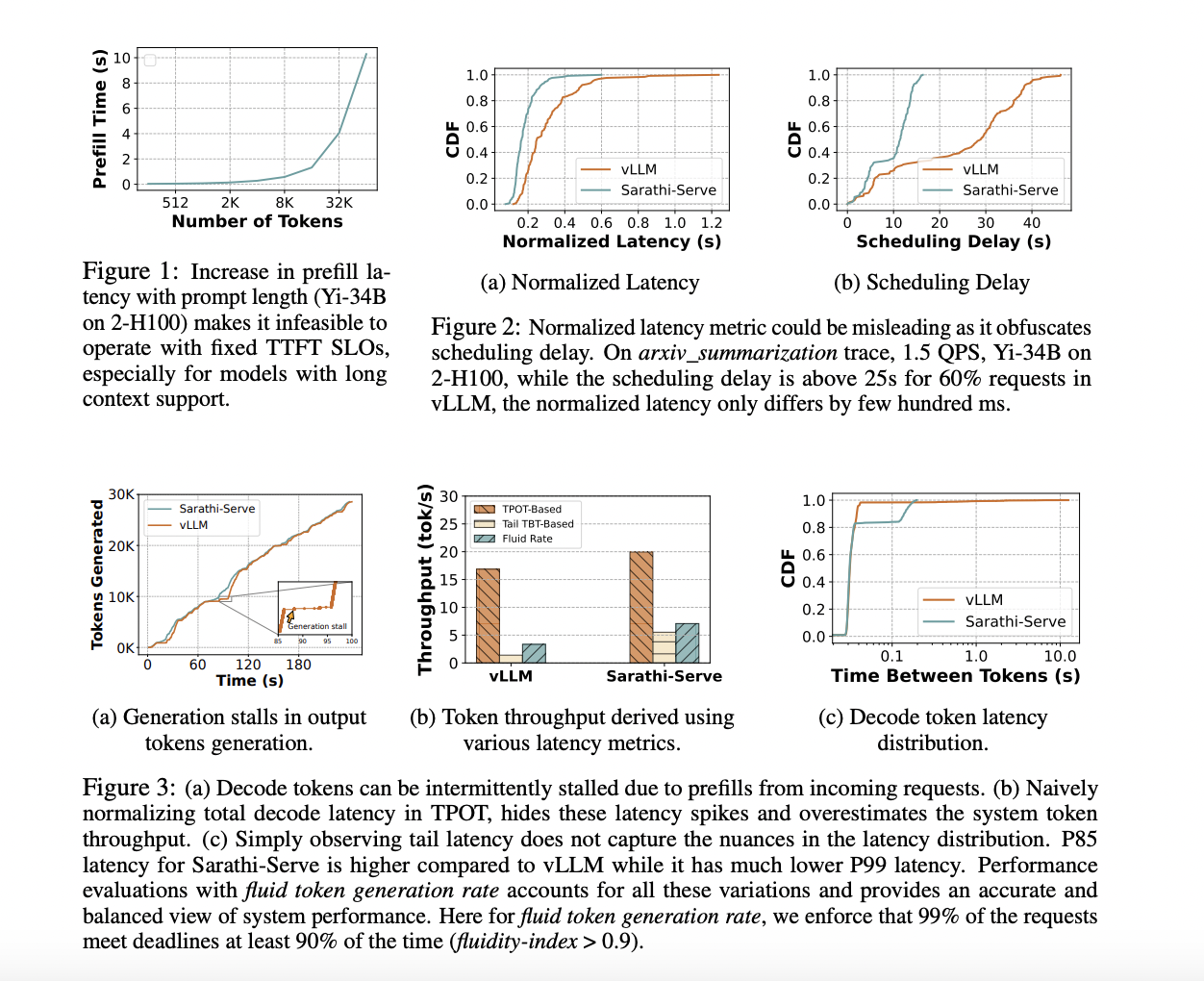

Текущие методы оценки производительности вывода LLM включают TTFT, TBT, нормализованную задержку и время на вывод токена (TPOT). Эти метрики оценивают различные аспекты задержки и пропускной способности, но не предоставляют полного представления о пользовательском опыте. Например, TTFT и TBT фокусируются на отдельных задержках токенов, не учитывая пропускную способность от начала до конца, в то время как нормализованные метрики затрудняют выявление проблем, таких как межтокенная джиттер и задержки планирования. Эти ограничения снижают их эффективность в приложениях реального времени, где поддержание плавной и последовательной скорости генерации токенов критично.

Команда исследователей из Грузинского технологического института, Microsoft Research India и Intel AI Lab предлагает Metron, комплексную систему оценки производительности. Metron вводит новые метрики, такие как индекс плавности и скорость генерации плавных токенов, которые улавливают тонкости взаимодействия в реальном времени с потоковыми LLM. Эти метрики учитывают временные аспекты генерации токенов, обеспечивая более точное отражение пользовательской производительности. Устанавливая сроки на уровне токенов и измеряя долю выполненных сроков, индекс плавности предоставляет точное определение ограничений пользовательского опыта. Этот подход представляет собой значительный вклад, предлагая более точный и ориентированный на пользователя метод оценки.

Метрика индекса плавности Metron устанавливает сроки на генерацию токенов на основе желаемых значений TTFT и TBT, корректируя их на основе длины запроса и наблюдаемой производительности системы. Этот метод учитывает задержки планирования и переменные скорости генерации токенов, обеспечивая плавный вывод. Система оценивает как открытые, так и закрытые системы вывода LLM, применяя индекс плавности для измерения процента выполненных сроков и динамической коррекции сроков на основе производительности в реальном времени. Этот метод предоставляет полное представление о способности системы обрабатывать запросы пользователей без ущерба отзывчивости.

Metron предоставляет более точную оценку систем вывода LLM по сравнению с традиционными метриками. Индекс плавности и скорость генерации плавных токенов показывают значительные различия в пользовательском опыте, которые не улавливаются только TTFT или TBT. Например, оценка систем, таких как vLLM и Sarathi-Serve, показала, что Sarathi-Serve достигает меньшего количества просрочек сроков и более высокой плавности. Результаты показывают, что Sarathi-Serve поддерживает индекс плавности > 0,9 для 99% запросов, достигая пропускной способности 600 токенов в секунду, в то время как у vLLM было в 3 раза больше просрочек TBT из-за задержек в генерации. Это демонстрирует эффективность Metron в выявлении различий в производительности и обеспечении лучшего пользовательского опыта в приложениях реального времени.

В заключение, предложенный метод Metron вводит новую систему оценки, включая метрики индекса плавности и скорости генерации плавных токенов, для более точной оценки производительности вывода LLM. Этот подход преодолевает ограничения традиционных метрик, предоставляя оценку, ориентированную на пользователя, которая улавливает тонкости генерации токенов в реальном времени. Результаты демонстрируют эффективность Metron в выявлении различий в производительности и его потенциальное влияние на улучшение систем вывода LLM, обеспечивая лучший пользовательский опыт в приложениях реального времени.

Проверьте статью и репозиторий на GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему Telegram-каналу и группе LinkedIn.

Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему подпреддиту 46 тыс. подписчиков по машинному обучению.

Источник: MarkTechPost.