«`html

Улучшение обучения нейронных сетей с помощью Fully Quantised Training (FQT)

Обучение глубоких нейронных сетей можно ускорить с помощью Fully Quantised Training (FQT), который преобразует активации, веса и градиенты в форматы меньшей точности. Процесс обучения становится более эффективным благодаря квантованию, что позволяет ускорить вычисления и снизить использование памяти. FQT минимизирует числовую точность до минимального уровня, сохраняя при этом эффективность обучения.

Теоретический анализ и практические решения

Исследование в первую очередь анализирует FQT теоретически, сосредотачиваясь на известных алгоритмах оптимизации, таких как Adam и Stochastic Gradient Descent (SGD). Одним из ключевых выводов анализа является то, что степень сходимости FQT в значительной степени зависит от вариации градиентов. При использовании низкой точности битов вариации значений градиентов могут влиять на успешность процесса обучения. Для разработки более эффективных методов обучения с низкой точностью необходимо понимание связи между вариацией градиентов и сходимостью.

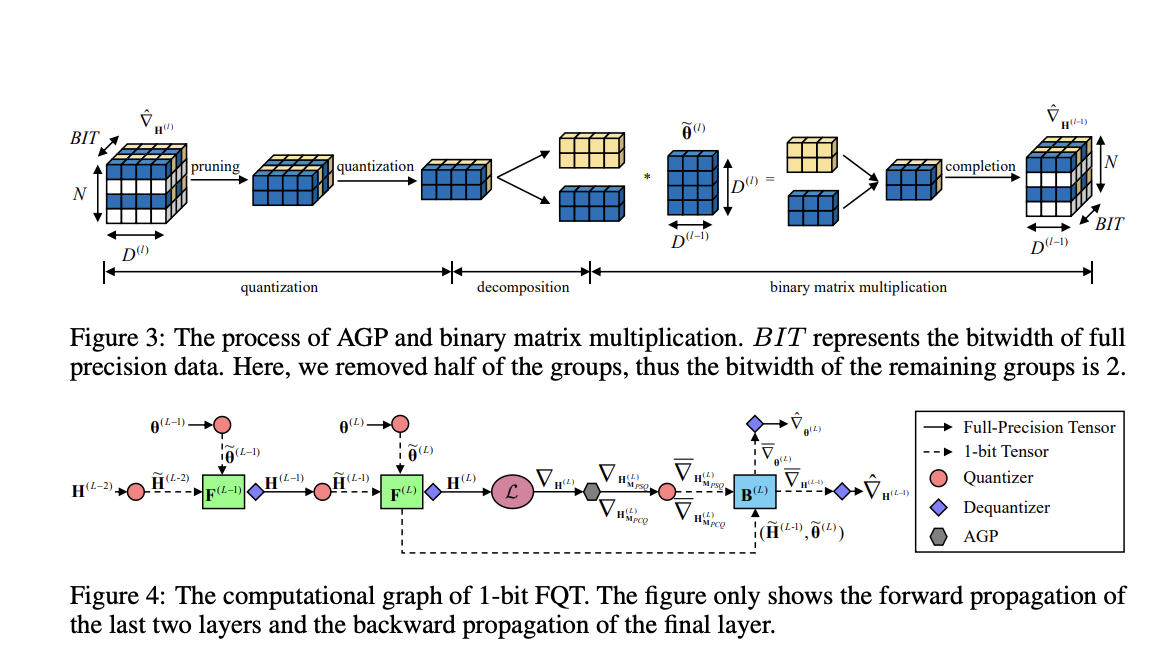

На основе этих теоретических представлений исследователи предложили уникальный подход, известный как Activation Gradient Pruning (AGP). Метод AGP использует тот факт, что не все градиенты одинаково значимы. AGP способен перераспределять ресурсы для улучшения точности наиболее важных градиентов, выявляя и обрезая менее информативные градиенты или те, которые меньше всего вносят в процесс обучения модели. Этот метод гарантирует стабильность процесса обучения даже при очень низких уровнях точности и помогает снизить негативное влияние вариации градиентов.

Исследователи также предложили метод, известный как Sample Channel joint Quantisation (SCQ), в дополнение к AGP. Градиенты весов и активаций вычисляются с использованием нескольких техник квантования в SCQ. Этот настраиваемый метод значительно повышает эффективность процесса обучения, гарантируя эффективную обработку обоих видов градиентов на аппаратуре с низкой точностью битов.

Для проверки своей методики команда создала структуру, позволяющую применять свой алгоритм в реальных ситуациях. Они экспериментировали с своим подходом, оптимизируя популярные модели нейронных сетей, такие как VGGNet-16 и ResNet-18, с использованием различных наборов данных. Точность алгоритма по сравнению с традиционными методами квантования на уровне отдельных образцов была значительной, в среднем составляя около 6%. Кроме того, по сравнению с обучением с полной точностью, процесс обучения был примерно в 5,13 раз быстрее.

В заключение, данное исследование является значительным прорывом в области полностью квантованного обучения, особенно в плане снижения допустимого порога числовой точности без ущерба для производительности. Это исследование в конечном итоге может привести к еще более эффективным методикам обучения нейронных сетей, особенно если аппаратура с низкой точностью битов станет более широко используемой.

«`