«`html

Спекулятивное декодирование для повышения производительности моделей искусственного интеллекта

Контекст и вызовы в долгосрочном декодировании

С увеличением использования моделей с большим контекстом возникает техническое вызов, связанное с обработкой длинных последовательностей. Наше исследование позволяет преодолеть проблемы памяти во время декодирования, особенно при управлении долгими контекстами.

Ключевые инновации: MagicDec и Adaptive Sequoia Trees

Мы представляем два важных алгоритмических достижения в спекулятивном декодировании: MagicDec и Adaptive Sequoia Trees, разработанные для повышения производительности в условиях долгих контекстов и больших пакетов.

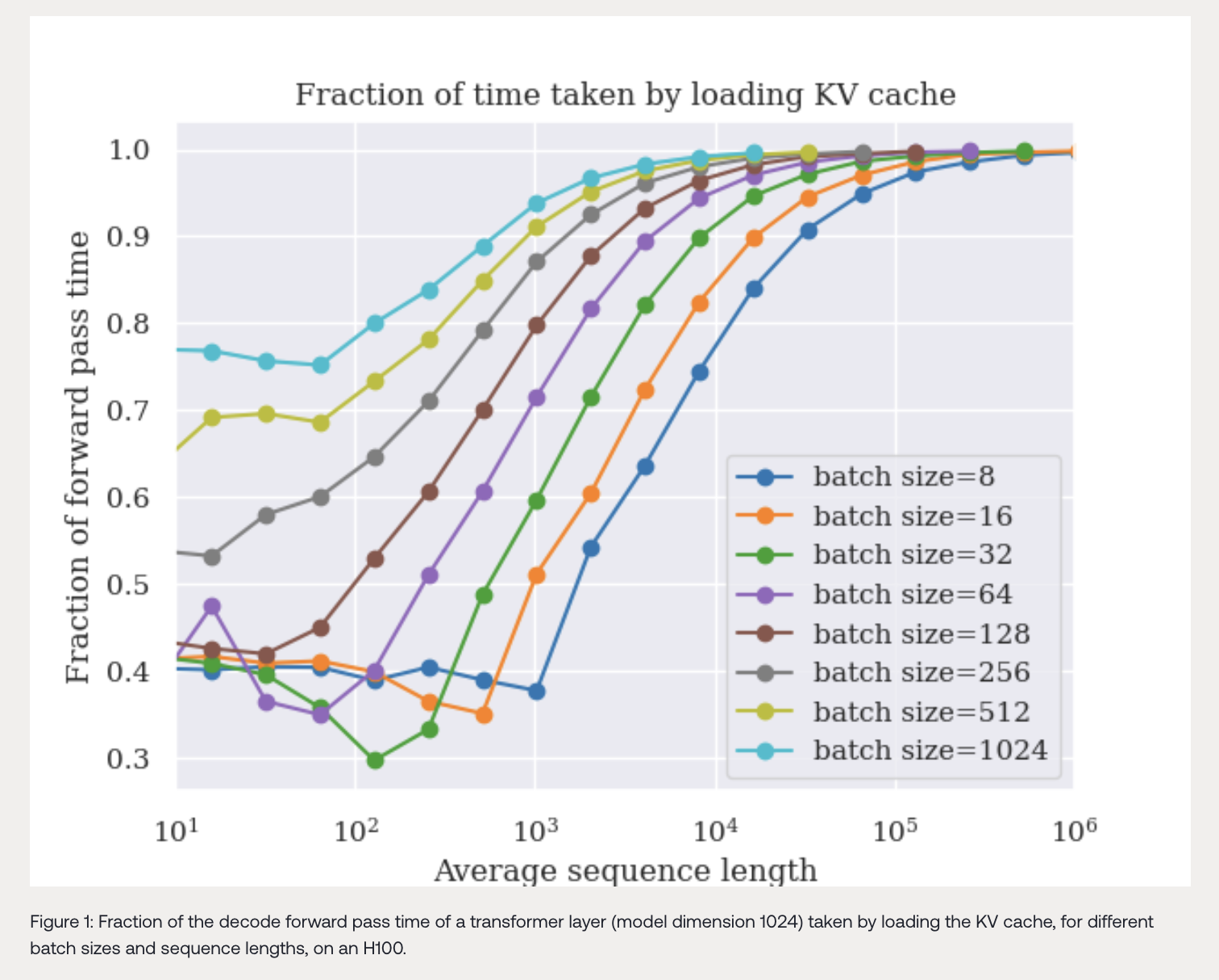

Компромиссы между памятью и вычислениями в спекулятивном декодировании

Одной из фундаментальных проблем, которую мы рассматриваем, является понимание баланса между требованиями к памяти и вычислениям во время декодирования. Наши исследования показывают, что спекулятивное декодирование может значительно улучшить производительность моделей.

Эмпирические результаты

Мы подтверждаем наши теоретические модели через эмпирический анализ, показывая, что спекулятивное декодирование может существенно улучшить производительность.

Заключение

Наше исследование переосмысливает понимание того, как модели искусственного интеллекта могут быть оптимизированы для реальных крупномасштабных приложений. Спекулятивное декодирование с помощью инноваций, таких как MagicDec и Adaptive Sequoia Trees, готово стать ключевым методом для улучшения производительности моделей в условиях долгих контекстов.

«`