Logic-of-Thought: Enhancing Logical Reasoning in Large Language Models through Propositional Logic Augmentation

Применение Logic-of-Thought для улучшения логического мышления в крупных языковых моделях

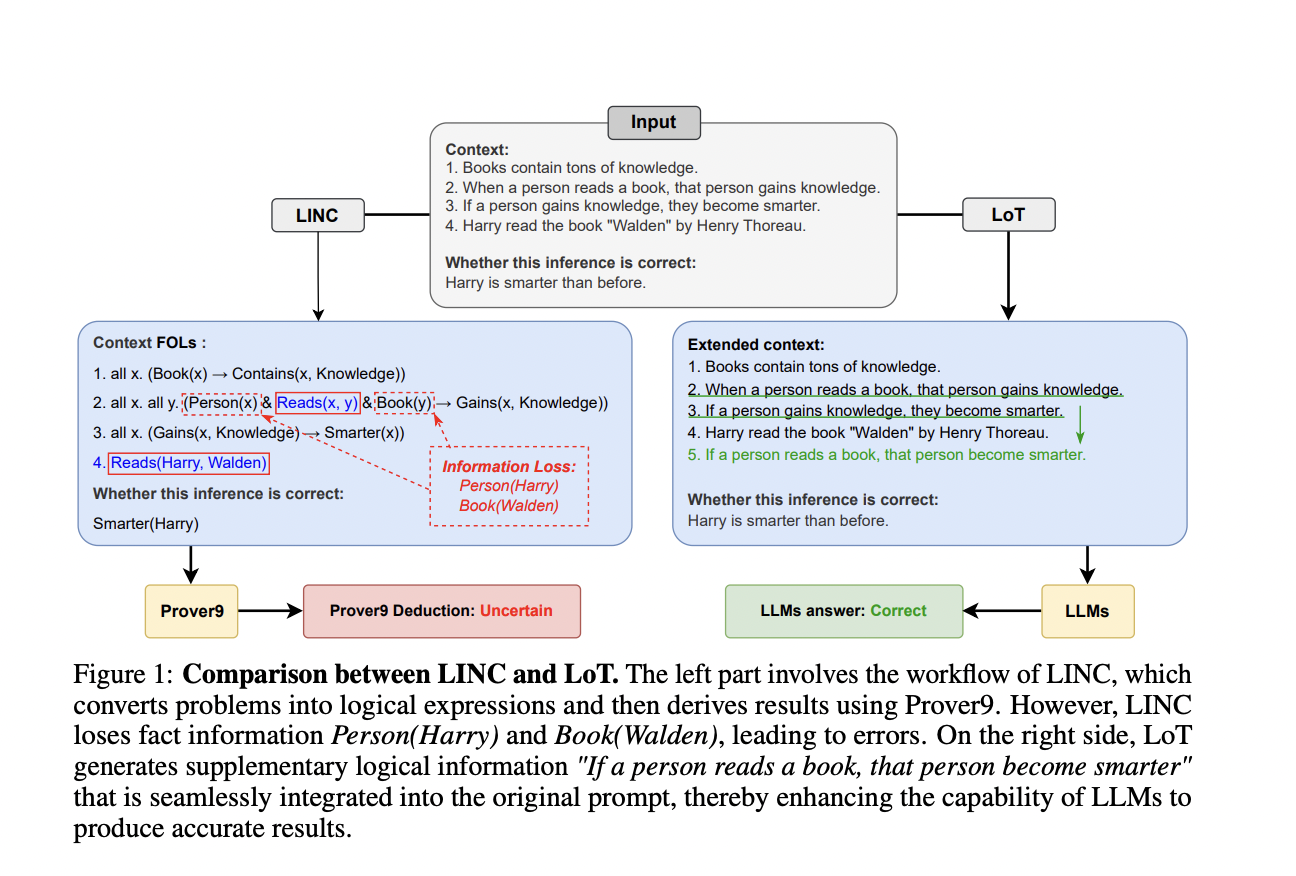

Большие языковые модели (LLM) значительно продвинулись в различных задачах обработки естественного языка, однако они все еще испытывают трудности с математикой и сложным логическим рассуждением. Подход Chain-of-Thought (CoT) появился как многообещающий метод улучшения способностей к рассуждению путем включения промежуточных шагов. Однако LLM часто проявляют недостоверное рассуждение, когда выводы не соответствуют созданной цепочке рассуждений. Это вызвало интерес у исследователей к более сложным топологиям рассуждений и нейросимволическим методам. Эти подходы направлены на имитацию процессов человеческого рассуждения и интеграцию символьного рассуждения с LLM. Несмотря на эти достижения, существующие методы сталкиваются с ограничениями, особенно с проблемой потери информации во время извлечения логических выражений, что может привести к неправильным промежуточным рассуждениям.

Исследователи разработали различные подходы для улучшения способностей LLM к рассуждению. Подход CoT и его варианты, такие как Zero-shot CoT и CoT with Self-Consistency, улучшили логическое рассуждение, разбивая сложные проблемы на промежуточные шаги. Другие методы, такие как Least-To-Most prompting и Divide-and-Conquer, фокусируются на декомпозиции проблемы. Tree-of-Thoughts и Graph-of-Thoughts вводят более сложные топологии рассуждений. Нейросимволические подходы объединяют LLM с символьным рассуждением для борьбы с недостоверным рассуждением. Среди них LReasoner, LogicAsker, Logic-LM, SatLM и LINC, которые интегрируют логическую формализацию, символьные решатели и LLM для улучшения способностей к рассуждению и преодоления проблем потери информации.

Исследователи из Университета науки и технологий Китая, Института автоматизации Китайской академии наук, Университета Бейханг и JD.com представляют Logic-of-Thought (LoT), уникальный метод подсказки, разработанный для решения проблемы потери информации в существующих нейросимволических подходах. LoT извлекает предложения и логические выражения из контекста ввода, расширяет их, используя логические законы рассуждения, и переводит расширенные выражения обратно в естественный язык. Это расширенное логическое описание затем добавляется к исходному запросу, направляя процесс рассуждения LLM. Поддерживая исходный запрос и добавляя логическую информацию на естественном языке, LoT избегает полной зависимости от символьных решателей и смягчает потерю информации. Метод совместим с существующими методами подсказки, обеспечивая безпрепятственную интеграцию. Эксперименты на пяти наборах данных логического рассуждения демонстрируют эффективность LoT в значительном улучшении производительности различных методов подсказки, включая Chain-of-Thought, Self-Consistency и Tree-of-Thoughts.

Фреймворк LoT состоит из трех ключевых фаз: Извлечение логики, Расширение логики и Перевод логики. В фазе Извлечения логики LLM идентифицируют предложения с условными логическими отношениями и извлекают предложенные символы и логические выражения из контекста ввода. Фаза Расширения логики использует программу на Python для расширения этих логических выражений с использованием заранее определенных законов рассуждения. Наконец, фаза Перевода логики использует LLM для преобразования расширенных логических выражений обратно в описания на естественном языке. Эти описания затем включаются в исходный запрос, создавая полный новый запрос для LLM. Этот процесс сохраняет исходный контекст, дополняя его дополнительной логической информацией, эффективно направляя процесс рассуждения LLM, не полагаясь исключительно на символьные решатели или рискуя потерей информации.

Подход LoT значительно улучшает производительность существующих методов на пяти наборах данных логического рассуждения. LoT+CoT-SC(5) последовательно превосходит другие методы, а LoT+SC достигает наивысшей точности на наборе данных FOLIO с GPT-4. LoT улучшает базовые методы в 35 из 40 сравнений, демонстрируя его безупречную интеграцию и эффективность. Наблюдаются незначительные улучшения при комбинировании LoT с CoT или CoT-SC из-за перекрывающихся возможностей. Некоторые ограничения наблюдаются на наборах данных RuleTaker и ProofWriter с GPT-4, связанные с проблемами извлечения информации. В целом производительность самостоятельного LoT соответствует или превосходит CoT, подчеркивая его надежные логические способности к рассуждению.

LoT — это надежный метод улучшения символьного подхода к подсказке, который решает проблему потери информации в нейросимволических методах. Путем извлечения расширенной логической информации из контекста ввода с использованием предикативной логики, LoT дополняет исходные запросы для улучшения логических способностей LLM. Его совместимость с существующими методами подсказки, такими как Chain-of-Thought, Self-Consistency и Tree-of-Thoughts, позволяет без проблем интегрировать его. Эксперименты показывают, что LoT значительно улучшает производительность различных методов подсказки на нескольких наборах данных логического рассуждения. Будущая работа будет сосредоточена на изучении дополнительных логических отношений и законов рассуждения, а также на поддержке большего количества методов подсказки для дальнейшего улучшения логических способностей LoT.