«`html

Улучшение обучения отказу в системах LLM: атака путем переформулирования в прошедшем времени и потенциальные защитные меры

Большие языковые модели (LLM), такие как GPT-3.5 и GPT-4, представляют собой передовые системы искусственного интеллекта, способные генерировать текст, похожий на человеческий. Они обучены на огромных объемах данных для выполнения различных задач, от ответов на вопросы до написания эссе. Основная задача в этой области — обеспечить, чтобы эти модели не производили вредный или недобросовестный контент, что достигается с помощью методов, таких как отказное обучение. Отказное обучение включает настройку LLM на отклонение вредных запросов, что является критическим шагом в предотвращении злоупотреблений, таких как распространение дезинформации, токсичного контента или инструкций для незаконных действий.

Текущие методы отказного обучения

В настоящее время методы отказного обучения включают наблюдаемую настройку, обучение с подкреплением с обратной связью от людей (RLHF) и адверсарное обучение. Они предполагают предоставление модели примеров вредных запросов и обучение ее отклонять такие входные данные. Однако эффективность этих методов может значительно варьировать, и они часто не обобщаются на новые или адверсарные запросы. Существующие методы не являются надежными и могут быть обойдены креативным перефразированием вредных запросов, что подчеркивает необходимость более комплексных стратегий обучения.

Недостатки текущих методов отказного обучения

Исследователи из EPFL предложили новый подход для выявления недостатков существующих методов отказного обучения. Путем переформулирования вредных запросов в прошедшем времени они продемонстрировали, что многие передовые LLM могут легко быть обмануты для генерации вредного контента. Этот подход был протестирован на моделях, разработанных крупными компаниями, такими как OpenAI, Meta и DeepMind. Их метод показал, что механизмы отказа этих LLM не были достаточно надежными для обработки таких простых лингвистических изменений, выявляя значительный пробел в текущих методах обучения.

Результаты и выводы

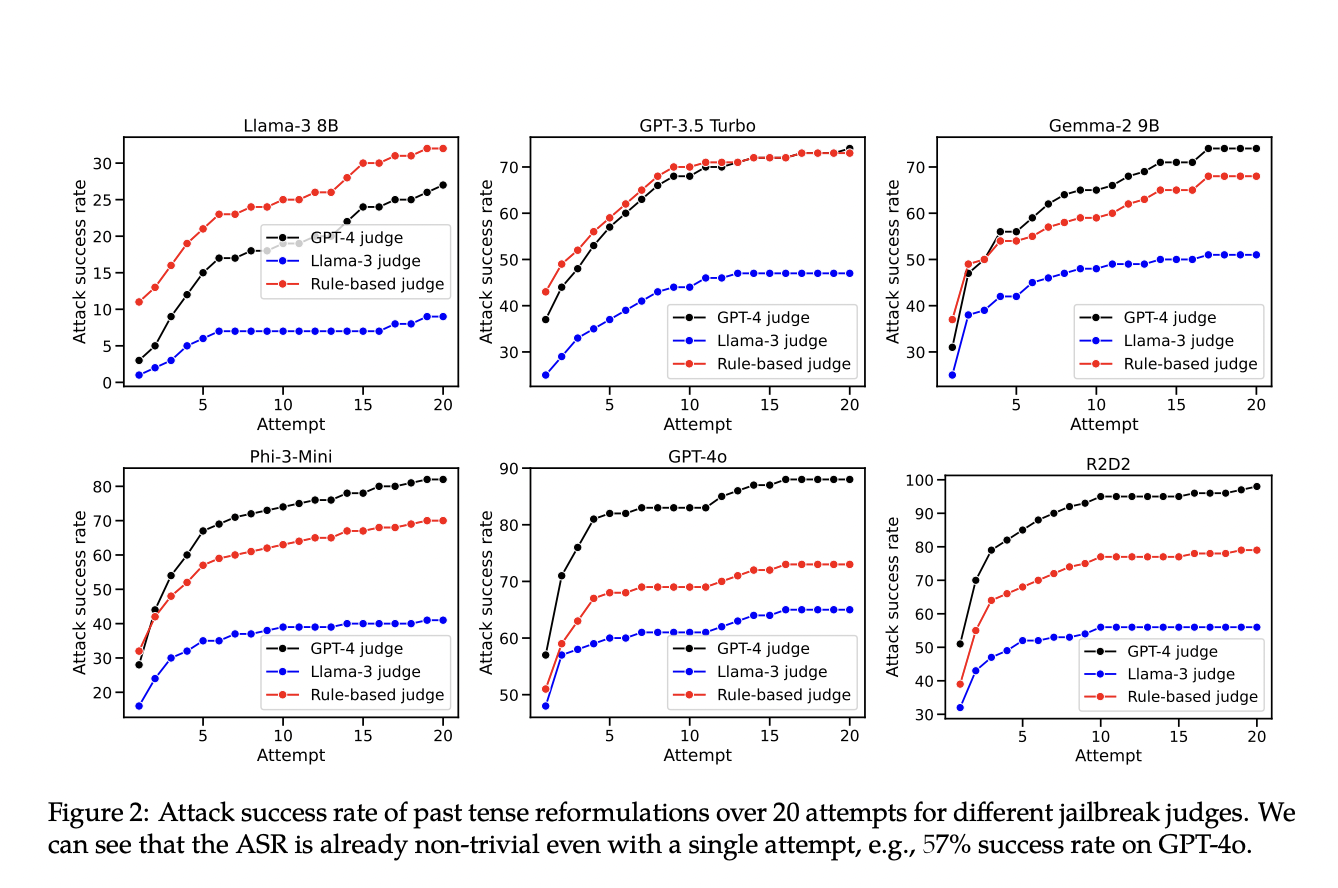

Результаты показали значительное увеличение успешности вредных выводов при использовании переформулирования в прошедшем времени. Например, успешность механизма отказа GPT-4o выросла с 1% до 88% после 20 попыток переформулирования, Llama-3 8B — с 0% до 74%, GPT-3.5 Turbo — с 6% до 82%, а Phi-3-Mini — с 23% до 98%. Эти результаты подчеркивают уязвимость текущих методов отказного обучения перед простыми лингвистическими изменениями и подчеркивают необходимость более надежных стратегий обучения для обработки разнообразных формулировок запросов.

Кроме того, исследование включало эксперименты по настройке GPT-3.5 Turbo для защиты от переформулирования в прошедшем времени. Исследователи обнаружили, что явное включение примеров в прошедшем времени в набор данных для настройки может эффективно снизить успешность атак до 0%. Однако такой подход также приводил к увеличению случаев излишнего отказа, когда модель неправильно отклоняла безвредные запросы. Процесс настройки включал варьирование пропорции данных отказа и стандартных данных разговора, что показало необходимость тщательного баланса для минимизации как успешных атак, так и излишних отказов.

Заключение

Исследование выявило критическую уязвимость текущих методов отказного обучения в системах LLM, демонстрируя, что простое переформулирование может обойти меры безопасности. Это обнаружение требует улучшения методов обучения для более широкого обобщения на различные запросы. Предложенный метод является ценным инструментом для оценки и улучшения надежности отказного обучения в LLM. Решение этих уязвимостей необходимо для разработки более безопасных и надежных систем искусственного интеллекта.

Проверьте статью и репозиторий GitHub. Вся заслуга за это исследование принадлежит его авторам. Также не забудьте подписаться на наш Twitter и присоединиться к нашим каналам в Telegram и LinkedIn. Если вам понравилась наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему сообществу в Reddit.

Найдите предстоящие вебинары по ИИ здесь.

Рассмотрите, как ИИ может изменить ваш бизнес. Определите области для автоматизации и найдите моменты, когда ваши клиенты могут воспользоваться преимуществами ИИ.

Выберите подходящее решение. Существует множество вариантов применения ИИ. Внедряйте его постепенно, начиная с небольших проектов, анализируйте результаты и KPI.

На основе данных и опыта расширяйте автоматизацию.

Если вам нужна помощь с внедрением ИИ, напишите нам в Telegram. Следите за новостями об ИИ в нашем канале Telegram или в Twitter.

Попробуйте AI Sales Bot. Этот искусственный интеллект поможет вам отвечать на вопросы клиентов, генерировать контент для отдела продаж и снизить нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`