«`html

MLPs vs KANs: Evaluating Performance in Machine Learning, Computer Vision, NLP, and Symbolic Tasks

Многослойные персептроны (MLP) стали неотъемлемыми компонентами современных моделей глубокого обучения, обеспечивая гибкость в аппроксимации нелинейных функций в различных задачах. Однако у этих нейронных сетей есть проблемы с интерпретируемостью и масштабируемостью. Трудность в понимании изученных представлений ограничивает их прозрачность, а увеличение масштаба сети часто оказывается сложным. Кроме того, MLP зависят от фиксированных функций активации, что потенциально ограничивает их адаптивность. Исследователи выделили эти ограничения как значительные препятствия в развитии возможностей нейронных сетей. В результате возникает растущая потребность в альтернативных архитектурах, способных решить эти проблемы, сохраняя или улучшая производительность традиционных MLP в задачах, таких как классификация, регрессия и извлечение признаков.

Решения для улучшения производительности

Исследователи сделали значительные успехи в сетях Колмогорова-Арнольда (KAN) для преодоления ограничений MLP. Были исследованы различные подходы, включая замену B-сплайновых функций альтернативными математическими представлениями, такими как многочлены Чебышева, вейвлет-функции и ортогональные многочлены. Эти модификации направлены на улучшение свойств и производительности KAN. Кроме того, KAN были интегрированы с существующими архитектурами сетей, такими как сверточные сети, видеотрансформеры, U-Net, графовые нейронные сети (GNN) и нейронные радиантные поля (NeRF). Эти гибридные подходы стремятся использовать преимущества KAN в различных приложениях, начиная от классификации изображений и обработки медицинских изображений до задач, связанных с графиками и трехмерной реконструкции.

Исследование производительности

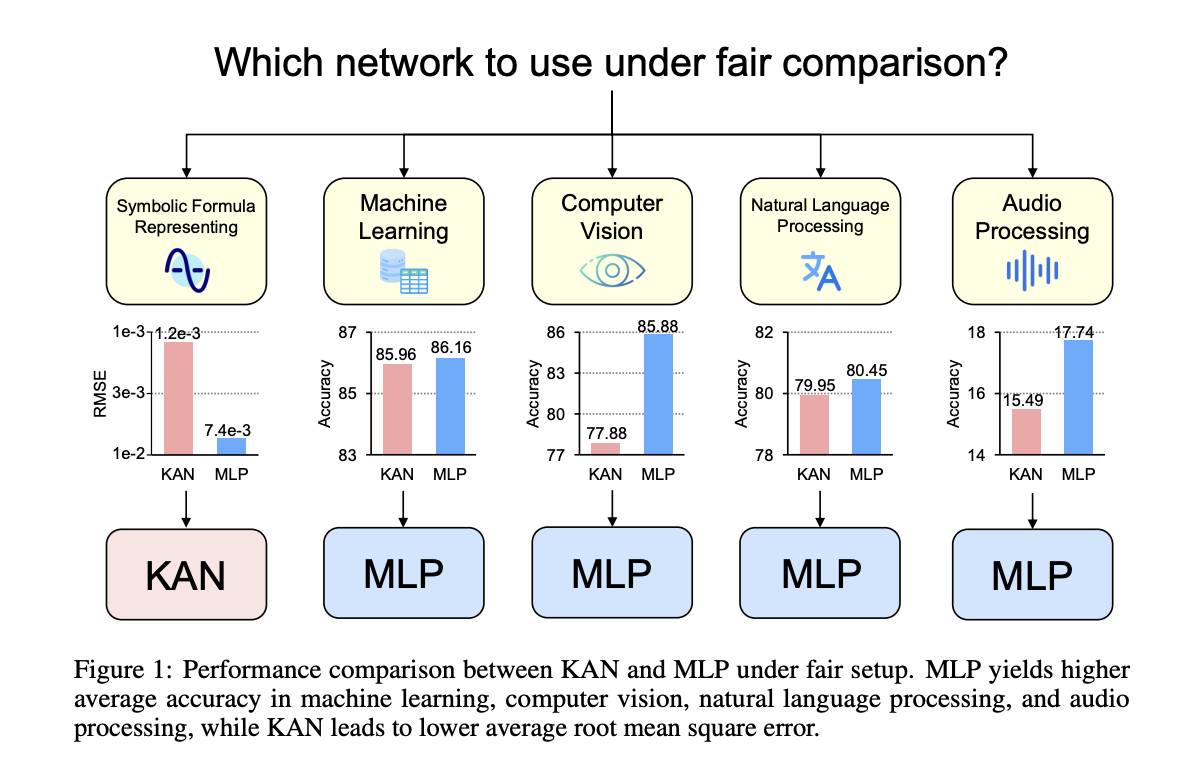

Исследователи из Национального университета Сингапура провели справедливое и всестороннее сравнение между KAN и MLP. Они контролировали параметры и FLOPs для обоих типов сетей, оценивая их производительность в различных областях, включая символьное представление формул, машинное обучение, компьютерное зрение, обработку естественного языка и аудиообработку. Этот подход обеспечивает сбалансированную оценку возможностей обеих архитектур. Исследование также рассматривает влияние функций активации на производительность сети, в частности B-сплайнов. Исследование расширяется до изучения поведения сетей в сценариях непрерывного обучения, оспаривая предыдущие результаты о превосходстве KAN в этой области. Предоставляя тщательное и справедливое сравнение, исследование стремится предложить ценные идеи для будущих исследований KAN и потенциальных альтернатив MLP.

Практическое применение

Это всестороннее исследование сравнило KAN и MLP в различных задачах. KAN, рассматриваемые как особый тип MLP с обучаемыми функциями активации B-сплайн, показали преимущества только в символьном представлении формул. MLP превзошли KAN в задачах машинного обучения, компьютерного зрения, обработки естественного языка и аудио. Интересно, что MLP с B-сплайновыми активациями соответствовали или превосходили производительность KAN во всех задачах. В классификации с постепенным увеличением, KAN проявили более серьезные проблемы с забыванием по сравнению с MLP. Эти результаты предоставляют ценные идеи для будущих исследований архитектур нейронных сетей и их применений.

Проверьте Paper и GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашей Telegram-группе и группе LinkedIn. Если вам нравится наша работа, вам понравится наш newsletter.

Не забудьте присоединиться к нашему 47 тыс. подписчиков на ML SubReddit.

Найдите предстоящие вебинары по ИИ здесь: Upcoming AI Webinars.

Arcee AI выпустил DistillKit: открытый инструмент для моделирования, упрощающий процесс дистилляции моделей для создания эффективных языковых моделей высокой производительности.

Пост MLPs vs KANs: Evaluating Performance in Machine Learning, Computer Vision, NLP, and Symbolic Tasks появилась сначала на MarkTechPost.