«`html

Question-Answer Cross Attention Networks (QAN): Advancing Answer Selection in Community Question Answering

Платформы вопросов и ответов (CQA), такие как Quora, Yahoo! Answers и StackOverflow, служат интерактивными центрами обмена информацией. Однако, качество ответов на таких платформах может варьироваться, что затрудняет пользователям эффективный поиск нужной информации. Выбор наиболее подходящего ответа становится ключевой задачей, особенно в условиях синтаксических вариаций и шума в ответах. Решению этой проблемы могут способствовать традиционные методы и новые технологии, такие как механизмы внимания, которые сосредотачиваются на улучшении взаимодействия между вопросами и ответами.

Традиционные методы выбора ответов в CQA включают моделирование контента/пользователя и адаптивную поддержку.

Моделирование контента/пользователя включает извлечение признаков из взаимодействий пользователей, в то время как адаптивная поддержка способствует сотрудничеству пользователей через поиск и маршрутизацию вопросов. Механизмы внимания, широко используемые в задачах вопросно-ответной системы, улучшают признаки и облегчают взаимосвязь между последовательностями. Большие языковые модели (LLM), такие как chatGPT, привлекли внимание в области обработки естественного языка, особенно в задачах Q&A.

Исследователи из PricewaterhouseCoopers представили сети взаимного внимания вопрос-ответ (QAN), они использовали внешние знания, сгенерированные большой языковой моделью LLaMa, чтобы улучшить производительность выбора ответа LLM.

BERT был использован для предварительного обучения на темы вопросов, тексты вопросов и ответов, а также механизмы взаимного внимания, захватывающие обширную семантическую информацию и интерактивные функции. Интеграция llama-7b-hf, большой языковой модели, улучшает соответствие между вопросами и ответами. Оптимизация запроса с четырех точек зрения позволяет LLM эффективнее выбирать правильные ответы, предлагая понимание стратегий оптимизации запроса. Эти вклады привели к достижению лучших показателей эффективности на наборах данных SemEval2015 и SemEval2017, превосходя существующие модели.

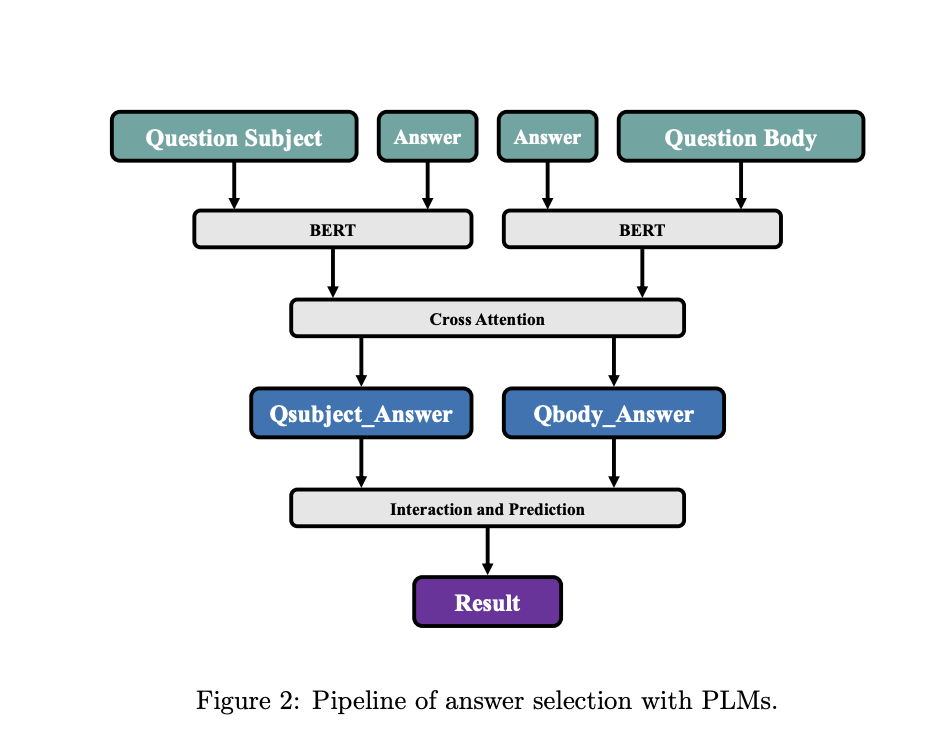

Модель QAN включает три уровня.

Во-первых, она использует BERT для захвата контекстуальных представлений тем вопросов, текстов вопросов и ответов в токенизированной форме. Затем механизм взаимного внимания анализирует отношения между парами вопрос-ответ и тело вопроса-ответ, вычисляя сходство и создавая матрицы сходства. Затем уровень взаимодействия и прогнозирования обрабатывает функции взаимодействия и назначает метки каждому ответу на основе условных вероятностей. Он включает двунаправленную GRU для получения контекста, за которой следует максимальное и среднее объединение вопросов и ответов для получения векторов фиксированной длины. Эти векторы конкатенируются для создания глобального представления, которое передается классификатору MLP для определения семантического эквивалента в паре вопрос-ответ.

QAN превосходит все базовые модели по трем метрикам оценки, прогресс связан с предварительно обученной моделью BERT и механизмом внимания. Было оценено шесть вариантов QAN на наборе данных Yahoo! Answers. Варианты включали исключение BERT в пользу задачеспецифических вложений слов или вложений символов, исключение взаимного внимания или слоя взаимодействия и прогнозирования. Некоторые варианты объединяли выводы непосредственно или рассматривали темы и тело вопросов как единое целое во время предварительного обучения с BERT. Эти вариации направлены на оценку влияния различных компонентов на производительность выбора ответа.

Предложенная модель QAN использует BERT для извлечения контекстных характеристик тем вопросов, текстов вопросов и ответов. Благодаря механизму взаимного внимания она собирает всю необходимую информацию о взаимодействии между вопросами и ответами. Интеграция внимания к вопросам и ответам приводит к достижению лучших результатов. Также, объединение больших языковых моделей с улучшением знаний повышает точность выбора ответов.

Проверьте Статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также, не забудьте подписаться на нас в Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу AI на Reddit | Также, ознакомьтесь с нашей платформой AI Events.

Попробуйте AI Sales Bot. Этот ИИ-ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab. Будущее уже здесь!

Если вам нужны советы по внедрению ИИ, пишите нам на Telegram. Следите за новостями о ИИ в нашем Телеграм-канале или в Twitter @itinairu45358.

«`