«`html

Интеграция передовых прогностических моделей в системы автономного вождения стала ключевым моментом для повышения безопасности и эффективности.

Камеры на основе видеопрогнозирования выступают важным компонентом, предлагая богатые данные реального мира.

Использование искусственного интеллекта в области компьютерного зрения и искусственного интеллекта является ведущим направлением исследований. Однако создание фотореалистичных и последовательных видео представляет существенные трудности из-за ограниченной памяти и времени вычислений. Прогнозирование видео с передней камеры критично для систем помощи водителю в автономных транспортных средствах.

Существующие подходы включают диффузионные архитектуры, которые стали популярными для генерации изображений и видео с лучшей производительностью в задачах, таких как генерация изображений, редактирование и перевод.

Другие методы, такие как генеративно-состязательные сети (GAN), модели на основе потока, авторегрессионные модели и вариационные автокодировщики (VAE), также использовались для генерации и прогнозирования видео. Модели вероятностных диффузионных моделей (DDPM) превосходят традиционные модели генерации по эффективности. Однако создание длинных видео по-прежнему требует значительных вычислительных ресурсов. Хотя авторегрессионные модели, такие как Phenaki, решают эту проблему, они часто сталкиваются с вызовами в виде нереалистичных переходов сцен и несоответствий в более длинных последовательностях.

Команда исследователей из Колумбийского университета в Нью-Йорке предложила фреймворк DriveGenVLM для генерации видео вождения и использовала модели видео-языка (VLM) для их понимания.

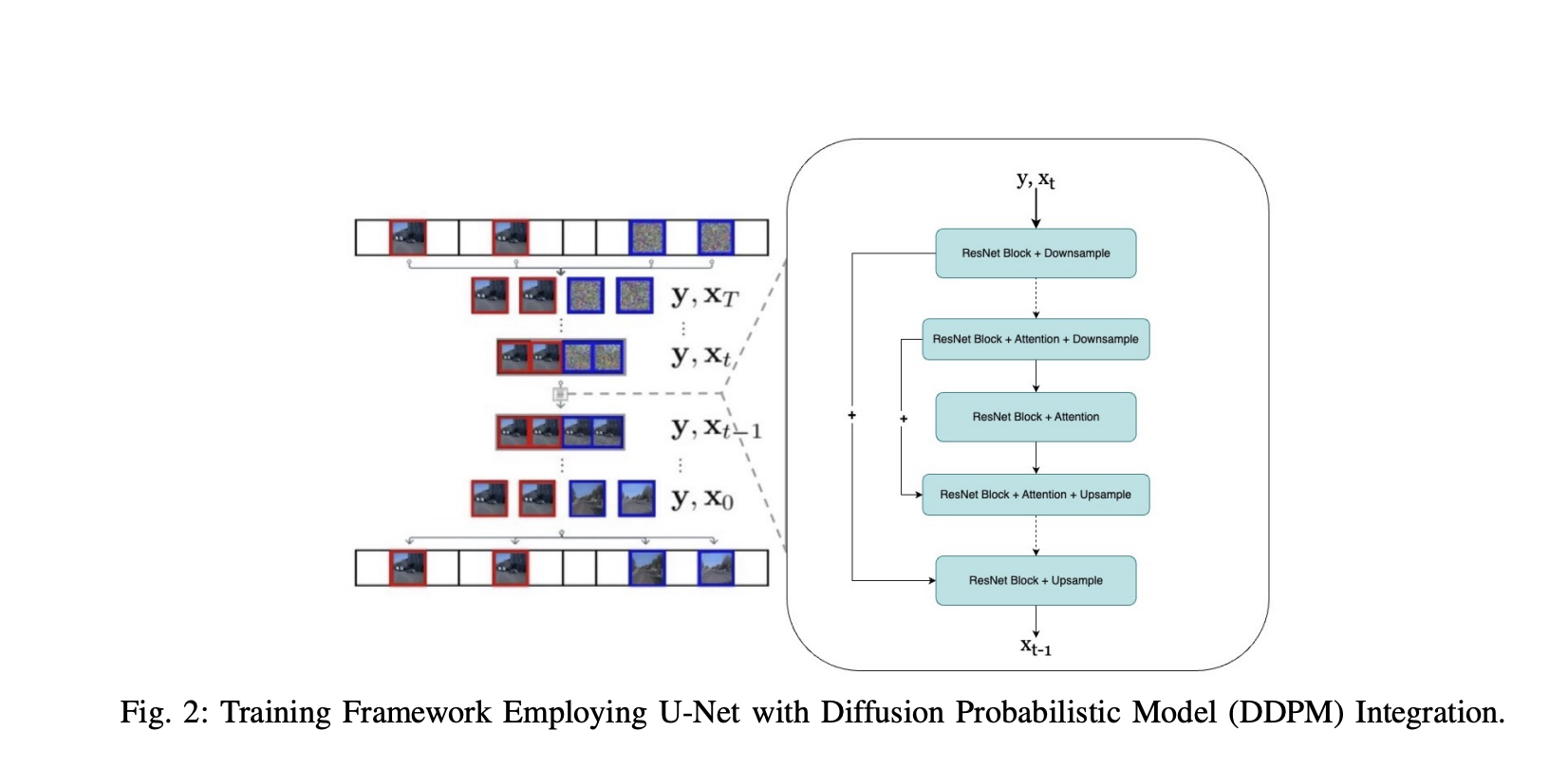

Фреймворк использует подход генерации видео на основе вероятностных моделей диффузии шума (DDPM) для прогнозирования видеопоследовательностей реального мира. Предварительно обученная модель с именем Efficient In-context Learning on Egocentric Videos (EILEV) используется для оценки пригодности сгенерированных видео для VLM. EILEV также предоставляет рассказы для этих сгенерированных видео, потенциально улучшая понимание сцен дорожного движения, помогая в навигации и улучшая возможности планирования в автономном вождении.

Фреймворк DriveGenVLM проверен с использованием набора данных Waymo Open Dataset, который предоставляет разнообразные сценарии реального вождения из нескольких городов.

Набор данных разделен на 108 видео для обучения и равномерно разделен между тремя камерами, и 30 видео для тестирования (по 10 на камеру). Этот фреймворк использует метрику Frechet Video Distance (FVD) для оценки качества сгенерированных видео, где FVD измеряет сходство между распределениями сгенерированных и реальных видео. Эта метрика ценна для оценки временной согласованности и визуального качества, делая ее эффективным инструментом для бенчмаркинга моделей синтеза видео в задачах, таких как генерация видео и прогнозирование будущих кадров.

Результаты фреймворка DriveGenVLM на наборе данных Waymo Open Dataset для трех камер показывают, что метод адаптивной иерархии-2 сэмплирования превосходит другие схемы сэмплирования, обеспечивая наименьшие оценки FVD.

Прогнозируемые видео генерируются для каждой камеры с использованием этого превосходного метода сэмплирования, где каждый пример зависит от первых 40 кадров, с кадрами и предсказанными кадрами истинной сцены. Кроме того, обучение гибкой модели диффузии на наборе данных Waymo показывает ее способность к генерации согласованных и фотореалистичных видео. Однако она по-прежнему сталкивается с вызовами в точной интерпретации сложных сцен реального дорожного движения, таких как управление трафиком и пешеходами.

В заключение, исследователи из Колумбийского университета представили фреймворк DriveGenVLM для генерации видео вождения. DDPM, обученная на наборе данных Waymo, профессионально генерирует согласованные и реалистичные изображения с передних и боковых камер. Кроме того, предварительно обученная модель EILEV используется для создания рассказов о действиях для видео. Фреймворк DriveGenVLM подчеркивает потенциал интеграции генеративных моделей и VLM для задач автономного вождения. В будущем описания сцен вождения, созданные с помощью языковых моделей, могут использоваться в больших языковых моделях для предоставления помощи водителю или поддержки алгоритмов на основе языковых моделей.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter и LinkedIn. Присоединяйтесь к нашему Telegram-каналу.

«`