«`html

Применение Искусственного Интеллекта в Продажах и Маркетинге

Решения на основе Retrieval-augmented generation (RAG)

Retrieval-augmented generation (RAG) стал важным приложением в области обработки естественного языка. Этот инновационный подход предполагает разбиение больших документов на более мелкие текстовые блоки, обычно ограниченные примерно 512 токенами. Эти небольшие кусочки информации затем хранятся в векторной базе данных, и каждый блок представлен уникальным вектором, сгенерированным с использованием модели встраивания текста. Этот процесс является основой для эффективного поиска и обработки информации.

Сила RAG в Операционной Деятельности

Когда пользователь отправляет запрос, используется та же модель встраивания, которая обработала хранимые блоки. Она кодирует запрос в векторное представление, соединяя ввод пользователя с хранящейся информацией. Этот вектор затем используется для идентификации и извлечения наиболее релевантных текстовых блоков из базы данных, гарантируя доступ только к наиболее важной информации для дальнейшей обработки.

Применение Моделей с Расширенным Контекстом

В октябре 2023 года был достигнут значительный успех в обработке естественного языка с выпуском jina-embeddings-v2-base-en, первой в мире открытой модели встраивания с впечатляющей длиной контекста в 8К токенов. Это прорыв вызвал значительное обсуждение в сообществе искусственного интеллекта относительно практических приложений и ограничений моделей с длинным контекстом.

Преимущества Работы с Более Короткими Сегментами Текста

Исследования показали, что системы извлечения на основе плотных векторов часто работают более эффективно при работе с более короткими текстовыми сегментами. Предпочтение работы с меньшими фрагментами текста обусловлено двумя ключевыми факторами: ограниченным размером входных данных для крупных языковых моделей и опасениями, что важная контекстуальная информация может быть размыта при сжатии длинных абзацев в единственное векторное представление.

Значимость Моделей с Расширенным Контекстом

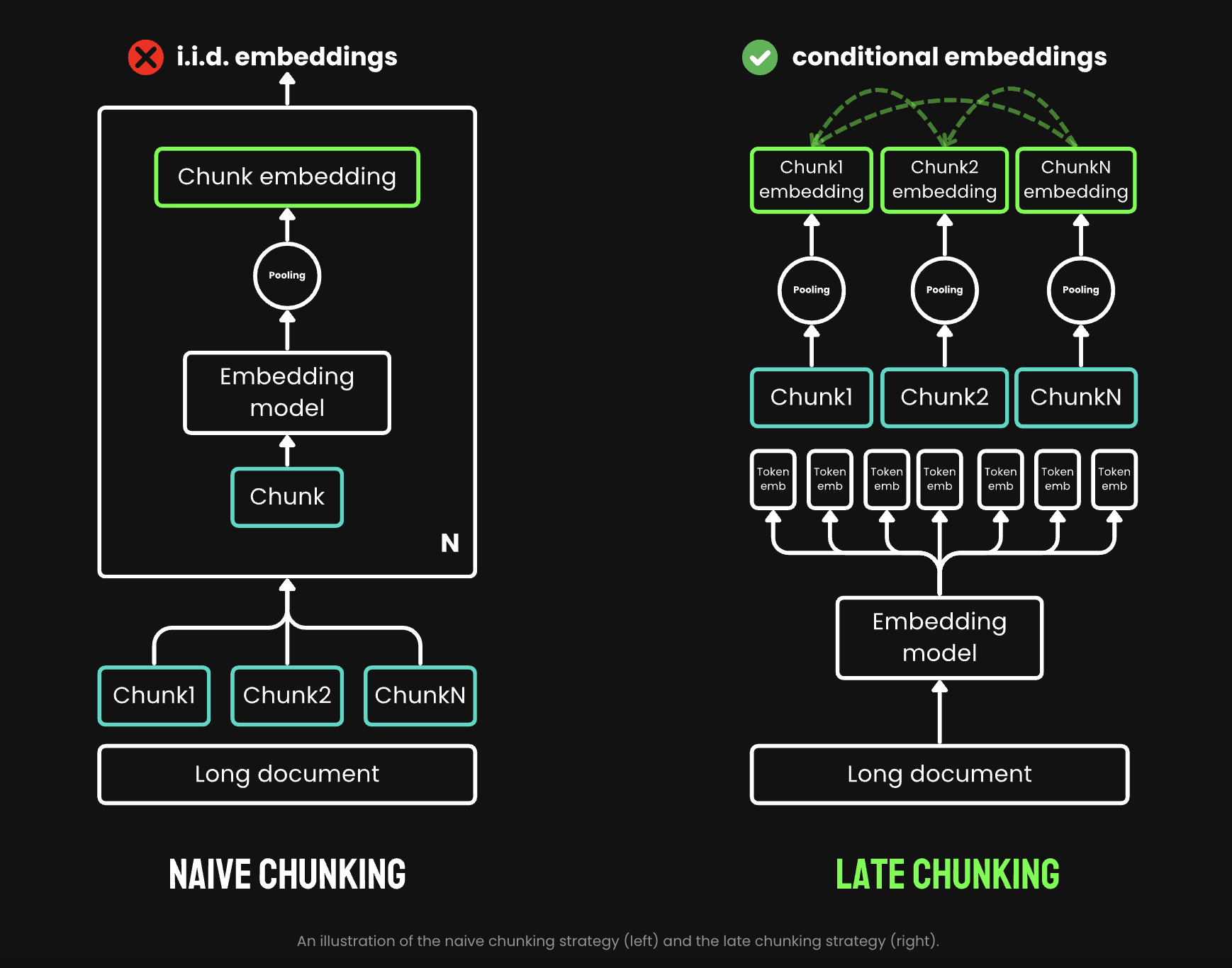

Несмотря на то, что отрыв от моделей с длинным контекстом был бы преждевременным, важно рассматривать возможности использования таких моделей, как jina-embeddings-v2-base-en. Эта статья направлена на изучение ограничений привычного трубопровода разбиения и встраивания текста в системах RAG и предлагает уникальный подход под названием «Late Chunking».

Значение Метода «Late Chunking»

Метод «Late Chunking» представляет значительный прогресс в использовании богатой контекстной информации, предоставляемой моделями встраивания с расширенным контекстом. Эта инновационная техника предлагает более эффективный способ встраивания блоков, мост между возможностями моделей с длинным контекстом и практическими потребностями различных приложений.

Использование Late Chunking для Расширения Возможностей

Для проверки эффективности late chunking исследователи провели тесты с использованием ретриевальных бенчмарков от BeIR. Результаты последовательно показали улучшение результатов для late chunking по сравнению с наивным подходом. Некоторые исследования показали, что late chunking превзошел даже однократное встраивание всего документа. Также была обнаружена корреляция между длиной документа и улучшением производительности с помощью late chunking.

Интеграция Искусственного Интеллекта в Ваш Бизнес

Если вы хотите, чтобы ваша компания развивалась с помощью Искусственного Интеллекта, обратитесь к нам для получения советов по его внедрению на https://t.me/itinai. Следите за новостями об ИИ в нашем Телеграм-канале https://t.me/aisalesbotnews

AI Sales Bot: Инновационное Решение для Автоматизации Продаж

Попробуйте AI Sales Bot https://saile.ru/, он поможет автоматизировать ответы на вопросы клиентов, генерировать контент и снижать нагрузку на первую линию отдела продаж.

«`