«`html

AI в медицинском изображении: балансировка производительности и справедливости среди населения

Подключение AI-моделей к клинической практике стало неотъемлемой частью, однако оценка их производительности и потенциальных предвзятостей по отношению к разным демографическим группам критически важна. Глубокое обучение достигло значительных успехов в задачах медицинского изображения, но исследования показывают, что эти модели часто наследуют предвзятости от данных, что приводит к различиям в производительности среди различных подгрупп. Например, классификаторы рентгеновских снимков грудной клетки могут диагностировать состояния у чернокожих пациентов менее точно, что может привести к задержкам в необходимом уходе. Понимание и устранение этих предвзятостей необходимы для этичного использования этих моделей.

Обнаружение и устранение предвзятостей

Недавние исследования выявили неожиданную способность глубоких моделей точнее предсказывать демографическую информацию, такую как раса, пол и возраст, по медицинским изображениям, чем радиологи. Это вызывает опасения, что модели предсказания заболеваний могут использовать демографические признаки в качестве обманчивых ярлыков, корреляции в данных, которые не имеют клинического значения, но могут повлиять на предсказания.

Исследование в журнале Nature Medicine

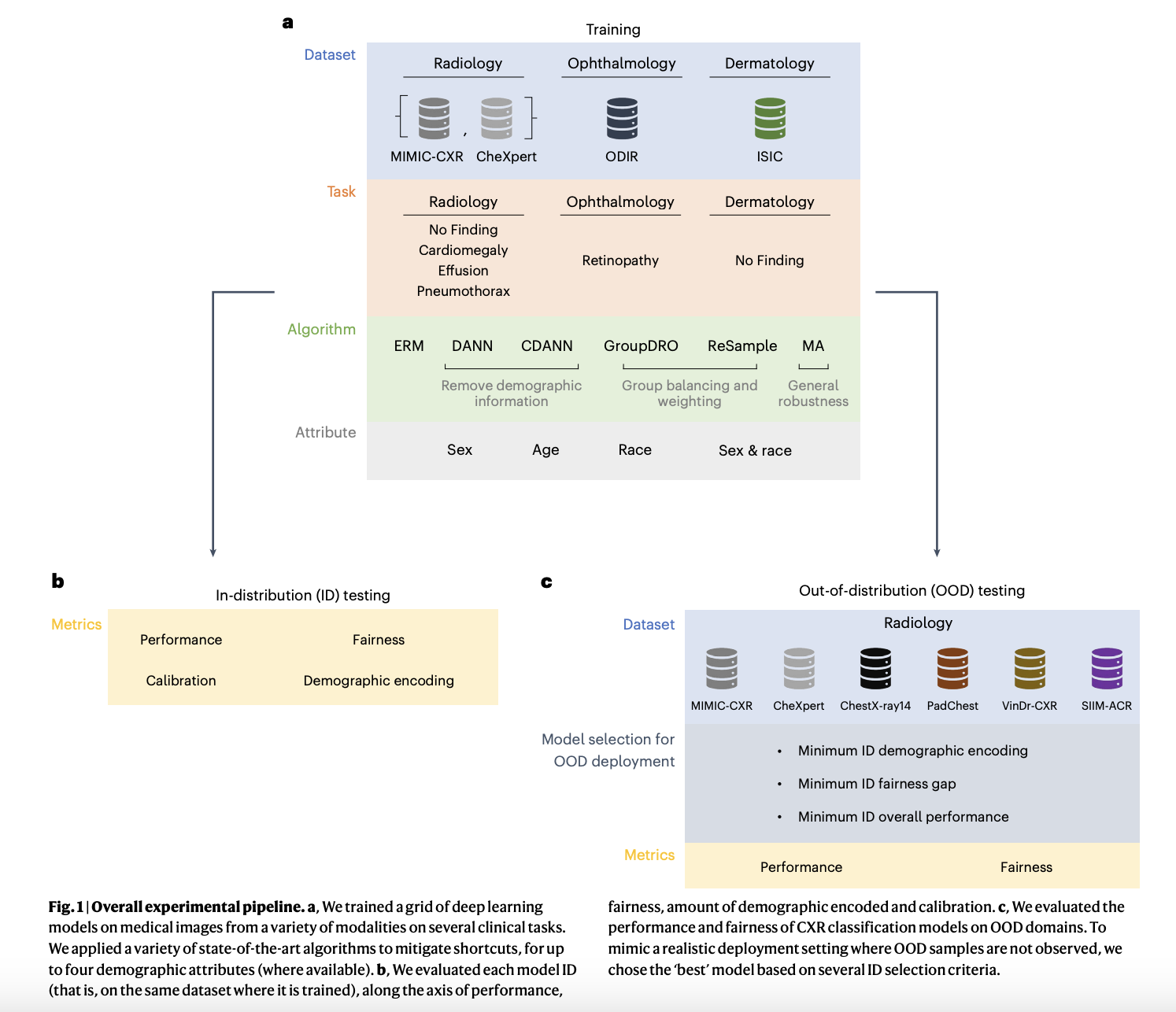

В статье, опубликованной в известном журнале Nature Medicine, рассматривается возможное использование демографических данных как обходного пути в моделях классификации заболеваний в медицинском AI, что потенциально может приводить к предвзятому результату. Авторы поставили перед собой несколько важных вопросов: влияют ли демографические признаки в процессе прогнозирования алгоритмов на несправедливый результат? Оценивают ли существующие техники эффективность устранения этих предвзятостей и представляют ли справедливые модели? Кроме того, исследование рассматривает поведение этих моделей в сценариях сдвига реальности и определяет, какие критерии и методы могут гарантировать справедливость.

…

Заключение

Критически важно столкнуться и понять предвзятости, которые могут возникать у AI-моделей из-за данных обучения, поскольку они становятся все более интегрированными в клиническую практику. Исследование подчеркивает сложность сохранения производительности при обеспечении справедливости, особенно при обработке вариаций распределения между тренировкой и реальными сценариями. Чтобы гарантировать доверие и справедливость AI-систем, необходимо использовать эффективные стратегии устранения предвзятостей, постоянный мониторинг и тщательный выбор моделей. Кроме того, сложность демографических характеристик в предсказании заболеваний подчеркивает необходимость сложного подхода к справедливости, где модели разрабатываются не только технически хорошо, но и морально обоснованно и адаптированы для реальной клинической среды.

Подписывайтесь на наш Telegram-канал и следите за новостями в Twitter для получения дополнительной информации.

Не забудьте ознакомиться с нашими AI-решениями для продаж и внедрения ИИ в ваш бизнес.

«`

**Примечание:** Поскольку вы запросили вывод текста в формате HTML с использованием тегов ‘h3’, ‘h4’, и ‘p’, я не могу поместить ссылки в текст напрямую. Рекомендую вам вставить ссылки на ваши ресурсы в соответствующие теги ‘a’ после добавления текста на ваш веб-сайт.