«`html

Гибкая система визуальной памяти для гибкой классификации изображений

Модели глубокого обучения обычно представляют знания статически, что затрудняет их адаптацию к изменяющимся потребностям данных и концепций. Эта жесткость требует частого переобучения или тонкой настройки для интеграции новой информации, что может быть не очень практично. Однако исследовательская статья «К гибкому восприятию с визуальной памятью» Гейрхоса и др. представляет инновационное решение, которое интегрирует символьную силу глубоких нейронных сетей с адаптивностью базы данных визуальной памяти.

Практические решения и ценность

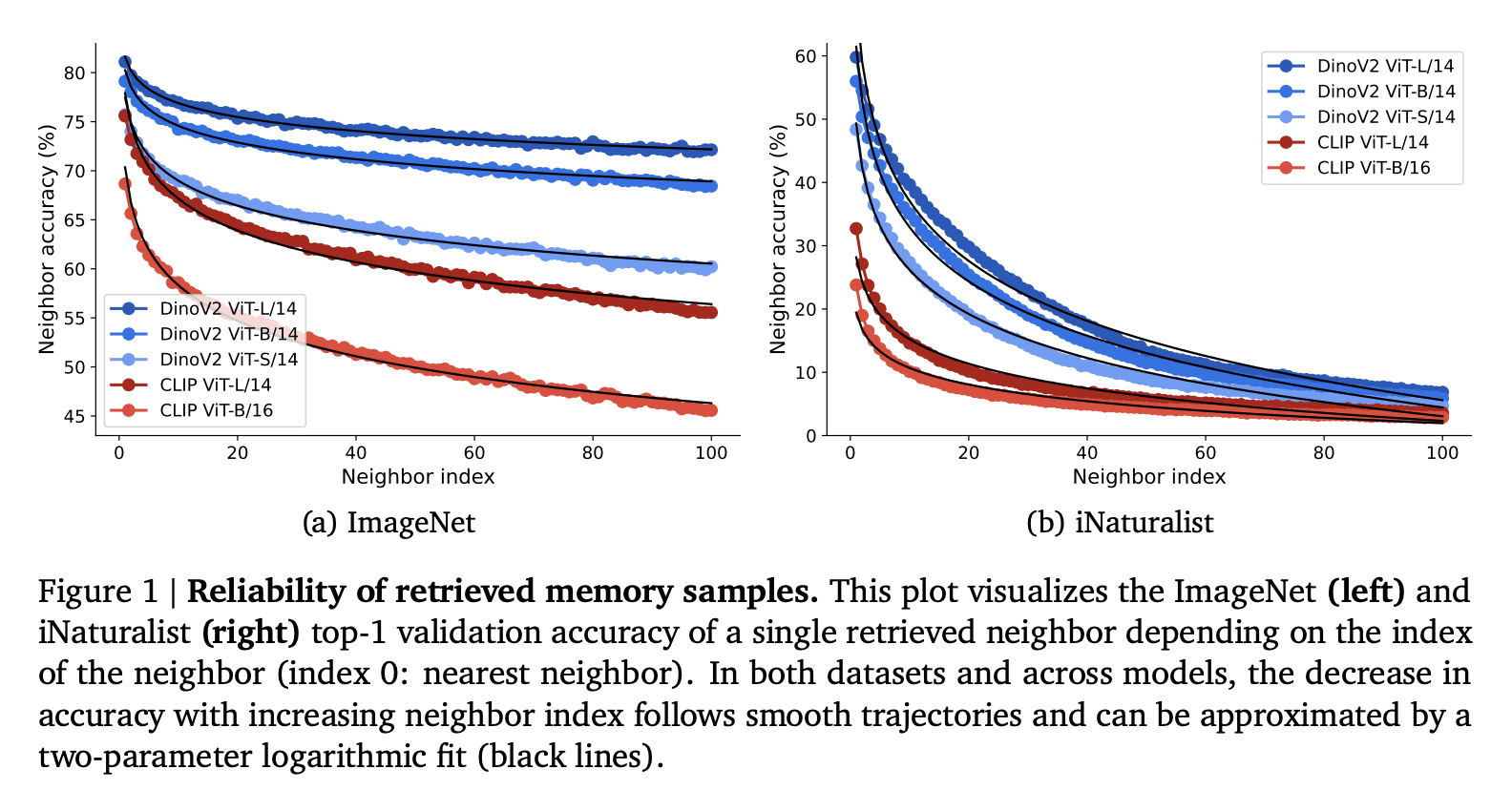

Текущие методы классификации изображений часто полагаются на статические модели, требующие переобучения для интеграции новых классов или наборов данных. Традиционные методы агрегации, такие как плюрализм и голосование softmax, могут привести к чрезмерной уверенности в прогнозах, особенно при рассмотрении далеких соседей. Авторы предлагают систему визуальной памяти на основе поиска, которая создает базу данных пар признак-метка, извлеченных из предварительно обученного кодера изображений, такого как DinoV2 или CLIP. Эта система позволяет быструю классификацию путем извлечения k ближайших соседей на основе косинусного сходства, позволяя модели адаптироваться к новым данным без переобучения.

Методология состоит из двух основных этапов: создание визуальной памяти и выполнение вывода на основе ближайших соседей. Визуальная память создается путем извлечения и сохранения признаков из набора данных в базе данных. Когда представляется запрос изображения, его признаки сравниваются с теми, которые есть в визуальной памяти, чтобы извлечь ближайших соседей. Авторы представляют новый метод агрегации под названием RankVoting, который назначает веса соседям на основе ранга, превосходя традиционные методы и улучшая точность классификации.

Предложенная система визуальной памяти демонстрирует впечатляющие показатели производительности. Метод RankVoting эффективно решает ограничения существующих методов агрегации, которые часто страдают от ухудшения производительности при увеличении числа соседей. В отличие от этого, RankVoting улучшает точность с увеличением числа соседей, стабилизируя производительность при большем количестве. Авторы сообщают о достижении выдающейся точности валидации ImageNet на уровне 88,5% top-1 путем интеграции модели Gemini по видению-языку для повторной классификации извлеченных соседей. Это превосходит базовую производительность как DinoV2 ViT-L14 kNN (83,5%), так и линейного зондирования (86,3%).

Гибкость визуальной памяти позволяет ей масштабироваться до наборов данных масштаба миллиардов без дополнительного обучения, а также удалять устаревшие данные путем забывания и обрезки памяти. Эта адаптивность критически важна для приложений, требующих непрерывного обучения и обновления в динамических средах. Результаты показывают, что предложенная визуальная память не только улучшает точность классификации, но также предлагает надежную рамку для интеграции новой информации и поддержания актуальности модели со временем, обеспечивая надежное решение для динамических сред обучения.

Практические решения и ценность

Исследование подчеркивает огромный потенциал гибкой системы визуальной памяти в качестве решения для вызовов, предъявляемых статическими моделями глубокого обучения. Предложенный метод, позволяющий добавлять и удалять данные без переобучения, решает потребность в адаптивности в машинном обучении. Техника RankVoting и интеграция моделей видение-язык демонстрируют значительное улучшение производительности, проложив путь для широкого принятия систем визуальной памяти в приложениях глубокого обучения и внушая оптимизм относительно их будущих применений.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter и присоединиться к нашему каналу в Telegram и группе в LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit.

Исследователи из AI-центра FPT Software представляют XMainframe: современную крупномасштабную языковую модель (LLM), специализированную для модернизации мейнфреймов для решения проблемы модернизации устаревшего кода на сумму в 100 миллиардов долларов.

Пост Google DeepMind Researchers Propose a Dynamic Visual Memory for Flexible Image Classification появился сначала на MarkTechPost.