«`html

Искусственный интеллект (ИИ) и машинное обучение (ML) преобразовали множество областей, но остается значительная проблема в воспроизводимости экспериментов.

Исследователи часто полагаются на ранее опубликованные работы для проверки или расширения своих результатов. Однако настройка этих репозиториев, конфигурация среды и устранение различных технических проблем, таких как устаревшие зависимости и ошибки, требуют много времени и экспертизы. По мере развития ИИ исследователи ищут способы автоматизировать эти задачи для ускорения научных открытий.

Проблема воспроизведения экспериментов из исследовательских репозиториев

Одна из критических проблем в воспроизведении экспериментов из исследовательских репозиториев заключается в их часто неправильном обслуживании. Плохая документация и устаревший код затрудняют запуск экспериментов другими исследователями. Эта проблема дополнительно усложняется различными платформами и инструментами, необходимыми для запуска различных экспериментов.

Интродукция SUPER — бенчмарк для оценки способности LLMs настраивать и выполнять задачи из исследовательских репозиториев

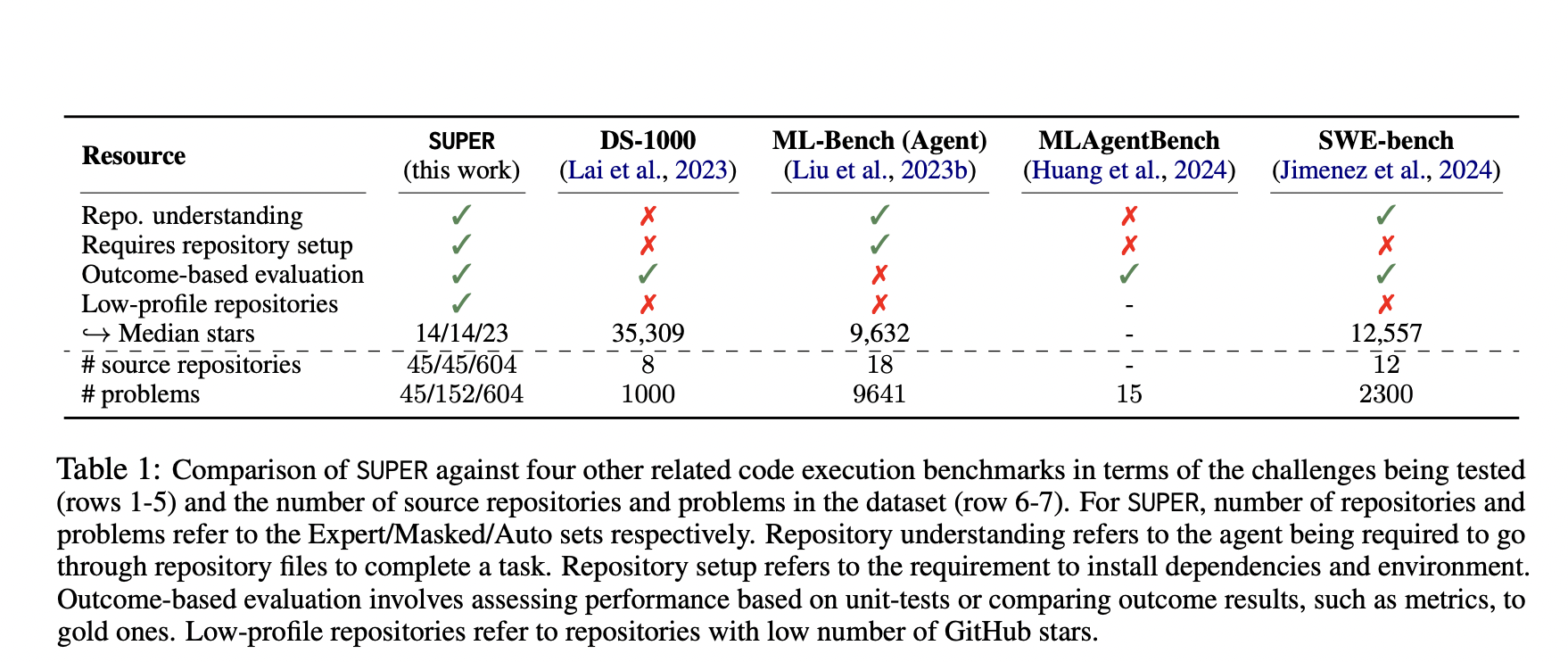

Исследователи из Allen Institute for AI и University of Washington представили SUPER — бенчмарк, разработанный для оценки способности LLMs настраивать и выполнять задачи из исследовательских репозиториев. В отличие от других инструментов, фокусирующихся на популярных и хорошо поддерживаемых репозиториях, SUPER подчеркивает реальные проблемы, с которыми исследователи сталкиваются при использовании менее известных репозиториев, которые не всегда хорошо задокументированы.

Оценка производительности LLMs на бенчмарке SUPER

Оценка производительности LLMs на бенчмарке SUPER показывает значительные ограничения текущих моделей. Самая передовая протестированная модель, GPT-4o, успешно решает только 16,3% задач в Expert set и 46,1% подзадач в Masked set. Эти результаты подчеркивают трудности автоматизации настройки и выполнения исследовательских экспериментов, поскольку даже лучшие модели справляются с многими задачами с трудом.

В заключение, бенчмарк SUPER проливает свет на текущие ограничения LLMs в автоматизации исследовательских задач. Несмотря на последние достижения, все еще существует значительный разрыв между возможностями этих моделей и сложными потребностями исследователей, работающих с реальными репозиториями.

«`

**Важно!** Удалите все ссылки, не указанные в этом запросе.