Преимущества метода CodePMP для улучшения решения задач сложного логического и математического характера в больших языковых моделях

Текущая проблема

Большие языковые модели (LLM) имеют огромный потенциал в понимании и генерации естественного языка, однако возникают сложности с логическим мышлением и математическими задачами. Отсутствие высококачественных данных для моделей вознаграждения (RMs) затрудняет использование обратной связи от людей для улучшения производительности LLM в решении логических задач.

Решение CodePMP

CodePMP – новый метод предварительного обучения, который создает крупномасштабные данные предпочтений из общедоступного исходного кода, специально адаптированные для логических задач. Этот инновационный подход автоматизирует генерацию данных предпочтений, значительно повышая эффективность и масштабируемость обучения RMs.

Результаты и преимущества

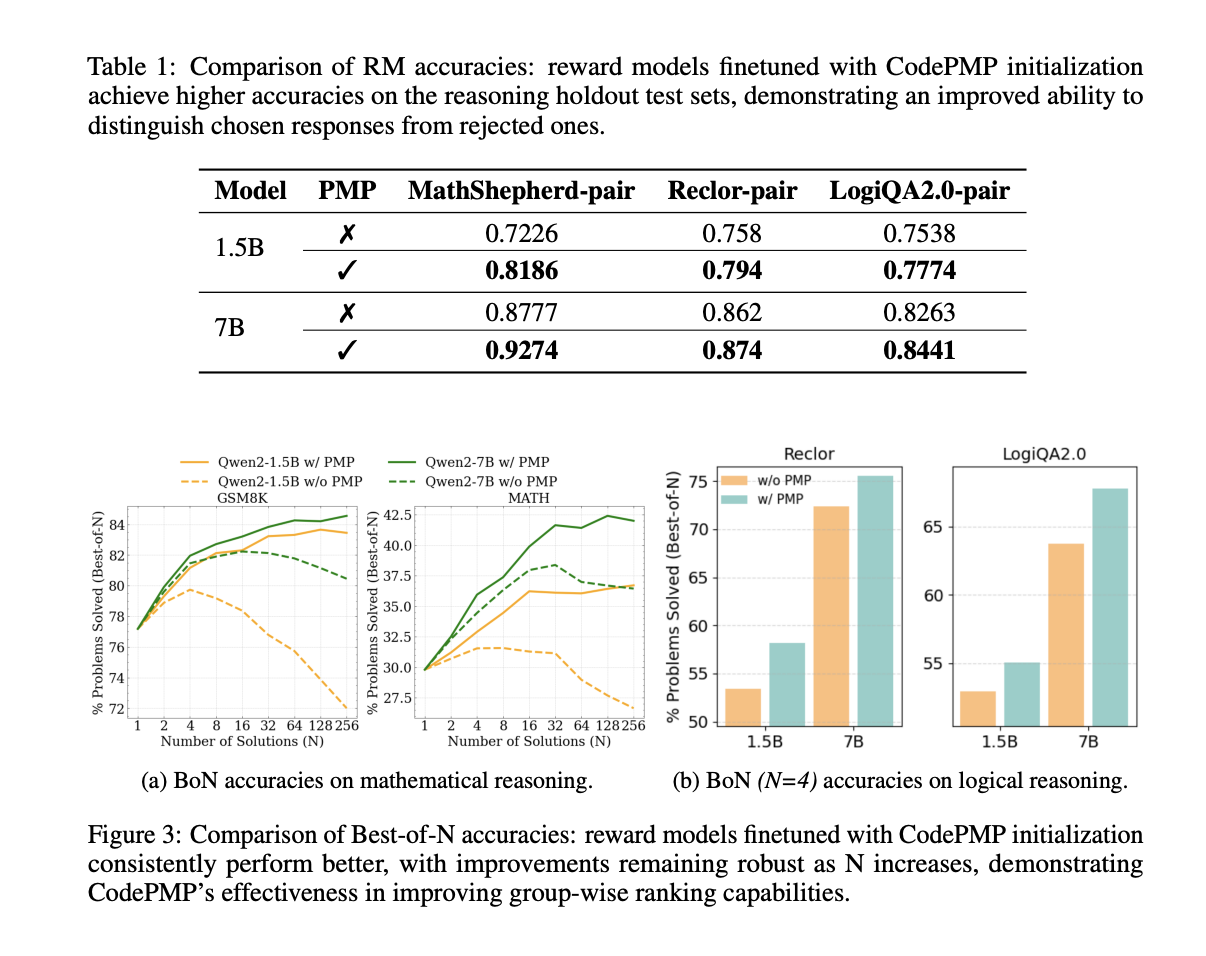

CodePMP продемонстрировал значительное улучшение производительности в решении математических и логических задач. Модели, обученные с применением CodePMP, показали себя лучше по сравнению с альтернативами как в точности RM, так и в Best-of-N производительности.

Заключение

CodePMP представляет собой масштабный и эффективный подход к улучшению способностей к рассуждениям в больших языковых моделях с использованием сгенерированных из общедоступного кода пар предпочтений. Этот инновационный метод позволяет повысить эффективность обучения RMs и расширить область применения LLM в задачах, требующих сложного рассуждения.