«`html

Оптимизация производительности GPU для обучения LLM

Проблема

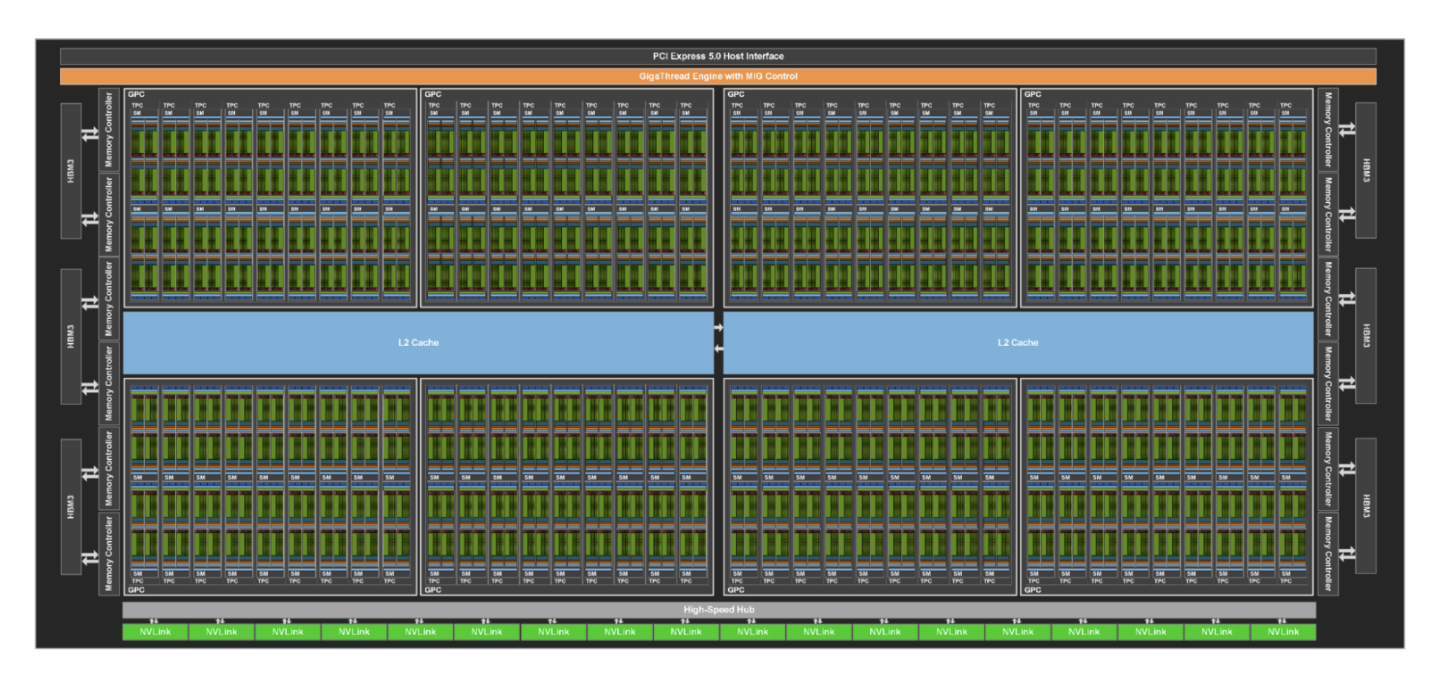

Использование Large Language Models (LLMs) ведет к необходимости эффективного использования GPU в задачах машинного обучения. Однако оценка производительности GPU становится сложной из-за недостоверных метрик, таких как GPU Utilization.

Решение

Для более точной оценки производительности GPU в обучении LLM и инференсе, необходимо использовать альтернативные метрики, такие как Model FLOPS (MFUs). Это позволяет получить более точное представление о производительности GPU и оптимизировать ее использование.

Практическое применение

Компания Trainy AI researchers успешно достигла 100% использования GPU и значительного потребления энергии, применяя техники оптимизации производительности, такие как настройка параметров dataloader, использование mixed precision training и оптимизация сети.

Оптимизация и рекомендации

Оптимизация обучения LLM включает замену нативных определений слоев PyTorch на GPU-ядра, что приводит к значительному увеличению производительности и использования FLOPS. Рекомендуется отслеживать SM Efficiency и GPU Utilization на кластерах GPU для более точной оценки производительности.

Внедрение ИИ-решений

Если вы хотите внедрить ИИ-решения в свой бизнес, обращайтесь к нам для консультаций. AI Sales Bot от saile.ru может значительно упростить процесс продаж и снизить нагрузку на персонал.

«`