«`html

Оценка эффективности сжатия больших языковых моделей (LLM) с помощью метрик расстояния

Оценка эффективности методов сжатия LLM является ключевой задачей в области искусственного интеллекта (ИИ). Методы сжатия, такие как квантизация, направлены на оптимизацию эффективности LLM путем снижения вычислительных затрат и задержек. Однако традиционные практики оценки сосредоточены в основном на метриках точности, которые не улавливают изменения в поведении модели, такие как явление «переворотов», когда правильные ответы становятся неправильными и наоборот. Эта проблема значительна, поскольку она влияет на надежность и последовательность сжатых моделей в различных критических приложениях, включая медицинскую диагностику и автономное вождение.

Текущие методы оценки техник сжатия LLM

Существующие методы оценки техник сжатия LLM полагаются в значительной степени на метрики точности с бенчмарк-задач, таких как MMLU, Hellaswag и ARC. Однако этот подход не учитывает возникновение переворотов, когда сжатые модели могут давать разные ответы, несмотря на схожие уровни точности. Это может привести к искаженному восприятию надежности модели. Кроме того, метрики точности не учитывают качественные различия в поведении модели, особенно в задачах с генеративными ответами, где нюансы генерации языка имеют важное значение.

Новый подход к оценке техник сжатия LLM

Исследователи из Microsoft Research, Индия, предлагают новый подход к оценке техник сжатия LLM путем введения метрик расстояния, таких как KL-дивергенция и процент переворотов, в дополнение к традиционным метрикам точности. Этот подход обеспечивает более всестороннюю оценку того, насколько близко сжатые модели имитируют свои базовые аналоги. Основное новшество заключается в идентификации и количественной оценке переворотов, которые служат интуитивно понятной и легко интерпретируемой метрикой отклонения модели. Сосредоточившись на качественных и количественных аспектах производительности модели, этот подход гарантирует, что сжатые модели поддерживают высокие стандарты надежности и применимости в различных задачах.

Эксперименты и результаты

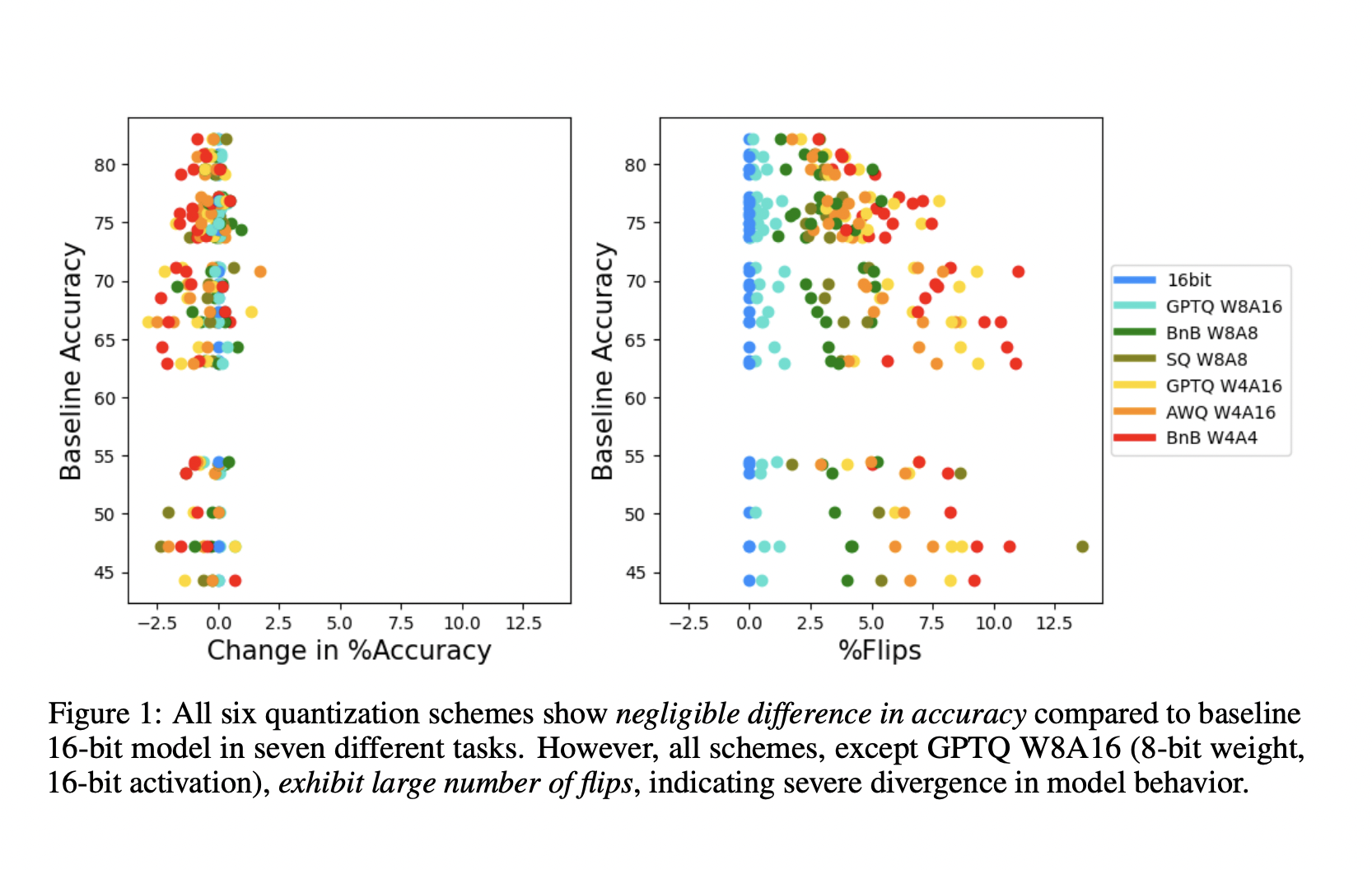

В рамках исследования были проведены эксперименты с использованием нескольких LLM (например, модели Llama2 и Yi chat) и различных техник квантизации (например, LLM.int8, GPTQ, AWQ). Исследователи оценили эти техники на нескольких задачах, включая MMLU, ARC, PIQA, Winogrande, Hellaswag и Lambada. Метрики оценки включают точность, путаницу, перевороты и KL-дивергенцию. В результате было выявлено, что, хотя различия в точности между базовыми и сжатыми моделями часто незначительны (≤2%), процент переворотов может быть значительным (≥5%), указывая на существенное отклонение в поведении модели.

Практическое применение

В заключение, предложенный метод вносит значительный вклад в исследования по ИИ, предлагая более всестороннюю систему оценки техник сжатия LLM. Он выявляет ограничения, связанные с полаганием только на метрики точности, и вводит метрики переворотов и KL-дивергенции для более полного учета отклонений модели. Этот подход гарантирует, что сжатые модели поддерживают высокую надежность и применимость, развивая область ИИ путем решения критической проблемы оценки модели.

Посмотреть статью можно здесь. Все права на это исследование принадлежат его авторам. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему каналу в Telegram и группе в LinkedIn.

Если вам нравится наша работа, вам понравится и наша рассылка.

Не забудьте присоединиться к нашему сообществу более чем 46 тыс. человек в подразделе по ИИ на Reddit.

Источник: MarkTechPost