«`html

Переосмысление эффективности нейронных сетей: от подсчета параметров к практической подгонке данных

Нейронные сети, несмотря на свою теоретическую способность подгонять тренировочные наборы с количеством образцов, равным количеству параметров, часто не справляются на практике из-за ограничений в процессах обучения. Этот разрыв между теоретическим потенциалом и практической производительностью представляет существенные вызовы для приложений, требующих точной подгонки данных, таких как медицинская диагностика, автономное вождение и модели языка масштаба.

Текущие методы решения гибкости нейронных сетей включают в себя перепараметризацию, сверточные архитектуры, различные оптимизаторы и функции активации, такие как ReLU.

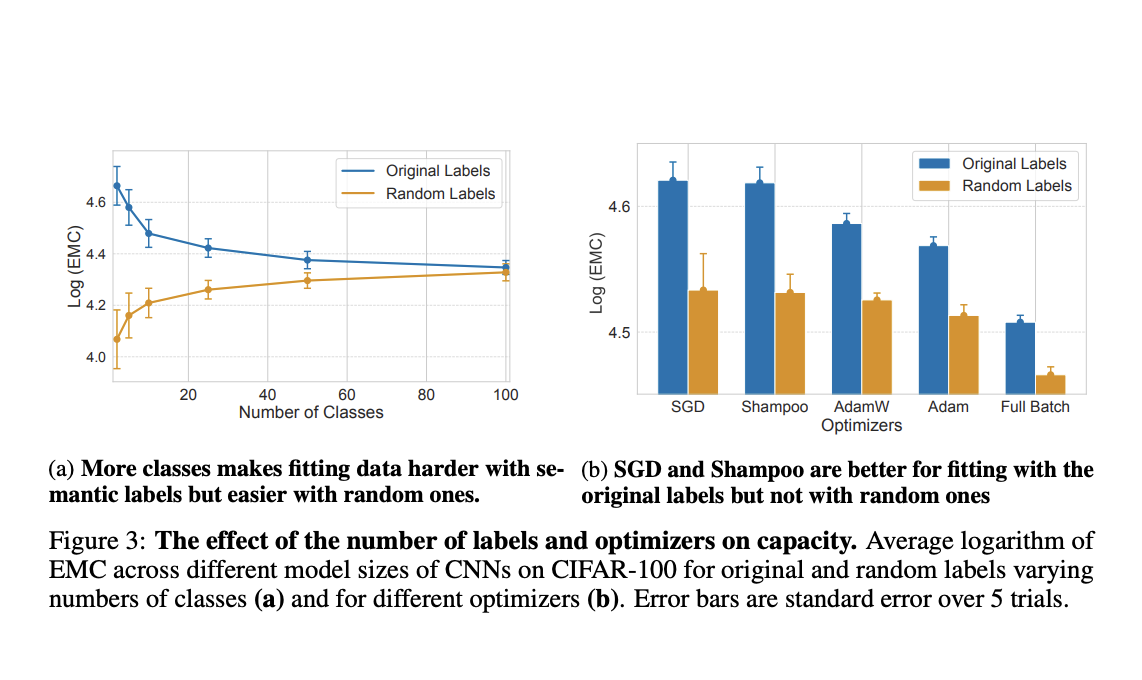

Однако эти методы имеют заметные ограничения. Перепараметризованные модели, хотя теоретически способны к универсальной аппроксимации функций, часто не достигают оптимальных минимумов на практике из-за ограничений в алгоритмах обучения. Сверточные сети, хотя и более параметрически эффективны, чем MLP и ViTs, не полностью используют свой потенциал на случайно размеченных данных. Оптимизаторы, такие как SGD и Adam, традиционно считаются регуляризующими, но на самом деле они могут ограничивать способность сети подгонять данные. Кроме того, функции активации, разработанные для предотвращения затухания и взрыва градиентов, непреднамеренно ограничивают возможности подгонки данных.

Команда исследователей из Нью-Йоркского университета, Университета Мэриленда и Capital One предлагает комплексное эмпирическое исследование возможности подгонки данных нейронных сетей с использованием метрики Effective Model Complexity (EMC).

Эта новаторская методика измеряет максимальный размер выборки, который модель может идеально подогнать, учитывая реалистичные циклы обучения и различные типы данных. Систематическое оценивание влияния архитектур, оптимизаторов и функций активации предлагаемых методов предлагает новое понимание гибкости нейронных сетей.

Метрика EMC рассчитывается путем итеративного подхода, начиная с небольшого набора обучающих данных и постепенно увеличивая его до тех пор, пока модель не перестанет достигать 100% точности обучения.

Это метод применяется на нескольких наборах данных, включая MNIST, CIFAR-10, CIFAR-100 и ImageNet, а также на табличных наборах данных, таких как Forest Cover Type и Adult Income. Ключевые технические аспекты включают использование различных архитектур нейронных сетей (MLP, CNN, ViT) и оптимизаторов (SGD, Adam, AdamW, Shampoo). Исследование гарантирует, что каждый цикл обучения достигает минимум функции потерь, проверяя нормы градиентов, стабильность потерь обучения и отсутствие отрицательных собственных значений в гессиане потерь.

Исследование раскрывает значительные идеи: стандартные оптимизаторы ограничивают возможность подгонки данных, в то время как CNN более параметрически эффективны, даже на случайных данных.

Функции активации ReLU обеспечивают лучшую подгонку данных по сравнению с сигмоидальными активациями. Сверточные сети (CNN) продемонстрировали превосходную способность подгонять тренировочные данные по сравнению с многослойными персептронами (MLP) и Vision Transformers (ViTs), особенно на наборах данных с семантически согласованными метками.

Более того, CNN, обученные стохастическим градиентным спуском (SGD), подгоняют больше образцов обучения, чем те, которые обучены полным градиентным спуском, и эта способность предсказывала лучшую обобщенность. Эффективность CNN особенно проявилась в их способности подгонять больше правильно помеченных образцов по сравнению с неправильно помеченными, что свидетельствует о их способности к обобщению.

В заключение, предложенные методы предоставляют комплексную эмпирическую оценку гибкости нейронных сетей, вызывая сомнения в традиционном мнении о их способности подгонять данные. Исследование вводит метрику EMC для измерения практической способности, раскрывая, что CNN более параметрически эффективны, чем это ранее считалось, и что оптимизаторы и функции активации значительно влияют на подгонку данных. Эти идеи имеют существенные последствия для улучшения обучения нейронных сетей и проектирования архитектуры, решая критическую проблему в исследованиях в области ИИ.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter.

Присоединяйтесь к нашему каналу в Telegram и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему субреддиту по машинному обучению с более чем 45 тысячами подписчиков.

Попробуйте AI Sales Bot. Этот AI-ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab. Будущее уже здесь!

«`