«`html

Как внедрить искусственный интеллект для улучшения бизнеса

Исследователи из Университета Торонто и Института Вектор используют Twisted Sequential Monte Carlo (SMC), мощную модель для вероятностного вывода в языковых моделях, которая решает проблемы различных задач с помощью интеллектуальных подходов.

Решения для бизнеса

1. Анализ результатов и опыта: Начните с малого проекта и оцените его влияние на ключевые показатели эффективности. После анализа результатов расширьте использование искусственного интеллекта.

2. Выбор подходящего решения: Определите, где и как можно применить автоматизацию. Внедряйте решения постепенно, начиная с маленьких проектов, и анализируйте их влияние.

3. Советы по внедрению ИИ: Пишите нам на Telegram для получения советов. Следите за новостями об ИИ в нашем Телеграм-канале.

4. AI Sales Bot: Попробуйте AI Sales Bot, который помогает автоматизировать процессы в отделе продаж, отвечать на вопросы клиентов и генерировать контент.

5. Искусственный интеллект в продажах: Узнайте, как использование ИИ от saile.ru может изменить процесс продаж в вашей компании.

«`

«`html

Contrastive Twist Learning and Bidirectional SMC Bounds: A New Paradigm for Language Model Control

Large language models (LLMs) have made significant success in various language tasks, but steering their outputs to meet specific properties remains a challenge. Researchers are attempting to solve the problem of controlling LLM generations to satisfy desired characteristics across a wide range of applications.

Prior attempts to solve language model steering challenges include diverse decoding methods, controlled generation techniques, and reinforcement learning-based approaches.

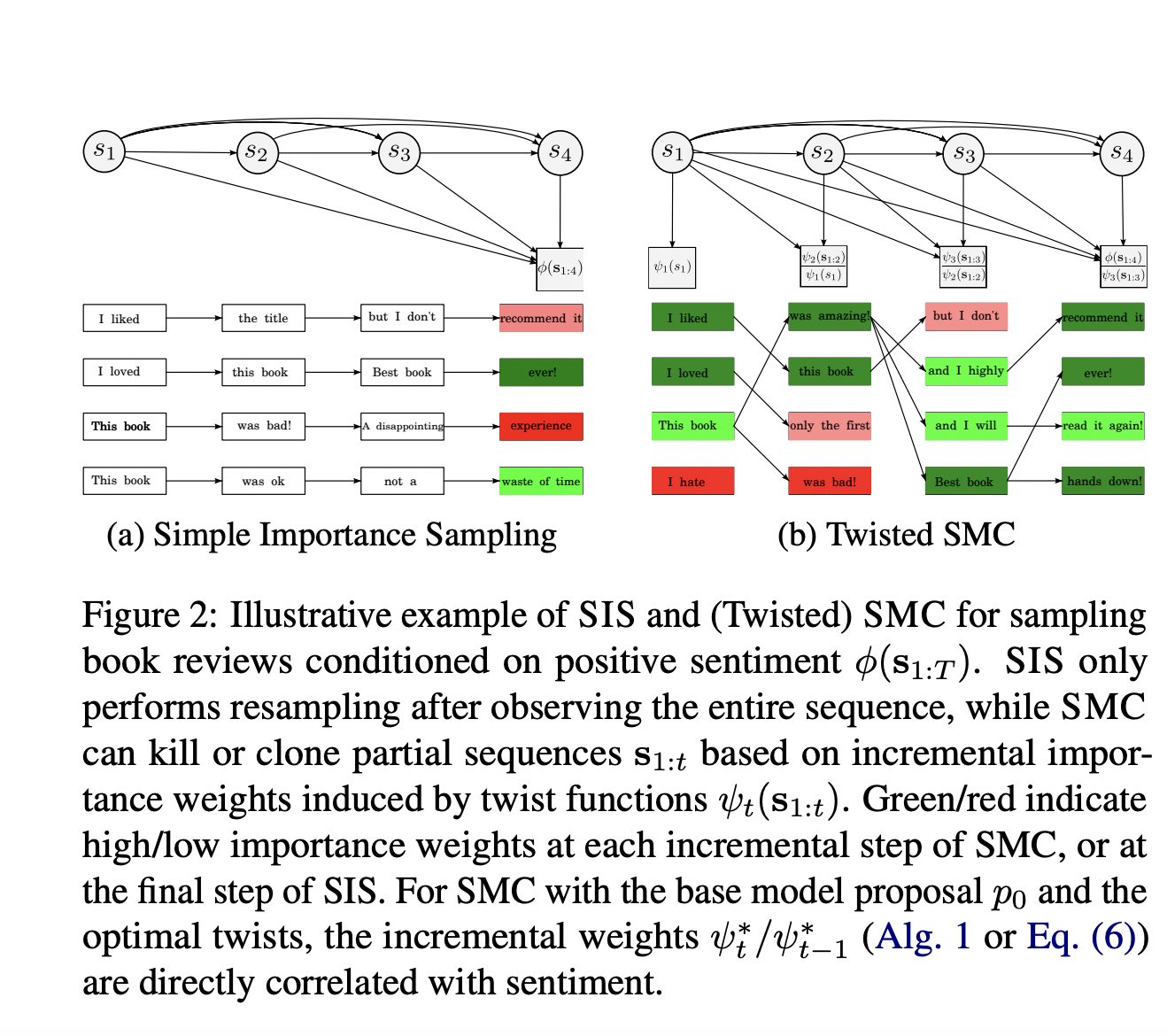

Researchers from the University of Toronto and Vector Institute utilize Twisted Sequential Monte Carlo (SMC), a powerful framework for probabilistic inference in language models. This approach addresses the challenge of sampling from non-causal target distributions by learning twist functions that modulate the base model to match target marginals. By utilizing concepts from energy-based modeling and density ratio estimation, the framework introduces unique techniques like contrastive twist learning (CTL) and adapts existing twisted SMC methods to the language modeling context.

Twisted SMC introduces the concept of twist functions to represent intermediate target distributions in language model sampling. These twist functions ψt modulate the base model p0 to approximate the target marginals σ(s1:t) at each step.

Twisted SMC shares connections with reinforcement learning, particularly soft RL with KL regularization.

The study evaluated the effectiveness of Twisted SMC and various inference methods across different language modelling tasks, including toxic story generation, sentiment-controlled review generation, and text infilling.

«`