«`html

Language Learning Models (LLMs) and Confidence Estimations

Модели обучения языку (LLMs) хорошо рассуждают и дают правильные ответы, но иногда допускают ошибки и могут «галлюцинировать» при новых вопросах. Важно получить надежные оценки уверенности от LLMs, особенно при ответах, содержащих более одного токена.

Подходы к получению уверенности от LLMs

Существуют подходы на основе обучения и подходы на основе запросов, которые используются для получения уверенности от LLMs. Однако существующие методы часто дают менее чем идеальные оценки уверенности, которые не отражают степень уверенности моделей.

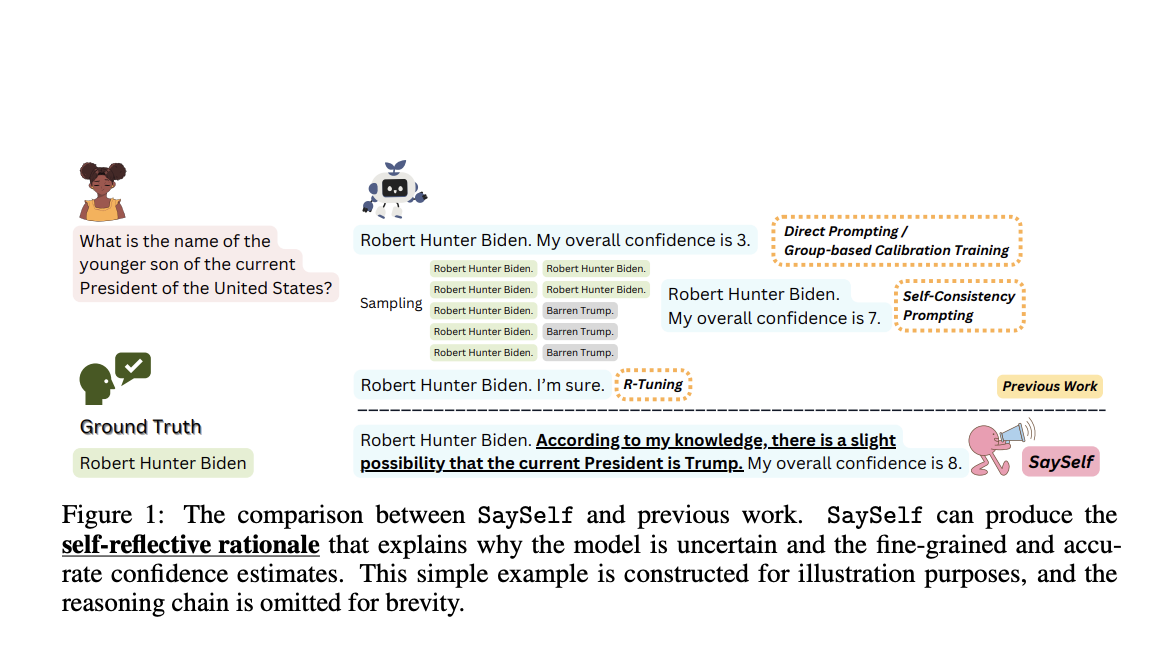

Новое исследование и решение SaySelf

Исследование от университетов Purdue, University of Illinois Urbana-Champaign, University of Southern California и The Hong Kong University of Science and Technology представляет SaySelf, обучающую платформу для LLMs, которая помогает им давать уверенные оценки с повышенной точностью. SaySelf позволяет LLMs предоставлять самоаналитические обоснования, показывающие их недостаток знаний и объясняющие уровень уверенности.

Практические применения

Используя различные задачи, такие как сложные медицинские диагнозы или анализ юридических случаев, SaySelf поддерживает производительность, снижая ошибки калибровки уверенности. LLMs могут использовать самоаналитические обоснования для улучшения взаимодействия и производительности.

Внедрение решения

После завершения процесса обучения SaySelf, ожидается значительное улучшение процедур обучения и разработка алгоритмов, улучшающих результаты обучения LLMs через их взаимодействие с людьми.

Более подробно ознакомиться с исследованием.

Все права на исследование принадлежат исследователям проекта.

Не забудьте подписаться на наш Twitter.

«`

«`html

Пробуйте AI Sales Bot здесь. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`