«`html

Generative Large Language Models (LLMs) and In-Context Learning

Исследователи из Мичиганского университета и Флоридского института человека и машинного когнитивизма представили рамочный подход для изучения механизмов контекстного обучения в больших языковых моделях (LLMs). Они сосредоточились на задачах регрессии, показав, что LLMs способны решать задачи на реальных данных, не ограничиваясь только задачами связанными с текстовой продукцией или классификацией.

Mеханизмы контекстного обучения

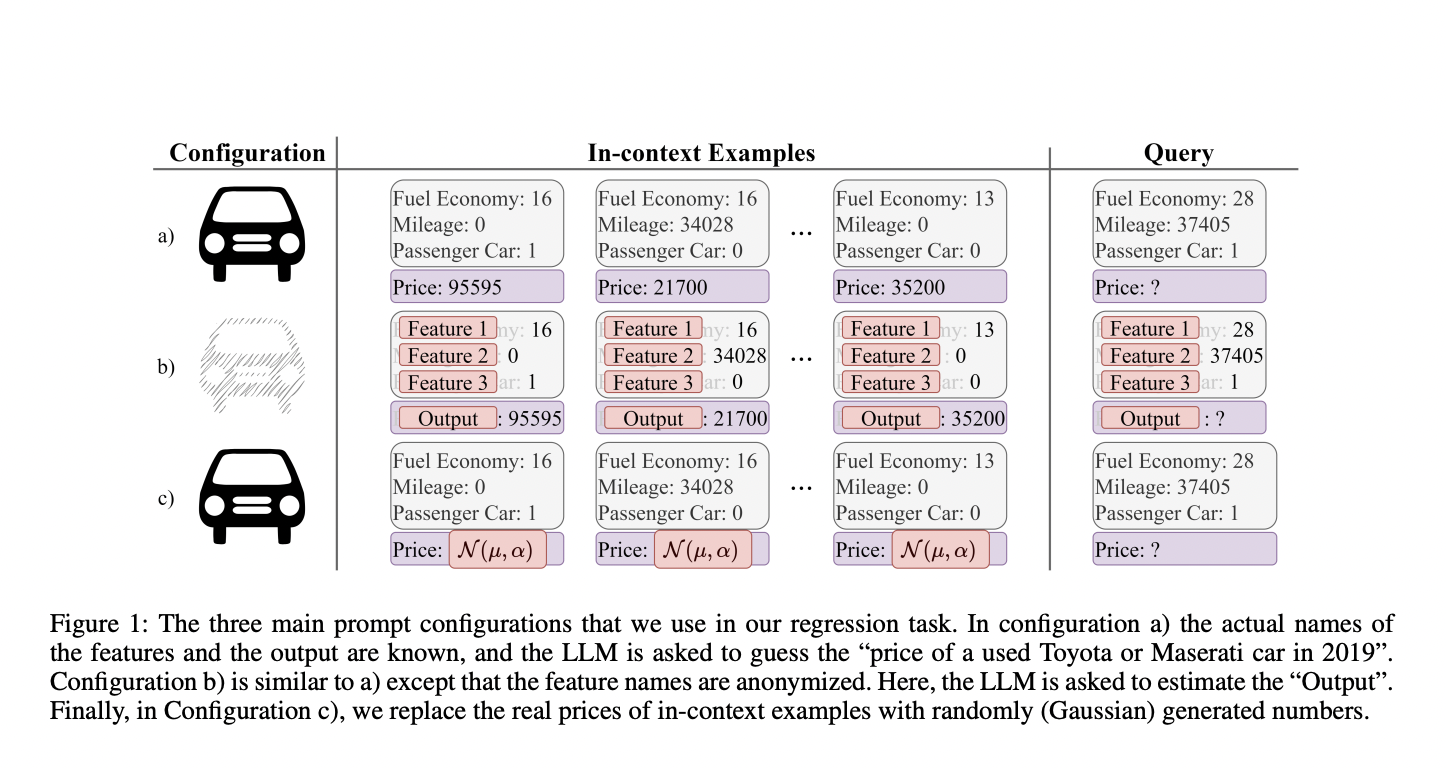

Исследователи предложили метод сравнения различных механизмов контекстного обучения, чтобы оптимизировать производительность LLMs. Они выделили два процесса: восстановление внутренней информации и обучение на примерах, данного в контексте. Такой подход помог систематически сравнить различные механизмы контекстного обучения LLMs.

Оптимизация производительности

Исследователи выделили, что возможно повысить производительность LLMs через инжиниринг запросов и настройку баланса между доступом к внутренним знаниям и обучением на новых примерах, в зависимости от конкретной задачи. Разработчики могут использовать эти знания для выполнения более широкого спектра задач и улучшения способности модели к обучению новых паттернов и поиску соответствующей информации.

Результаты и выводы

Исследователи продемонстрировали, что LLMs успешно справляются с задачами регрессии на реальных данных через контекстное обучение. Они разработали уникальную теорию, объединяющую механизмы контекстного обучения, что помогло сделать выводы более последовательными. Кроме того, была предложена методология для более полного тестирования и извлечения инсайтов.

«`