«`html

Улучшение обучения больших языковых моделей с помощью патч-уровневого обучения

Большой прирост объема обучающих данных, необходимых для обучения больших языковых моделей (LLM), в сочетании с их выдающейся способностью, позволил им достичь значительных успехов в понимании и генерации языка. Эффективность обучения больших языковых моделей является ключевой темой, поскольку масштабирование существенно увеличивает затраты на вычисления. Однако до сих пор остается сложным снизить затраты на обучение без ухудшения производительности модели, даже при непрерывных попытках создания эффективных LLM.

Патч-уровневое обучение как решение

Для повышения эффективности обучения LLM исследователи из Центра распознавания образов, WeChat AI, Tencent Inc. представляют патч-уровневое обучение в своем исследовании. Основная идея метода заключается в сжатии множества токенов в один патч для сокращения последовательности. Этот метод основан на трансферном обучении, которое помогает минимизировать затраты на обучение путем передачи информации от модели с более низкими затратами на обучение (уровень патча) к модели с более высокими затратами на обучение (уровень токена).

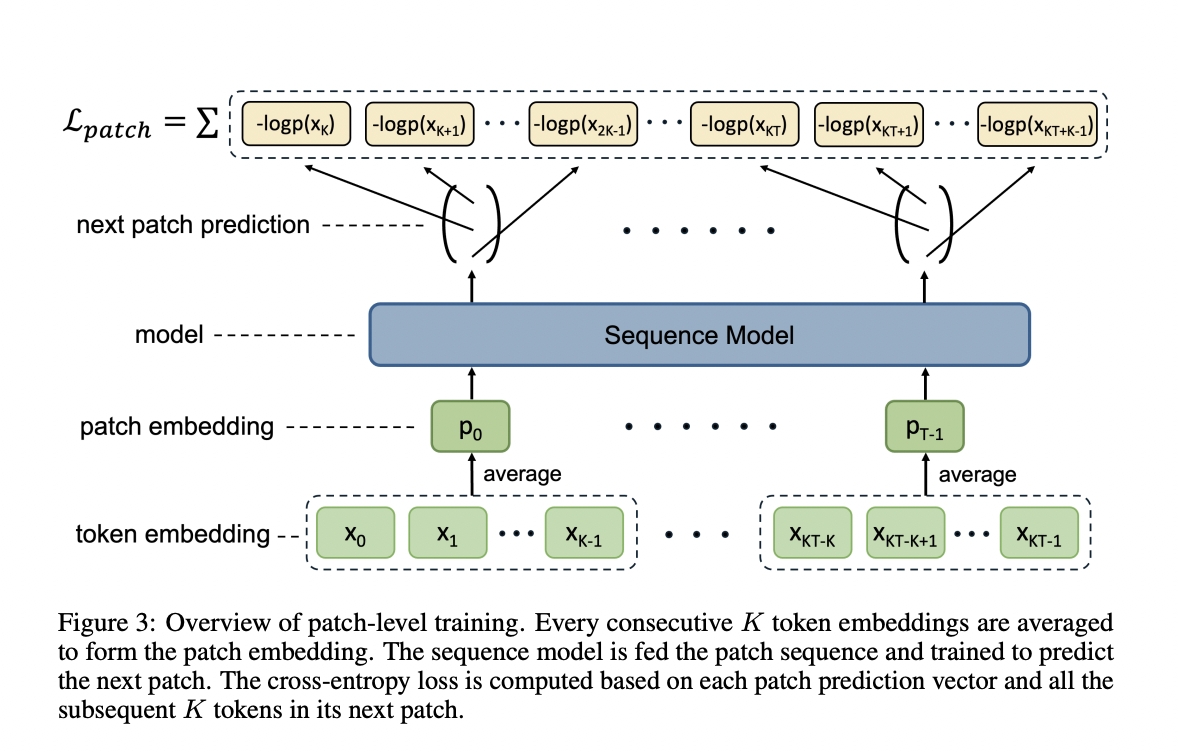

Предлагаемый подход включает два основных компонента: обучение на уровне патча и обучение на уровне токена. Во время обучения на уровне патча языковая модель обучается предсказывать следующий патч, анализируя более короткие последовательности патчей. Это позволяет анализировать большую часть обучающих данных с значительно меньшими вычислительными затратами. Модель на уровне токена затем инициализируется параметрами, полученными из обучения на уровне патча, и продолжает обучение, используя информацию, полученную с уровня патча, на уровне токена.

Новый метод повышает эффективность обучения за счет прогнозирования всех токенов в следующем патче одновременно. Согласно экспериментальным результатам, эта техника может снизить затраты на обучение LLM на 50%, сохраняя при этом производительность.

Практические применения

Если вы хотите узнать, как внедрить искусственный интеллект в свой бизнес, обращайтесь к нам. Мы предлагаем решения для автоматизации и улучшения эффективности процессов с помощью ИИ. Начните с малого проекта, анализируйте результаты и постепенно расширяйте использование ИИ-решений.

Попробуйте наш AI Sales Bot, который поможет снизить нагрузку на ваш отдел продаж и улучшить обслуживание клиентов. Подписывайтесь на наш Telegram-канал и следите за новостями в Twitter, чтобы быть в курсе последних разработок в области искусственного интеллекта.

«`