«`html

Автоматизация математического рассуждения в искусственном интеллекте

Автоматизация математического рассуждения давно является целью искусственного интеллекта. Формальные фреймворки, такие как Lean 4, Isabelle и Coq, играют значительную роль в этом процессе. Они позволяют пользователям писать машинно-проверяемые доказательства математических теорем, предоставляя структурированную среду для решения сложных проблем. Разработка нейронных теоремных доказателей, которые стремятся автоматизировать этот процесс, требует строгих бенчмарков для оценки их эффективности и дальнейших исследований.

Проблема в AI-теоремных доказательствах

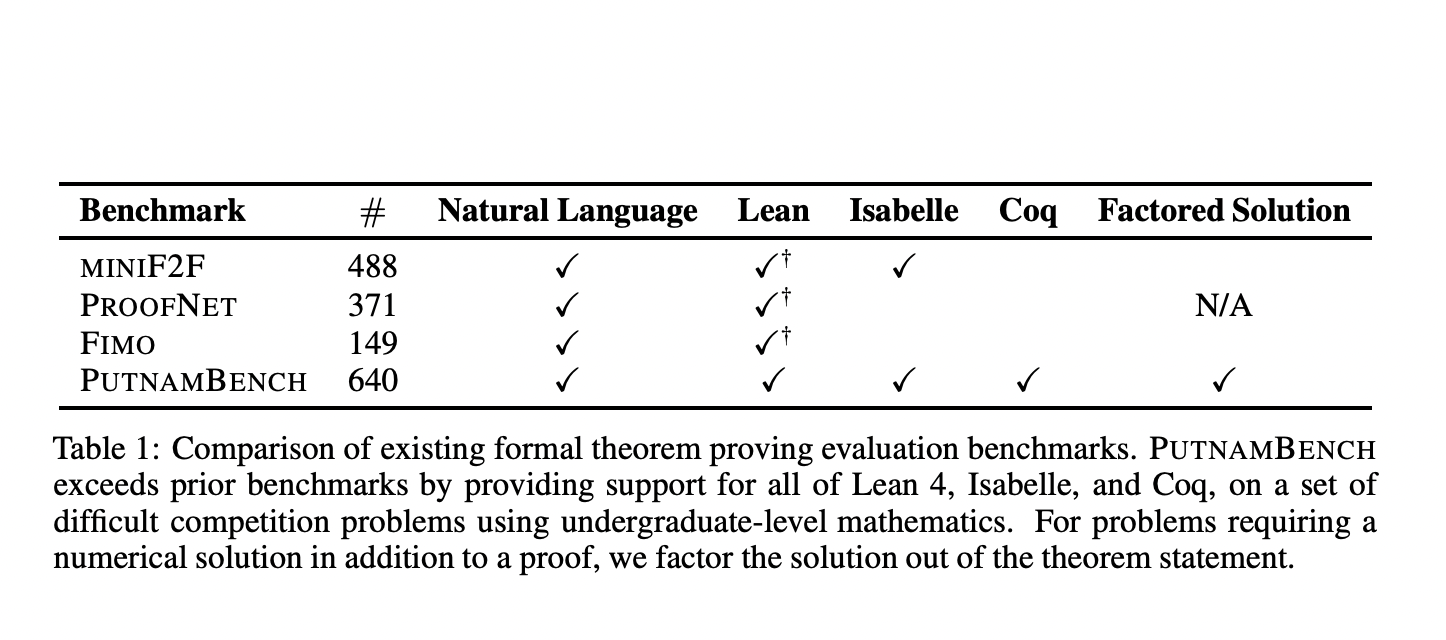

Критической проблемой в AI-теоремных доказательствах является отсутствие комплексных бенчмарков, которые бы вызывали эти системы на более сложные математические задачи. Существующие бенчмарки, такие как MINI F2F и FIMO, в основном фокусируются на математике уровня старших классов школы и должны достаточно тестировать возможности нейронных теоремных доказателей на более сложных, уровня университета. Этот разрыв требует создания более надежного бенчмарка, охватывающего более широкий спектр математических задач.

PUTNAMBENCH: новый бенчмарк

Исследователи из Университета Техаса в Остине представили PUTNAMBENCH, новый бенчмарк, разработанный для оценки нейронных теоремных доказателей с использованием задач из математического конкурса Уильяма Лоуэлла Патнема. Этот конкурс известен в Северной Америке своими сложными математическими задачами уровня колледжа, что делает его идеальным источником для строгого бенчмарка. PUTNAMBENCH включает 1697 формализаций 640 задач, доступных в Lean 4 и Isabelle, а значительная часть также в Coq. Такой многоязычный подход обеспечивает всестороннюю оценку в различных средах теоремных доказательств.

Оценка PUTNAMBENCH

Оценка PUTNAMBENCH включала несколько нейронных и символьных теоремных доказателей, включая Draft-Sketch-Prove, COPRA, GPT-4, Sledgehammer и Coqhammer. Эти методы были протестированы на 1697 формализациях, и результаты показали, что текущие методы могут решить лишь небольшую часть задач PUTNAMBENCH.

Заключение

PUTNAMBENCH, предоставляя разнообразный набор формализаций задач конкурса Патнема на нескольких формальных языках доказательств, устраняет ограничения существующих бенчмарков и устанавливает новый стандарт строгости и всесторонности. Результаты текущих оценок показывают, что, несмотря на прогресс, еще многое предстоит сделать в развитии нейронных теоремных доказателей способных решать сложные математические задачи. PUTNAMBENCH будет несомненно играть важную роль в дальнейших исследованиях и инновациях.

Источник изображения: ссылка

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему Telegram-каналу и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему подпреддиту ML.

Статья UT Austin Researchers Introduce PUTNAMBENCH: A Comprehensive AI Benchmark for Evaluating the Capabilities of Neural Theorem-Provers with Putnam Mathematical Problems была опубликована на MarkTechPost.

«`

![15 лучших примеров резюме и биографии для LinkedIn [+ как написать свое]](https://saile.ru/wp-content/uploads/2025/04/itinai.com_beautiful_Russian_high_fashion_Sales_representativ_5a6ff8d2-08f2-4b29-8680-5d11879ec2ec_3-200x200.png)