«`html

Решения для продаж и маркетинга с помощью искусственного интеллекта (ИИ)

WTU-Eval: Новый стандартный инструмент для оценки возможностей использования больших языковых моделей LLMs

Большие языковые модели (LLMs) отлично справляются с различными задачами, включая генерацию текста, перевод и сжатие. Однако растущей проблемой в области обработки естественного языка (NLP) является то, как эти модели могут эффективно взаимодействовать с внешними инструментами для выполнения задач, выходящих за рамки их врожденных возможностей.

Одной из основных проблем является процесс принятия решений LLMs относительно использования внешних инструментов. В реальных сценариях часто неясно, необходим ли инструмент. Неправильное или излишнее использование инструмента может привести к значительным ошибкам и неэффективности. Поэтому основная проблема последних исследований заключается в улучшении способности LLMs различать свои границы возможностей и принимать точные решения относительно использования инструментов. Это улучшение критически важно для поддержания производительности и надежности LLMs в практических приложениях.

Традиционные методы улучшения использования инструментов LLMs сосредотачивались на настройке моделей для конкретных задач, где использование инструмента обязательно. Техники, такие как обучение с подкреплением и деревья решений, показали свою эффективность, особенно в математическом рассуждении и поиске в Интернете. Были разработаны бенчмарки, такие как APIBench и ToolBench, для оценки умения LLMs работать с API и реальными инструментами. Однако эти бенчмарки обычно предполагают, что использование инструмента всегда необходимо, что не отражает неопределенность и изменчивость, с которыми сталкиваются в реальных сценариях.

Исследователи из Университета Бэйцзин, Университета Фучжоу и Института автоматизации КАС представили бенчмарк оценки использования инструментов Whether-or-not tool usage Evaluation (WTU-Eval), чтобы заполнить этот разрыв. Этот бенчмарк разработан для оценки гибкости принятия решений LLMs относительно использования инструментов. WTU-Eval включает одиннадцать наборов данных, из которых шесть явно требуют использования инструмента, в то время как пять остальных являются общими наборами данных, которые можно решить без инструментов. Такая структура позволяет провести подробную оценку способности LLMs различать, когда использование инструмента необходимо. Бенчмарк включает задачи, такие как машинный перевод, математическое рассуждение и поиск в реальном времени, предоставляя надежную основу для оценки.

Исследовательская группа также разработала набор данных для настройки моделей из 4000 примеров, полученных из тренировочных наборов данных WTU-Eval. Этот набор данных предназначен для улучшения способности LLMs принимать решения относительно использования инструментов. Путем настройки моделей на этом наборе данных исследователи ставили своей целью улучшить точность и эффективность LLMs в распознавании моментов использования инструментов и эффективном интегрировании результатов инструментов в свои ответы.

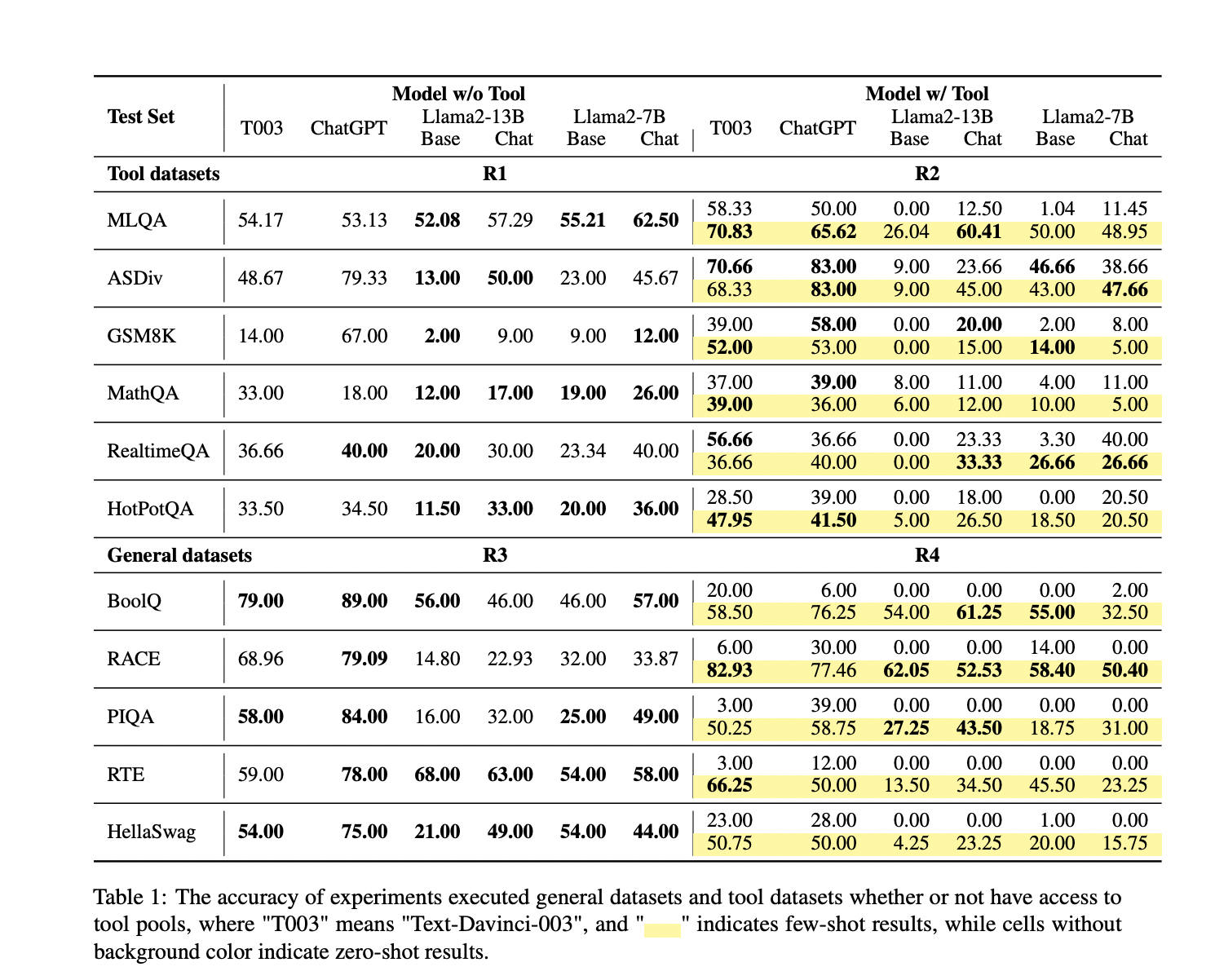

Оценка восьми ведущих LLMs с использованием WTU-Eval выявила несколько ключевых результатов. Во-первых, большинству моделей требуется помощь в определении использования инструмента в общих наборах данных. Например, производительность модели Llama2-13B упала до 0% на некоторых вопросах об использовании инструмента в настройке zero-shot, что подчеркивает сложности, с которыми сталкиваются LLMs в таких сценариях. Однако модели улучшили свою производительность в наборах данных, требующих использования инструмента, когда их способности более тесно соответствовали моделям, таким как ChatGPT. Настройка модели Llama2-7B привела к среднему улучшению производительности на 14% и уменьшению неправильного использования инструмента на 16.8%. Это улучшение особенно заметно в наборах данных, требующих поиска информации в реальном времени и математических расчетов.

Дальнейший анализ показал, что различные инструменты оказывали разное влияние на производительность LLMs. Например, более простые инструменты, такие как переводчики, управлялись более эффективно LLMs, в то время как более сложные инструменты, такие как калькуляторы и поисковые системы, представляли большие вызовы. В настройке zero-shot профессионализм LLMs значительно уменьшился с увеличением сложности инструментов. Например, производительность модели Llama2-7B упала до 0% при использовании сложных инструментов в некоторых наборах данных, в то время как ChatGPT показал значительные улучшения до 25% в задачах, таких как GSM8K, когда инструменты использовались правильно.

Тщательный процесс оценки бенчмарка WTU-Eval предоставляет ценные познания в ограничения использования инструментов LLMs и потенциальные улучшения. Дизайн бенчмарка, включающий смесь использования инструментов и общих наборов данных, позволяет подробно оценить способности моделей принятия решений. Успех набора данных для настройки в улучшении производительности подчеркивает важность целенаправленного обучения для улучшения решений LLMs относительно использования инструментов.

В заключение, исследование подчеркивает критическую необходимость для LLMs развивать лучшие способности принятия решений относительно использования инструментов. Бенчмарк WTU-Eval предлагает комплексную основу для оценки этих способностей, показывая, что хотя настройка может значительно улучшить производительность, многие модели по-прежнему испытывают трудности в точном определении своих границ возможностей. Дальнейшая работа должна сосредоточиться на расширении бенчмарка с добавлением большего количества наборов данных и инструментов, а также на изучении различных типов LLMs для улучшения их практических применений в различных реальных сценариях.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter и присоединиться к нашему Telegram-каналу и группе LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка..

Не забудьте присоединиться к нашему 46k+ ML SubReddit

Найдите предстоящие вебинары по ИИ здесь

Источник: Image Source

Источник: Image Source

«`