«`html

Parameter-efficient fine-tuning (PEFT) methods в машинном обучении

Методы эффективной настройки параметров (PEFT) стали неотъемлемыми в машинном обучении. Они позволяют большим моделям адаптироваться к новым задачам без обширных вычислительных ресурсов. Путем настройки только небольшого подмножества параметров и сохранения большей части модели замороженной, методы PEFT нацелены на улучшение эффективности и доступности процесса адаптации. Этот подход критически важен для развертывания крупных основных моделей, иначе ограниченных высокими вычислительными затратами и обширным количеством параметров.

Проблема исследования и методы PEFT

Основная проблема, решаемая в исследовании, — это заметный разрыв в производительности между методами адаптации низкого ранга, такими как LoRA, и полной настройкой моделей машинного обучения. Хотя LoRA, что означает адаптацию низкого ранга, известен своей эффективностью, он часто уступает в производительности по сравнению с полностью настроенными моделями. Это ограничивает более широкое применение LoRA в различных областях, где критически важна высокая производительность. Исследователи исследовали различные техники. Текущие методы PEFT включают настройку адаптера и настройку призыва. Настройка адаптера включает в себя вставку небольших обучаемых модулей, или адаптеров, в определенные слои модели. Эти адаптеры настраиваются, в то время как остальная часть модели остается замороженной, что значительно уменьшает объем памяти, необходимый для настройки. С другой стороны, настройка призыва адаптирует модели путем добавления обучаемых призывов или токенов к входным данным, избегая прямых изменений параметров модели. Среди этих методов LoRA выделяется переопределением изменений веса во время настройки в произведение двух матриц низкого ранга, тем самым уменьшая количество обучаемых параметров.

LoRA-Pro: новый метод для преодоления разрыва в производительности

Исследователи из Университета науки и технологий Китая и Института автоматизации Китайской академии наук и Университета Китайской академии наук представили новый метод — LoRA-Pro. Этот новаторский метод устраняет разрыв в производительности между LoRA и полной настройкой. LoRA-Pro улучшает оптимизацию LoRA, вводя «Эквивалентный градиент». Этот концепт позволяет исследователям измерить различия в процессе оптимизации между LoRA и полной настройкой, а затем минимизировать эти различия для улучшения производительности. Таким образом, LoRA-Pro обеспечивает близкое к полной настройке имитирование процесса настройки.

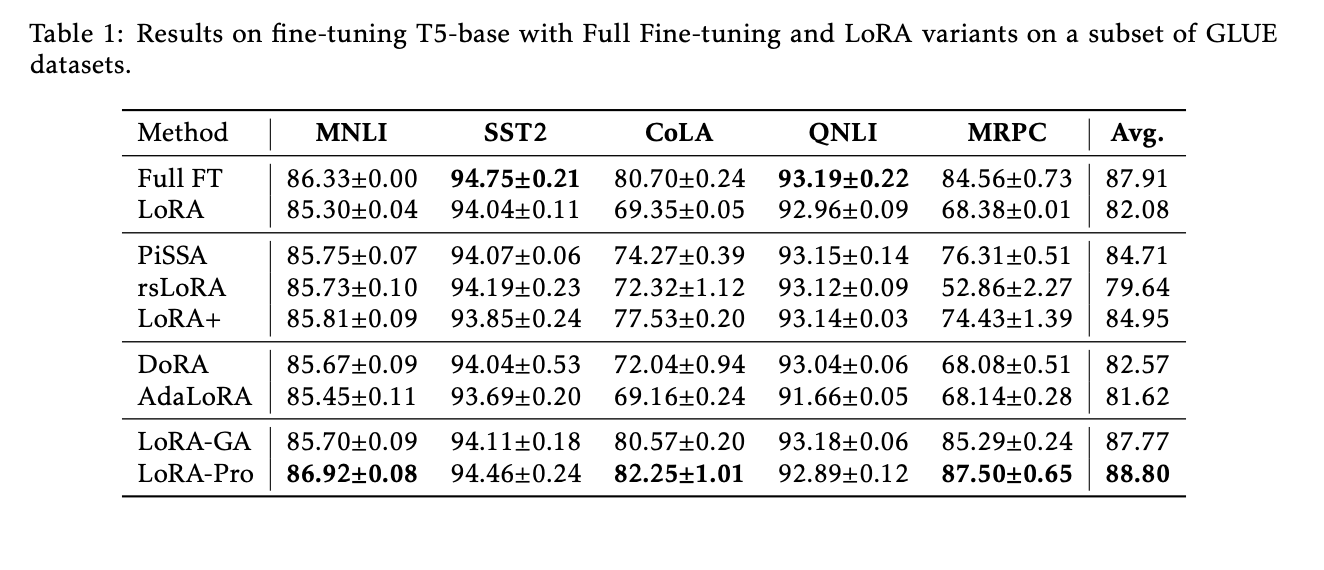

Экспериментальная проверка и результаты

Эффективность LoRA-Pro была подтверждена через обширные эксперименты на задачах обработки естественного языка. Метод был протестирован на модели T5-base с использованием подмножества наборов данных GLUE. Результаты показали, что LoRA-Pro достиг наивысших баллов на трех из пяти наборов данных, превысив стандартный LoRA на 6,72%. В частности, LoRA-Pro показал 86,92% на MNLI, 94,46% на SST-2 и 87,50% на MRPC, продемонстрировав свою превосходную производительность. Эти результаты подчеркивают способность LoRA-Pro сократить разрыв в производительности по сравнению с полной настройкой, что делает его значительным улучшением существующих методов PEFT.

Заключение

Введение LoRA-Pro является существенным прорывом в эффективной настройке параметров. Решая оптимизационные недостатки LoRA и вводя концепцию Эквивалентного градиента, исследователи разработали метод, который устраняет разрыв в производительности между LoRA и полной настройкой. Обширная экспериментальная проверка подтверждает, что LoRA-Pro сохраняет эффективность LoRA и достигает производительности, близкой к полной настройке. Это делает LoRA-Pro ценным инструментом для развертывания крупных основных моделей более ресурсоэффективным способом.

Источник изображения: ссылка

Проверьте статью. Вся заслуга за это исследование принадлежит его ученым. Также не забудьте подписаться на нас в Twitter и присоединиться к нашему Telegram-каналу и группе LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 47k+ ML SubReddit

Найдите предстоящие вебинары по ИИ здесь

Оригинальная публикация: LoRA-Pro: A Groundbreaking Machine Learning Approach to Bridging the Performance Gap Between Low-Rank Adaptation and Full Fine-Tuning, MarkTechPost.

«`

«`html

Как использовать LoRA-Pro для развития вашего бизнеса с помощью искусственного интеллекта (ИИ)

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь, какие ключевые показатели эффективности (KPI) вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`