Улучшение эффективности выводов LLM в многоязычных средах

Проблема

При развертывании LLM в многоязычных контекстах возникает проблема высокого времени вывода. Это связано с различиями в токенизации и размерах словарей между языками, что замедляет отклик LLM и увеличивает вычислительные затраты.

Решение

Исследователи предложили инновационный подход к многоязычной спекулятивной декодировке, используя стратегию предварительного обучения и донастройки. Этот метод позволяет ускорить процесс перевода и обеспечить точность выводов.

Результаты

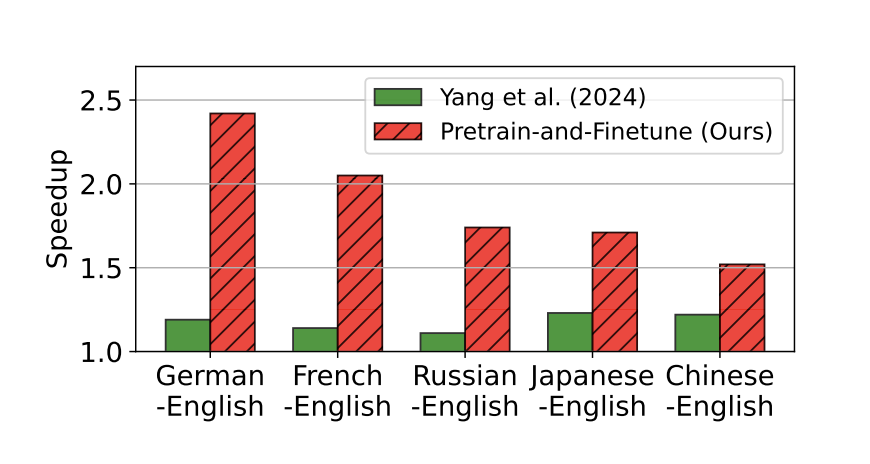

Эксперименты показали значительное снижение времени вывода LLM в среднем в 1,89 раза по сравнению со стандартными методами авторегрессивного декодирования. Предложенный подход продемонстрировал ускорение в 2,42 раза при переводе между некоторыми языковыми парами, такими как немецкий-английский и французский-английский.