«`html

Введение в Long-form RobustQA Dataset и RAG-QA Arena

Вопросно-ответная система (QA) в области обработки естественного языка (NLP) играет важную роль в разработке систем, способных точно извлекать и генерировать ответы на запросы пользователей из обширных источников данных. Retrieval-augmented generation (RAG) улучшает качество и актуальность ответов, комбинируя информационный поиск с генерацией текста. Этот подход фильтрует нерелевантную информацию и представляет только наиболее подходящие отрывки для генерации ответов большими языковыми моделями (LLM).

Основные проблемы в QA и их решения

Одной из основных проблем в QA является ограниченный объем существующих наборов данных, которые часто используют корпуса из одного источника или фокусируются на кратких, извлекаемых ответах. Текущие методы, такие как Natural Questions и TriviaQA, сильно полагаются на Википедию или веб-документы, что недостаточно для оценки обобщения LLM между различными областями. В результате существует значительная потребность в более комплексных оценочных критериях, способных проверять устойчивость систем QA в различных областях.

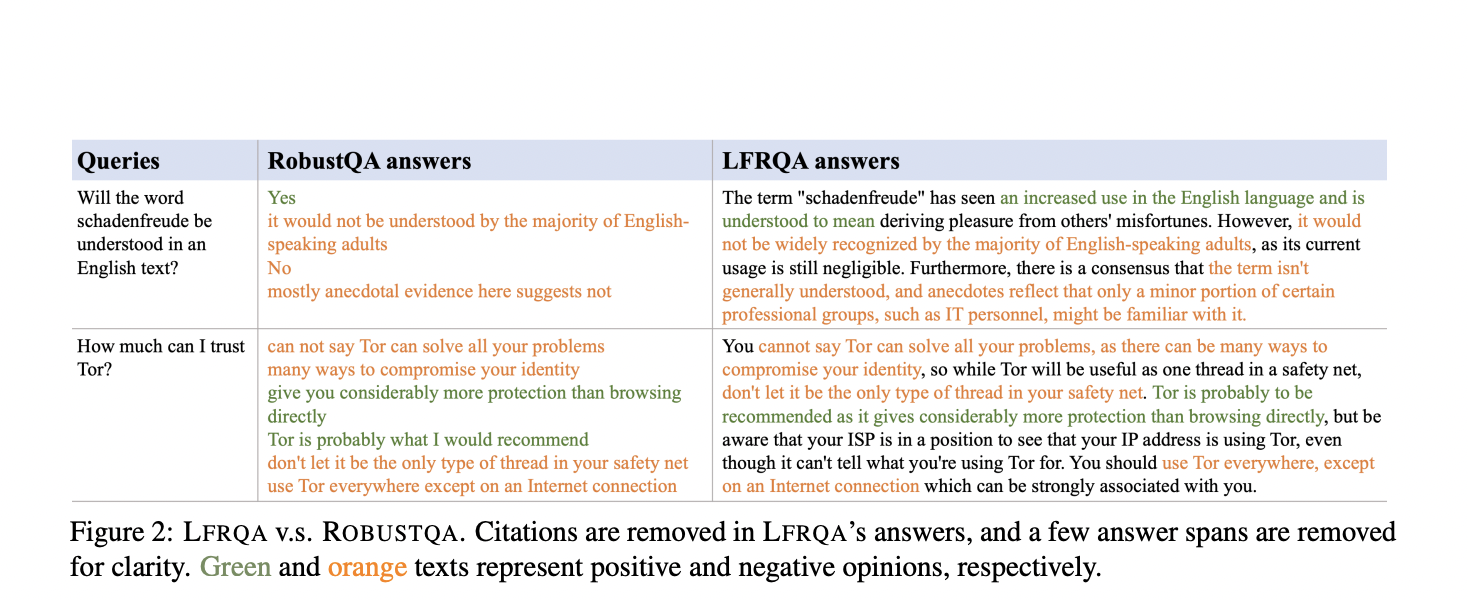

Long-form RobustQA (LFRQA) и его преимущества

Исследователи из AWS AI Labs, Google, Samaya.ai, Orby.ai и Университета Калифорнии в Санта-Барбаре представили набор данных Long-form RobustQA (LFRQA), который включает в себя длинные ответы, написанные людьми, интегрирующие информацию из нескольких документов в последовательные повествования. Охватывая 26 000 запросов в семи областях, LFRQA направлен на оценку возможностей обобщения LLM-основанных систем RAG-QA между областями.

Фреймворк RAG-QA Arena и его применение

Исследовательская группа представила фреймворк RAG-QA Arena для использования LFRQA в оценке систем QA. Этот фреймворк использует модельные оценщики для прямого сравнения ответов, сгенерированных LLM, с ответами, написанными людьми в LFRQA. Фокусируясь на длинных, последовательных ответах, RAG-QA Arena предоставляет более точную и сложную оценку для систем QA. Обширные эксперименты продемонстрировали высокую корреляцию между модельными и человеческими оценками, подтверждая эффективность фреймворка.

Результаты и преимущества LFRQA

Результаты показали, что только 41,3% ответов, сгенерированных конкурентоспособными LLM, предпочтительнее, чем длинные ответы, написанные людьми в LFRQA. Кроме того, оценка выявила, что ответы LFRQA, интегрирующие информацию из до 80 документов, предпочтительны в 59,1% случаев по сравнению с ведущими ответами LLM. Фреймворк также выявил разрыв в 25,1% в производительности между внутриобластными и междуобластными данными, подчеркивая важность оценки междуобластной устойчивости для развития надежных систем QA.

Заключение и перспективы

Исследование, проведенное AWS AI Labs, Google, Samaya.ai, Orby.ai и Университетом Калифорнии в Санта-Барбаре, выделяет ограничения существующих методов оценки QA и представляет LFRQA и RAG-QA Arena в качестве инновационных решений. Эти инструменты предлагают более комплексную и сложную оценку для оценки междуобластной устойчивости систем QA, внося значительный вклад в развитие исследований в области NLP и QA.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашему Telegram-каналу и группе LinkedIn. Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему 47k+ ML SubReddit.

Найдите предстоящие вебинары по ИИ здесь.

Опубликовано на MarkTechPost.

«`