«`html

Увеличение эффективности моделей LLM с помощью условных вычислений

Проблема

Большие языковые модели (LLM) в области обработки естественного языка (NLP) требуют большого объема вычислительных ресурсов из-за плотной архитектуры, что затрудняет их широкое распространение.

Решение

Использование условных вычислений, таких как метод Mixture-of-Experts (MoE) и активационные функции, позволяет улучшить эффективность моделей LLM, увеличивая их разреженность и снижая требования к вычислительным ресурсам.

Практические решения

1. Внедрение метода Mixture-of-Experts (MoE) для предварительной настройки модели, что позволяет селективно активировать определенные компоненты модели в зависимости от входных данных.

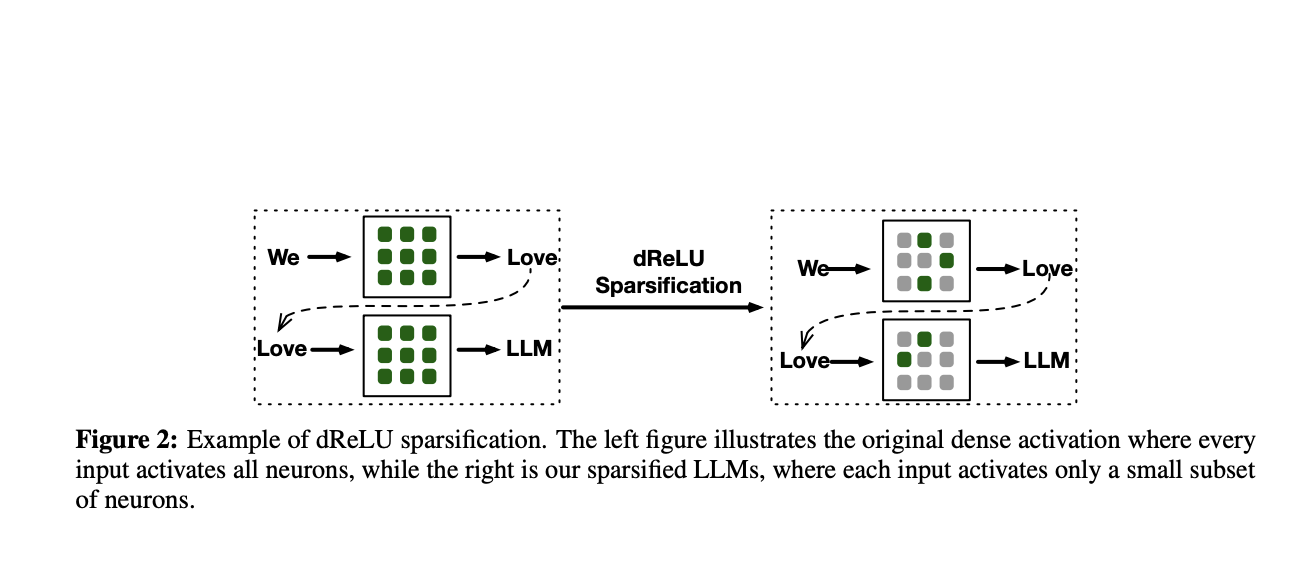

2. Использование активационных функций, таких как dReLU, для увеличения разреженности моделей и улучшения их производительности.

3. Создание моделей TurboSparse-Mistral-47B и TurboSparse-Mixtral-47B, демонстрирующих улучшенную производительность и сниженные требования к вычислительным ресурсам.

Значимость

Внедрение этих решений позволяет ускорить процессы генерации и улучшить производительность моделей LLM, что может значительно повысить эффективность бизнеса.

Подробнее ознакомиться с исследованием и моделями можно на сайте.

Следите за новостями в нашем Телеграм-канале и на Twitter.

Присоединяйтесь к нашему Телеграм-каналу и группе в LinkedIn.

Если вам нужна помощь во внедрении ИИ, обращайтесь к нам!

«`