«`html

Решение проблемы вычислительной неэффективности в обработке визуальных токенов в моделях Vision Transformer (ViT) и Video Vision Transformer (ViViT)

Проблема:

Одной из значительных проблем в исследованиях по искусственному интеллекту является вычислительная неэффективность при обработке визуальных токенов в моделях Vision Transformer (ViT) и Video Vision Transformer (ViViT). Эти модели обрабатывают все токены с равным вниманием, игнорируя врожденную избыточность визуальных данных, что приводит к высоким вычислительным затратам. Решение этой проблемы критично для развертывания моделей искусственного интеллекта в реальных приложениях, где ресурсы ограничены, а обработка в реальном времени необходима.

Решение:

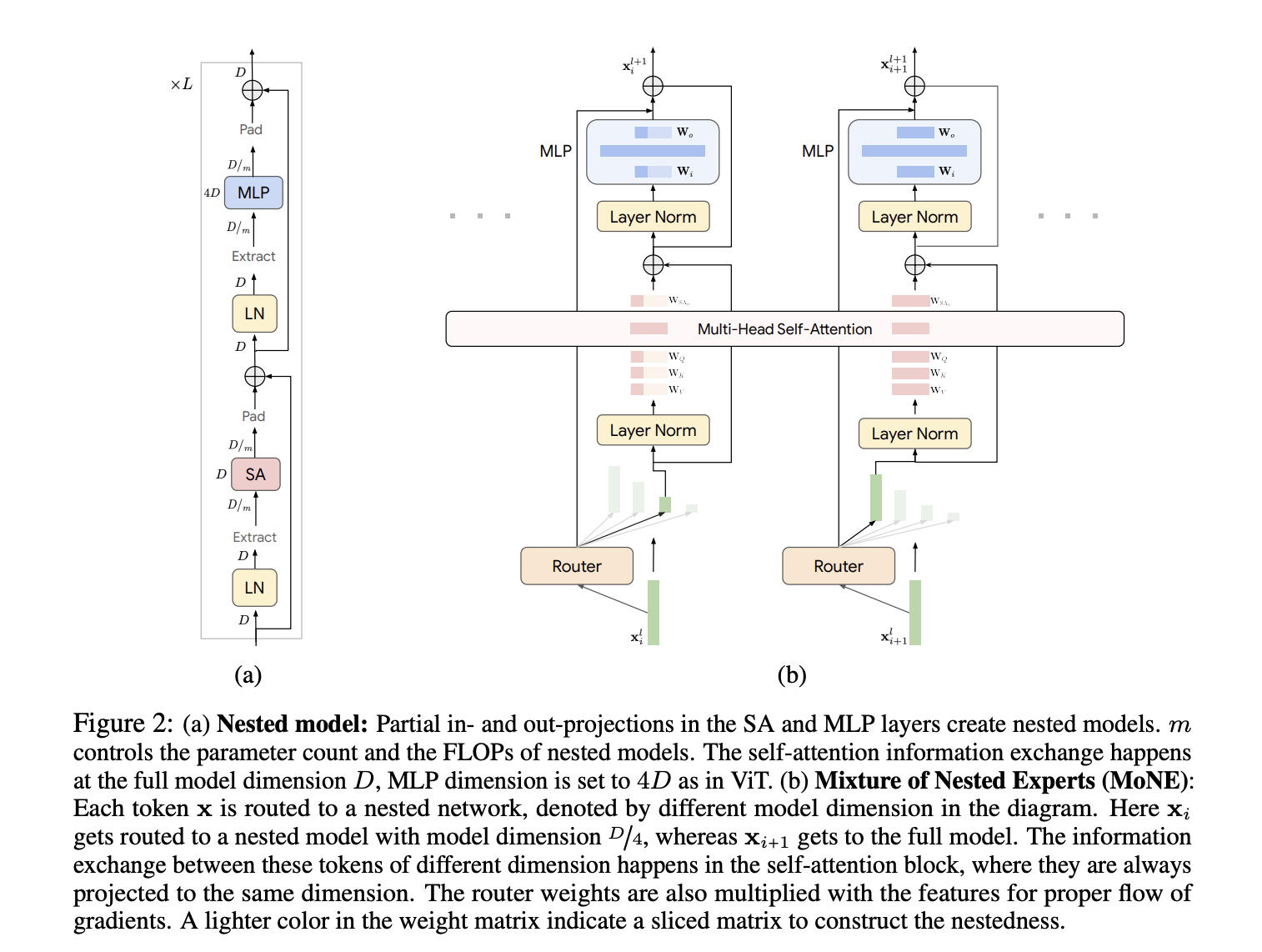

Команда исследователей из Google DeepMind и Университета Вашингтона предлагает фреймворк Mixture of Nested Experts (MoNE), который использует вложенную структуру экспертов для решения неэффективности существующих методов. MoNE динамически распределяет вычислительные ресурсы, направляя токены к различным вложенным экспертам в зависимости от их важности. Это позволяет обрабатывать избыточные токены через более маленькие, более дешевые модели, в то время как более важные токены направляются к более крупным, более детальным моделям. Новизна заключается в использовании вложенной архитектуры, которая сохраняет тот же объем параметров, что и базовые модели, но достигает двукратного снижения вычислительных затрат во время вывода. Этот адаптивный подход не только повышает эффективность, но также сохраняет производительность при различных вычислительных бюджетах.

Практическое применение:

MoNE интегрирует вложенную архитектуру в Vision Transformers, где эксперты с различными вычислительными возможностями располагаются иерархически. Каждый токен динамически направляется к соответствующему эксперту с использованием алгоритма Expert Preferred Routing (EPR). Модель обрабатывает токены через частичные входные и выходные проекции в слоях Self-Attention (SA) и MLP, обеспечивая эффективные вычисления. Фреймворк проходит валидацию на наборах данных, таких как ImageNet-21K, Kinetics400 и Something-Something-v2. Решения о маршрутизации принимаются на основе важности токенов, которая определяется распределением вероятностей сети маршрутизатора. Эффективность MoNE демонстрируется через тщательные эксперименты, показывающие высокую производительность при различных вычислительных бюджетах вывода.

Результаты:

Предложенный метод достигает значительных улучшений в вычислительной эффективности и производительности на различных наборах данных. На наборе данных ImageNet-21K MoNE достигает точности 87,5%, что существенно превосходит базовые модели. В задачах видеоклассификации, таких как Kinetics400 и Something-Something-v2, MoNE демонстрирует двукратное или трехкратное снижение вычислительных затрат, сохраняя или превосходя точность традиционных методов. Адаптивные возможности обработки MoNE позволяют ему поддерживать надежную производительность даже при ограниченных вычислительных бюджетах, демонстрируя его эффективность как в обработке изображений, так и видеоданных.

Заключение:

Фреймворк Mixture of Nested Experts (MoNE) предлагает значительное совершенствование в эффективной обработке визуальных токенов. Динамическое распределение вычислительных ресурсов в зависимости от важности токенов позволяет MoNE преодолеть ограничения существующих моделей ViT и MoE, достигая существенного снижения вычислительных затрат без ущерба для производительности. Это инновационное решение обладает большим потенциалом для улучшения реальных приложений искусственного интеллекта, делая высокопроизводительные модели более доступными и практичными. Вклад подтверждается тщательными экспериментами, демонстрирующими адаптивность и надежность MoNE на различных наборах данных и вычислительных бюджетах.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашей Telegram-группе и группе LinkedIn. Если вам нравится наша работа, вам понравится наш бюллетень.

Не забудьте присоединиться к нашему сообществу Reddit.

Найдите предстоящие вебинары по искусственному интеллекту здесь.

Источник: MarkTechPost

«`