«`html

Large Generative Graph Models (LGGMs): A New Class of Graph Generative Model Trained on a Large Corpus of Graphs

Недавно большие генеративные модели (LGM), такие как GPT, Stable Diffusion, Sora и Suno, сделали замечательные успехи в создании креативного и содержательного контента, значительно повышая эффективность реальных приложений. В отличие от ранее использовавшихся моделей, таких как Bert/Bart в обработке естественного языка (NLP) и Unet в сегментации изображений, которые обучались на небольших наборах данных из конкретных областей и для узких задач, успех этих LGM обусловлен их обширным обучением на тщательно подготовленных данных из различных областей. Учитывая огромный успех LGM в других областях и потенциальное практическое применение графовых генеративных моделей, естественно возникает вопрос: можно ли разработать большие генеративные модели для графовых данных?

Практические решения и ценность

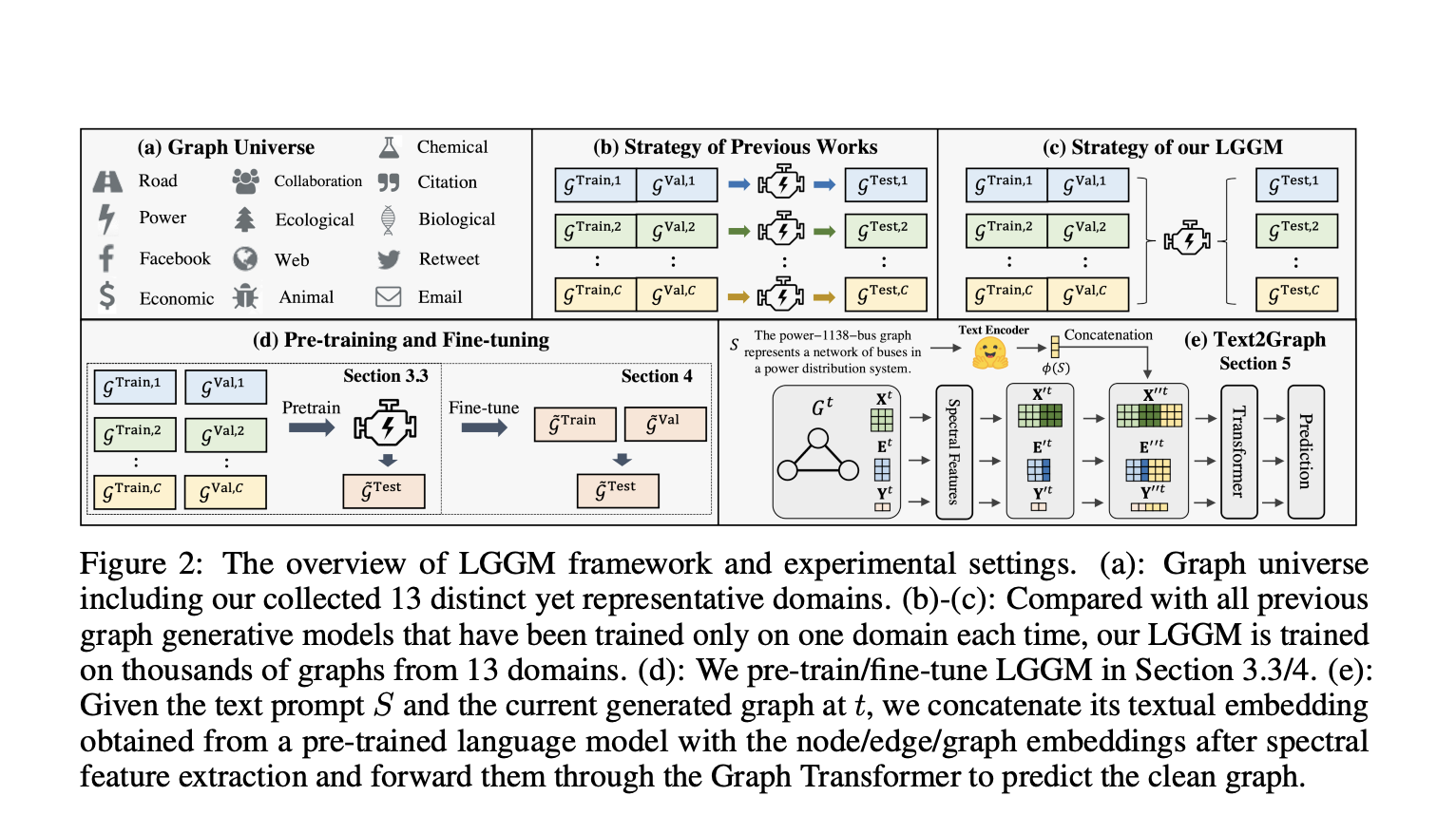

Исследователи из университетов Вандербильта, Мичигана, Adobe Research и Intel Labs представили LARGE GRAPH GENERATIVE MODEL (LGGM), новый класс графовой генеративной модели, обученной на большом корпусе графов из 13 различных областей. Предварительно обученная LGGM превосходит другие графовые генеративные модели в возможности генерации «с нуля» и может легко настраиваться на графы из конкретных областей, показывая лучшую производительность по сравнению с теми, которые обучались с нуля. LGGM может генерировать графы по текстовым запросам, таким как описание имени сети и области, а также статистику сети.

Способность генерировать текст в граф помогает пользователям более детально контролировать созданные графы. Кроме того, для обучения LGGM требуется большой, хорошо организованный корпус графов из различных областей. Графы выбираются из Network Repository в 13 различных областях, охватывающих широкий спектр реальных ситуаций, включая Facebook (FB), Animal Social (ASN), Email, Web, Road, Power, Chemical (CHEM) и др. Многие реальные графы содержат тысячи или даже миллионы узлов и рёбер. Однако продвинутые модели диффузии, такие как DiGress и GDSS, могут обрабатывать только сети с несколькими сотнями узлов. Для решения этой проблемы избирательно выбираются подграфы из определенных областей для управления проблемами масштабируемости.

Предварительно настроенная LGGM сравнивается с DiGress, обученным непосредственно в каждой области, чтобы показать практическое использование LGGM в генерации графов для реального применения. В большинстве областей LGGM показывает лучшую генеративную производительность на тех же графах для обучения благодаря большему объему знаний, использованных во время предварительного обучения. Это преимущество еще более заметно, когда доступно меньше графов. Это полезно, особенно в приложениях графовой генерации, которые включают полу-надзорные настройки, такие как создание программного обеспечения для обнаружения аномалий и разработка лекарств. В этих случаях соответствующие графы составляют всего 0,05%-0,5% и 0,01% от всех потенциальных кандидатов соответственно.

В заключение, исследователи предложили LGGM, новый класс графовой генеративной модели, обученной на более чем 5000 графах из 13 различных областей из известного Network Repository. LGGM превосходит другие графовые генеративные модели в возможности генерации «с нуля» и может легко настраиваться на графы из конкретных областей. Он также может генерировать текст в граф. Аналогично LGM в других областях, LGGM не специализируется на генерации графов для конкретных областей. Поэтому будущим направлением является оценка их практической полезности в прикладных аспектах, таких как создание высококачественных сгенерированных графов для улучшения аугментации данных.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу в 44k+ ML SubReddit

Источник: MarkTechPost