MagpieLM-Chat Модели

MagpieLM-4B-Chat-v0.1 и MagpieLM-8B-Chat-v0.1

Две новые модели языка, оптимизированные для выравнивания. Они обучены специально для того, чтобы их результаты соответствовали человеческим инструкциям, этическим стандартам и поведенческим ожиданиям.

Открытый и прозрачный подход

Команда сделала модели и все соответствующие данные, конфигурации и журналы доступными для публики. Это включает два критически важных набора данных: Supervised Fine-Tuning (SFT) и Direct Preference Optimization (DPO).

Конкурентоспособная производительность и бенчмаркинг

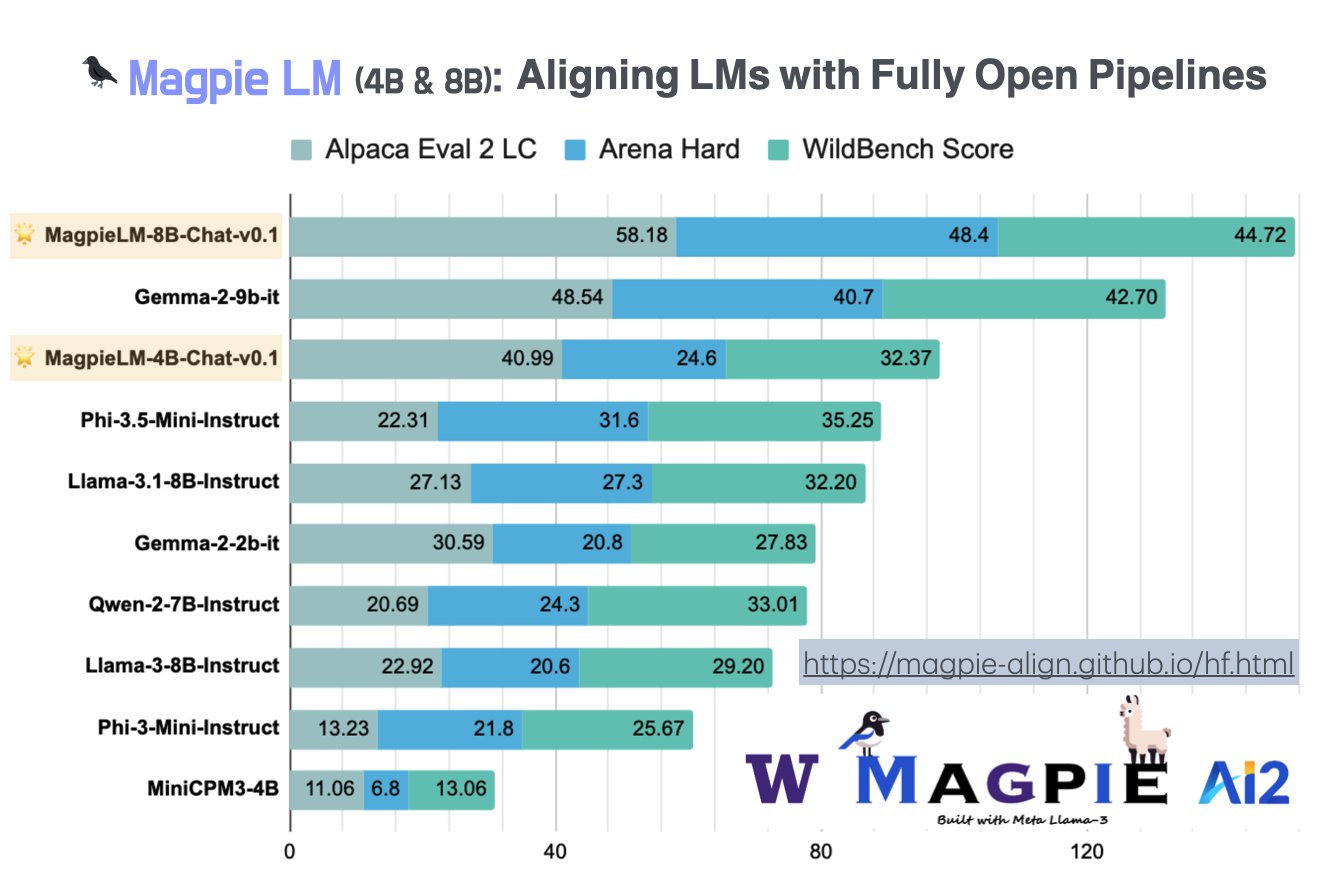

MagpieLM-Chat модели показали отличные результаты на нескольких ключевых бенчмарках оценки.

Выпуски: SFT-Data и DPO-Data

Команда также выпустила два крупных набора данных: MagpieLM-SFT-Dat-v0.1 и MagpieLM-DPO-Data-v0.1.

Выравнивание после обучения и синтетические данные

Метод Magpie фокусируется на выравнивании после обучения с использованием синтетических данных.

Дорога вперед: Совместимость данных и модели

Команда намекает, что будущие разработки будут сосредоточены на совместимости данных и модели.

Заключение

Выпуск моделей MagpieLM-Chat, как 4B, так и 8B версий, является значительным шагом в области выравнивания ИИ. Поддержанный Университетом Вашингтона, Ai2 и NVIDIA, этот проект предоставляет высокопроизводительные, открытые модели языка и предлагает исследовательскому сообществу ценные наборы данных и инструменты для изучения сложностей выравнивания ИИ. С сильными результатами на ведущих бенчмарках и приверженностью прозрачности проект MagpieLM-Chat готов повлиять на будущее выравнивания исследований в области ИИ. Открытость моделей и наборов данных устанавливает новый стандарт доступности в области ИИ, делая передовые исследования по выравниванию доступными для широкой аудитории и поощряя инновации во всей области.

![Как написать бизнес-план [Примеры и шаблон]](https://saile.ru/wp-content/uploads/2025/05/itinai.com_IT-company_office_background_blured_-chaos_50_-v_14a9a2fa-3bf8-4cd1-b2f6-5c758d82bf3e_0-200x200.avif)