«`html

Представляем Predibase Inference Engine

Predibase объявляет о запуске Predibase Inference Engine — новой платформы для управления тонко настроенными небольшими языковыми моделями (SLM). Этот движок значительно ускоряет развертывание SLM, делая процесс более масштабируемым и экономичным для предприятий, сталкивающихся с трудностями внедрения ИИ.

Ключевые преимущества:

- Ускорение развертывания: Быстрая и простая в масштабировании платформа.

- Экономия средств: Снижение затрат на инфраструктуру.

- Пользовательский опыт: Высокое качество обслуживания SLM.

Основные проблемы при развертывании LLM

С увеличением интеграции ИИ в бизнес-процессы, требования к эффективным и масштабируемым решениям становятся критическими:

- Проблемы с производительностью: Высокая нагрузка на обычные облачные GPU приводит к медленным ответам.

- Сложность инженерии: Необходимость самостоятельно управлять всей инфраструктурой.

- Высокие затраты на инфраструктуру: Дорогие GPU часто недоступны и требуют постоянных расходов.

Решение Predibase Inference Engine

Данный движок предназначен для оптимизации развертывания SLM и снижения затрат на инфраструктуру.

Технические достижения Predibase Inference Engine

- LoRAX: Позволяет обслуживать сотни тонко настроенных SLM с одного GPU, что снижает затраты на инфраструктуру.

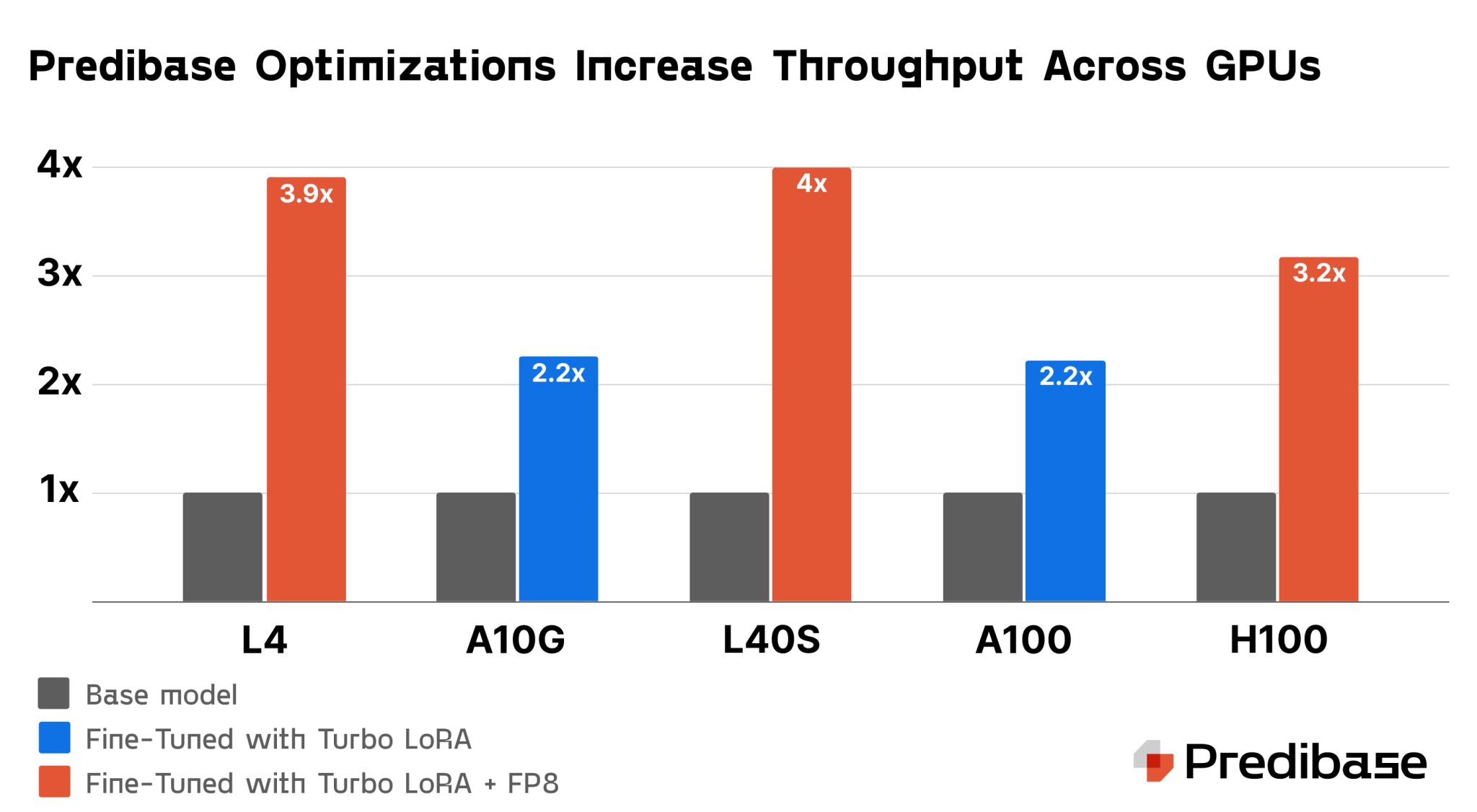

- Turbo LoRA: Увеличивает производительность в 2-3 раза, сохраняя высокое качество ответов.

- FP8 Квантование: Снижает размер модели на 50%, что позволяет обрабатывать больше запросов одновременно.

- Автошкалирование GPU: Динамическое распределение ресурсов в зависимости от реального спроса.

Преимущества автошкалирования GPU

Автошкалирование позволяет оптимизировать использование ресурсов, снижая затраты на развертывание. Это обеспечивает высокую производительность без переплат за неиспользуемую инфраструктуру.

Готовность к работе в предприятиях

Predibase Inference Engine предлагает готовые к использованию решения для больших компаний, включая интеграцию VPC и многорегиональную доступность.

Почему выбирают Predibase?

Predibase — ведущая платформа для обслуживания тонко настроенных LLM, обеспечивающая максимальную производительность и надежность. Если вы готовы улучшить развертывание LLM, Predibase Inference Engine — ваш выбор.

Контакты для получения советов по внедрению ИИ:

Если вам нужны советы по внедрению ИИ, пишите нам в Телеграм.

Узнайте, как ИИ может изменить процесс продаж в вашей компании с решением от saile.ru — будущее уже здесь!

«`