«`html

DiT-MoE: Новая версия архитектуры DiT для генерации изображений

Недавно модели диффузии стали мощным инструментом в различных областях, таких как генерация изображений и 3D-объектов. Их успех заключается в способности эффективно обрабатывать задачи денойзинга с различными типами шума, превращая случайный шум в целевое распределение данных через повторяющиеся шаги денойзинга. Используя структуры на основе трансформаторов, было показано, что добавление большего количества параметров обычно улучшает производительность. Однако обучение и запуск этих моделей затратны. Это связано с тем, что глубокие сети плотные, что означает, что каждый пример использует все параметры, что приводит к высоким вычислительным затратам при их масштабировании.

Практические решения и ценность

Текущий метод, Условные вычисления, является многообещающей техникой масштабирования, которая направлена на увеличение емкости модели при сохранении постоянных затрат на обучение и вывод. Это достигается путем использования только подмножества параметров для каждого примера. Еще один метод, Смесь экспертов (MoE), объединяет выводы подмоделей или экспертов через зависящий от входа маршрутизатор и успешно используется в различных областях. В области NLP было введено верхнее-к gating в LSTMs, вместе с вспомогательными потерями для сохранения баланса экспертов. Наконец, в MoE для моделей диффузии были проведены исследования с использованием нескольких экспертных моделей, каждая из которых фокусируется на определенном диапазоне временных интервалов.

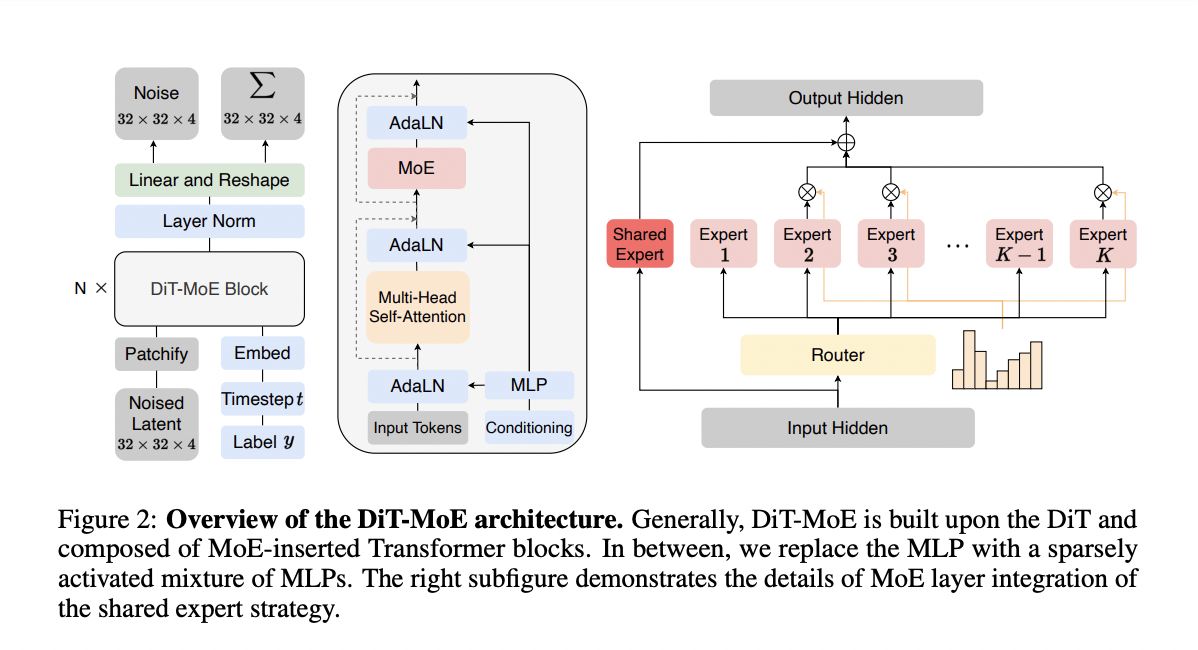

Исследователи из Kunlun Inc. Пекин, Китай, предложили DiT-MoE, новую версию архитектуры DiT для генерации изображений. DiT-MoE модифицирует некоторые плотные слои прямого распространения в DiT, заменяя их разреженными слоями MoE. В этих слоях каждый токен изображения направляется в конкретное подмножество экспертов, которые являются слоями MLP. Кроме того, архитектура включает два основных дизайна: один из них — общая часть экспертов для захвата общих знаний, а второй — балансировка потерь экспертов для уменьшения избыточности в различных маршрутизированных экспертах. В данной статье тщательно анализируется, как эти особенности позволяют обучать параметрически эффективную модель диффузии MoE и наблюдать некоторые увлекательные закономерности в маршрутизации экспертов с различных точек зрения.

Оптимизатор AdamW используется без весового затухания на всех наборах данных с постоянной скоростью обучения. Во время обучения используется экспоненциальное скользящее среднее (EMA) весов DiT-MoE с коэффициентом затухания 0.9999, и результаты основаны на этой модели EMA. Предложенные модели обучаются на графическом процессоре Nvidia A100 с использованием набора данных ImageNet различных разрешений. Кроме того, во время обучения применяются техники, такие как классификаторное руководство, и используется предварительно обученная модель вариационного автокодировщика от Stable Diffusion на huggingface2. Производительность генерации изображений оценивается с использованием расстояния Фрешера-Инцепции (FID), общепринятой метрики для оценки качества сгенерированных изображений.

Результаты оценки условной генерации изображений по различным метрикам показывают отличную производительность по сравнению с плотными конкурентами. На класс-условном наборе данных ImageNet 256×256 модель DiT-MoE достигает оценки FID 1.72, превосходя все предыдущие модели с различными архитектурами. Кроме того, DiT-MoE использует всего 1,5 миллиарда параметров и значительно превосходит конкурентов на основе трансформаторов, таких как Large-DiT-3B, Large-DiT-7B и LlamaGen-3B. Это показывает потенциал MoE в моделях диффузии. Подобные улучшения наблюдаются практически во всех метриках оценки на класс-условном наборе данных ImageNet 512×512.

В заключение, исследователи разработали DiT-MoE, обновленную версию архитектуры DiT для генерации изображений. DiT-MoE улучшает некоторые плотные слои прямого распространения в DiT, заменяя их разреженными слоями MoE. Этот метод использует разреженные условные вычисления для обучения больших моделей диффузии трансформаторов, что приводит к эффективному выводу и значительному улучшению задач генерации изображений. Также используются простые дизайны для эффективного использования разреженности модели на основе входов. В данной статье представлено начало исследования масштабных условных вычислений для моделей диффузии. Будущая работа включает в себя обучение более стабильных и быстрых гетерогенных архитектур экспертов и улучшение дистилляции знаний.

Проверьте статью и GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter и присоединиться к нашему Telegram-каналу и группе LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 46 тыс. подписчиков на ML SubReddit

Найдите предстоящие вебинары по ИИ здесь

Опубликовано на MarkTechPost.

Как использовать ИИ в вашем бизнесе

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте DiT-MoE: A New Version of the DiT Architecture for Image Generation.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`