«`html

Заголовок: Разработка и внедрение Large Vision Language Models (LVLMs)

Исследователи продвигаются в разработке Large Vision Language Models (LVLMs), которые объединяют визуальную и текстовую обработку информации. Однако текущие open-source LVLMs сталкиваются с ограничениями в сравнении с проприетарными моделями, такими как GPT-4, Gemini Pro и Claude 3.

Решения

Для решения этих проблем исследователи предлагают методы, такие как модели разговора текст-изображение, анализ изображений высокого разрешения и методы понимания видео. Также они исследуют генерацию веб-страниц и применение техник усиления обучения от обратной связи человека и оптимизации прямых предпочтений для мультимодальных LVLMs.

Практические применения

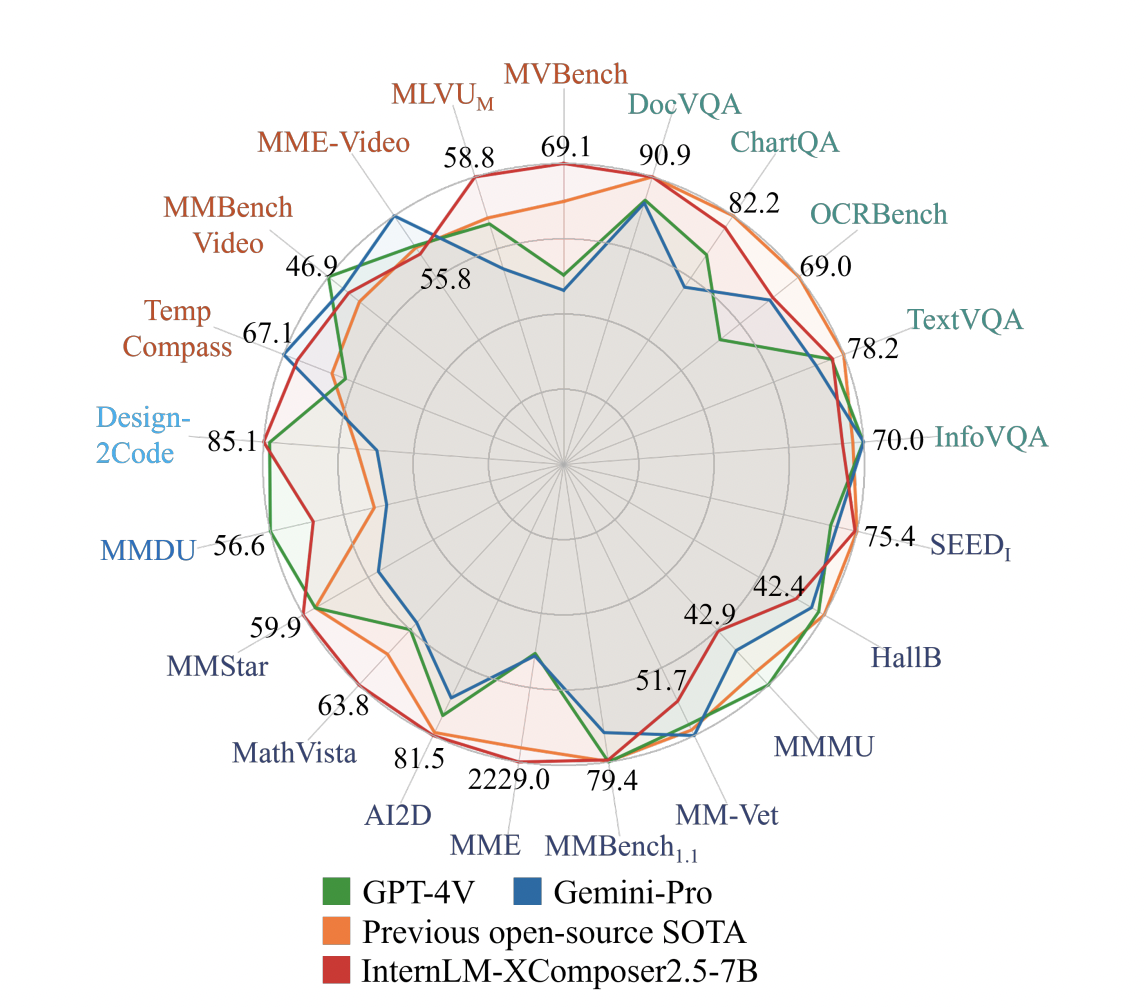

Исследователи из различных университетов и компаний представили модель InternLM-XComposer-2.5 (IXC-2.5), которая предлагает значительное развитие в области LVLMs. Модель отличается улучшенной способностью выполнять широкий спектр задач, таких как разговоры текст-изображение, OCR, понимание видео, создание статей и веб-страниц.

Преимущества модели IXC-2.5

Модель IXC-2.5 поддерживает окно контекста изображение-текст до 24К, расширяемое до 96К, что позволяет взаимодействовать с ИИ на длительных интервалах времени и создавать контент. Она также демонстрирует исключительную производительность в различных бенчмарках, включая понимание видео, создание веб-страниц, ответы на вопросы и трансляцию изображений в код.

Заключение

Модель IXC-2.5 представляет значительное развитие в области Large Vision Language Models, обладая возможностями для длительного контекстуального ввода и вывода. Это открывает путь для дальнейших исследований в области мультимодальной среды, обещая улучшить способность ИИ помогать людям в различных областях применения в реальном мире.

Подробнее о статье и коде на GitHub. Все права на это исследование принадлежат его авторам. Не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему каналу в Telegram и группе в LinkedIn.

Если вам понравилась наша работа, вам понравится и наша рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit

Опубликовано на MarkTechPost.

«`