«`html

Большие языковые модели (LLM) привлекли значительное внимание своей выдающейся производительностью в различных задачах, революционизируя исследовательские парадигмы. Однако процесс обучения этих моделей сталкивается с несколькими проблемами.

LLM зависят от статических наборов данных и требуют длительных периодов обучения, что требует большого количества вычислительных ресурсов. Например, обучение модели LLaMA 65B заняло 21 день с использованием 2048 A100 GPU и 80 ГБ оперативной памяти. Этот подход ограничивает способность модели адаптироваться к изменениям в составе данных или включать новую информацию. Поэтому важно разработать более эффективные и гибкие методики обучения для LLM, чтобы улучшить их адаптивность и снизить вычислительные затраты.

Система Aquila2 и фреймворк HeuriMentor

Исследователи из команды Language Foundation Model & Software в BAAI предложили серию моделей Aquila2, диапазон искусственных интеллект-моделей с размерами параметров от 7 до 70 миллиардов. Эти модели обучаются с использованием фреймворка HeuriMentor (HM), который содержит три основных компонента: (a) Адаптивный обучающий движок (ATE), (b) Монитор обучения (TSM) и (c) Управление данными (DMU). Эта система улучшает мониторинг процесса обучения модели и позволяет эффективно корректировать распределение данных, что делает обучение более эффективным. Фреймворк HM разработан для преодоления трудностей адаптации к изменениям в данных и включения новой информации, обеспечивая более гибкий и эффективный способ обучения LLM.

Особенности архитектуры Aquila2

Архитектура Aquila2 включает несколько важных особенностей для улучшения ее производительности и эффективности. Токенизатор использует словарь из 100 000 слов, выбранных на основе начальных экспериментов, и применяет кодировку Byte Pair Encoding (BPE) для извлечения этого словаря. Обучающие данные равномерно распределены между английским и китайским, используя наборы данных Pile и WudaoCorpus. Aquila2 использует механизм Grouped Query Attention (GQA), который повышает эффективность во время вывода по сравнению с традиционным механизмом многоголового внимания, сохраняя при этом аналогичное качество. Модель использует популярный метод LLM, называемый Rotary Position Embedding (RoPE), для позиционного встраивания. RoPE объединяет преимущества относительного и абсолютного кодирования позиций для эффективного захвата паттернов в последовательных данных.

Оценка производительности Aquila2

Производительность модели Aquila2 была тщательно оценена и сравнена с другими основными двуязычными (китайско-английскими) моделями, выпущенными до декабря 2023 года. Модели, включенные в сравнение, — Baichuan2, Qwen, LLaMA2 и InternLM, каждая имеющая уникальные характеристики и размеры параметров. Эти сравнения по различным наборам данных предоставляют подробный анализ возможностей Aquila2.

Выводы

Модель Aquila2-34B показывает высокую производительность в различных задачах обработки естественного языка, достигая самого высокого среднего показателя 68,09 в сравнительных оценках. Она хорошо справляется с задачами на английском (средний показатель 68,63) и китайском (средний показатель 76,56) языках. Aquila2-34B превосходит LLaMA2-70B в понимании билингвов, достигая высочайшего показателя 81,18 в задаче BUSTM. Кроме того, Aquila2-34B лидирует в сложной задаче HumanEval с показателем 39,02, указывающим на высокое понимание, схожее с человеческим. Оценка показывает, что модель Aquila2-34B демонстрирует конкурентные возможности в различных задачах, с близкими соревнованиями в задачах, таких как TNEWS и C-Eval. Эти результаты свидетельствуют о необходимости тщательной оценки в различных задачах для понимания возможностей модели и продвижения в области обработки естественного языка.

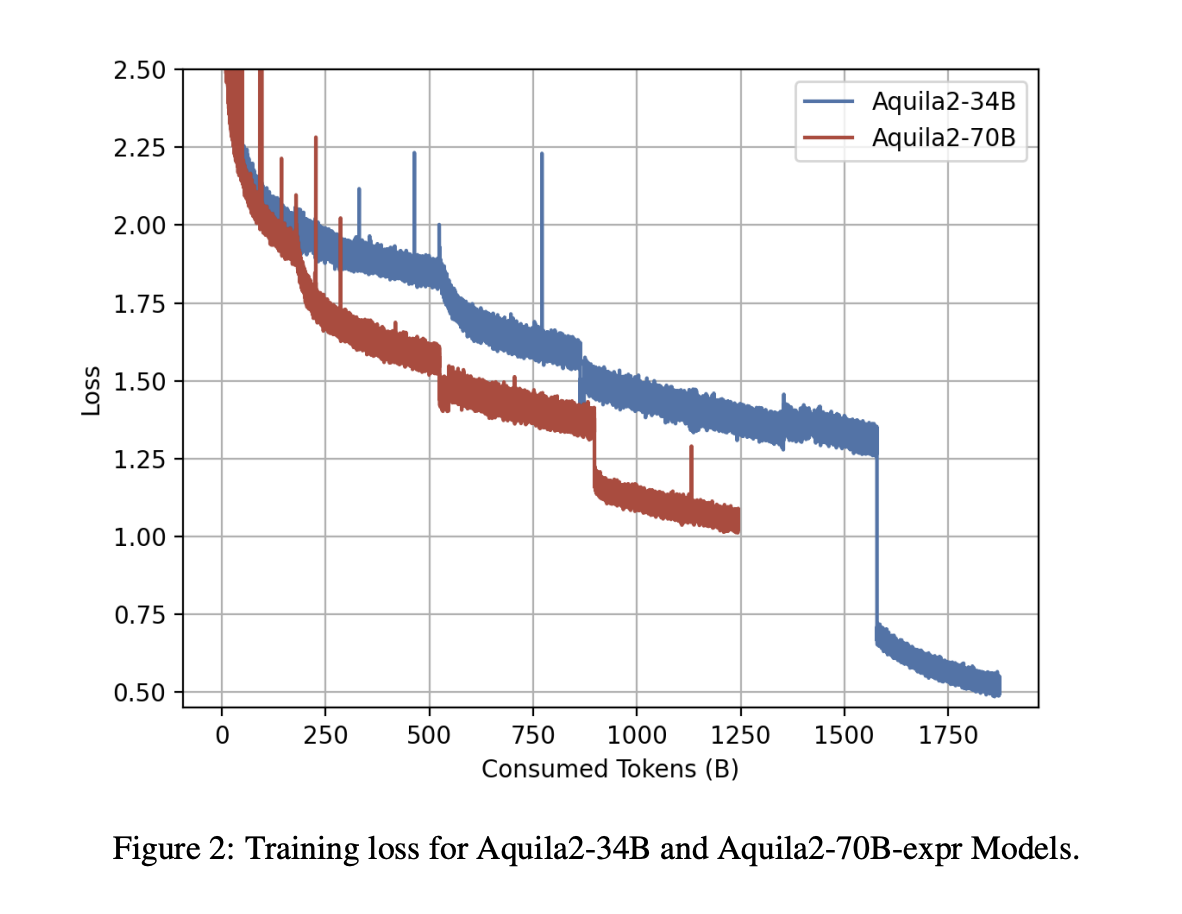

В заключение, исследователи из команды Language Foundation Model & Software в BAAI предложили серию моделей Aquila2, двуязычных моделей с размерами параметров от 7 до 70 миллиардов. Aquila2-34B демонстрирует выдающуюся производительность на 21 различном наборе данных, превосходя модель LLaMA-2-70B-expr и другие эталоны, даже при 4-битной квантизации. Более того, разработанный исследователями фреймворк HM позволяет динамически корректировать распределение данных во время обучения, что приводит к быстрой сходимости и улучшенному качеству модели. Будущие исследования включают изучение смеси экспертов и улучшение качества данных. Однако включение тестовых данных GSM8K в предварительное обучение может повлиять на валидность результатов Aquila2, что требует осторожности при будущих сравнениях.

Проверьте статью и GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта.

Не забывайте следить за нами в Twitter и присоединяйтесь к нашему каналу в Telegram и группе в LinkedIn. Если вам понравилась наша работа, вам понравится наш рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit.

Находите предстоящие вебинары по искусственному интеллекту здесь.

Arcee AI представляет Arcee Swarm: новаторскую смесь агентов MoA Architecture, вдохновленную кооперативным интеллектом, обнаруженным в самой природе.

«`