«`html

Исследование Gradformer: интеграция Graph Transformers (GTs) с внутренними индуктивными предубеждениями

Практические решения и ценность

Графовые трансформеры (GTs) успешно достигли передовых результатов на различных платформах. Они могут захватывать информацию на большие расстояния от узлов, в отличие от локального передачи сообщений в графовых нейронных сетях (GNNs). Самомодифицирующий механизм в GTs позволяет каждому узлу прямо смотреть на другие узлы в графе, собирая информацию из произвольных узлов. Тот же самый самомодифицирующий механизм в GTs также обеспечивает гибкость и способность собирать информацию глобально и адаптивно.

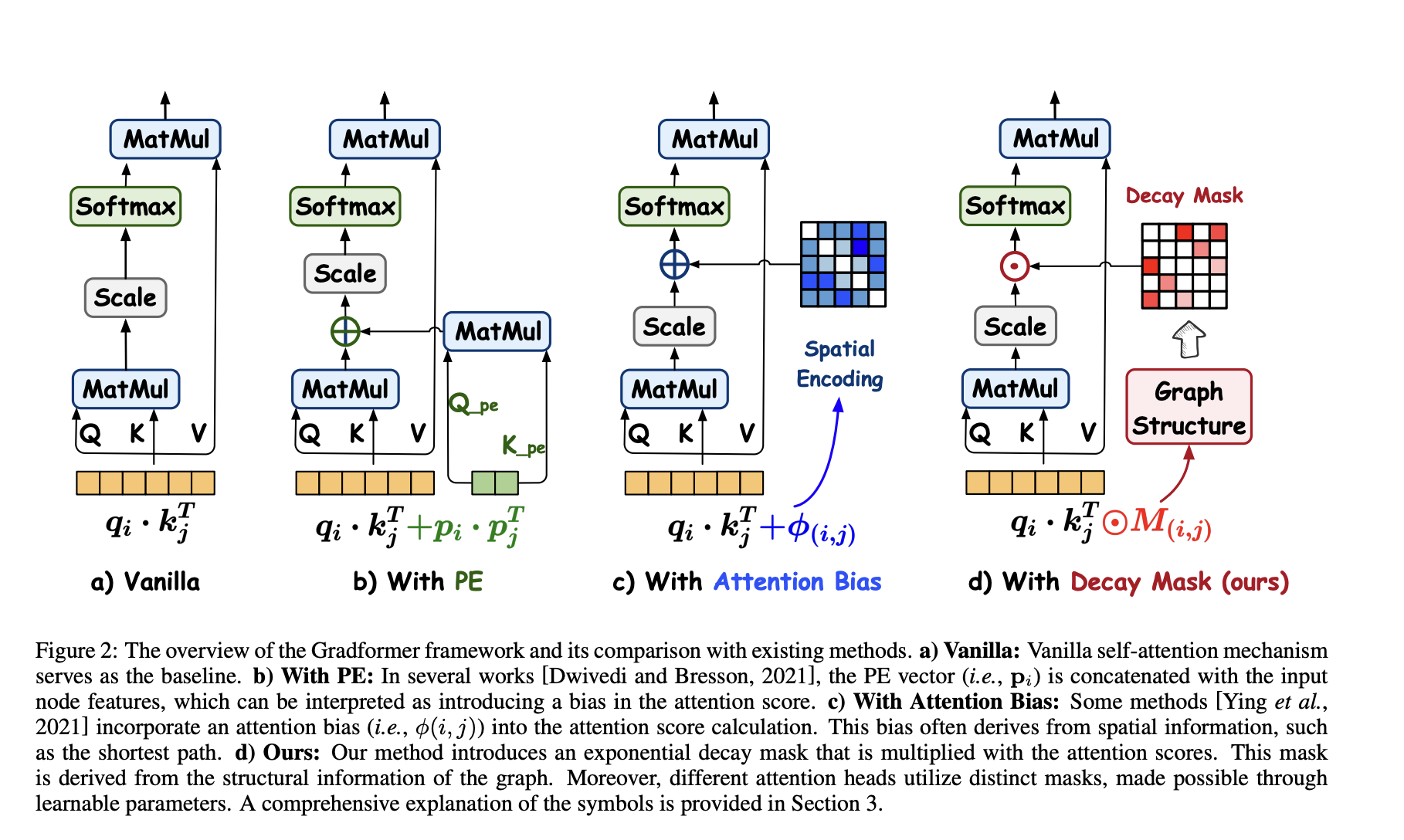

Несмотря на преимущества в различных задачах, самомодифицирующий механизм в GTs не уделяет должного внимания особенностям графов, таким как связанные с структурой предубеждения. Однако исследователи предложили Gradformer, новый метод, инновационно интегрирующий GTs с индуктивным предубеждением. Gradformer включает специальную функцию, называемую маской экспоненциального затухания, в архитектуру самомодифицирующего GT. Этот подход помогает контролировать веса внимания каждого узла относительно других узлов путем умножения маски на оценку внимания.

Gradformer достигает передовых результатов на пяти наборах данных, подчеркивая эффективность предложенного метода. Он превосходит все 14 методов с улучшениями на небольших наборах данных, таких как NC11 и PROTEINS, показывая свою превосходность в ресурсоемкости при хороших результатов производительности.

Исследователи провели анализ эффективности Gradformer и сравнили его стоимость обучения с другими важными методами, такими как SAN, Graphormer и GraphGPS. Результаты сравнения показали, что Gradformer оптимально балансирует эффективность и точность, превосходя SAN и GraphGPS в вычислительной эффективности и точности.

В заключение, исследователи предложили Gradformer, новый метод интеграции GT с внутренними индуктивными предубеждениями. Gradformer превосходит 14 методов GTs и GNNs с улучшением на 2,13% и 2,28% соответственно. Он преуспевает в поддержании или даже превосходит точность поверх плоских моделей, интегрируя более глубокие архитектуры сетей.

Для получения дополнительной информации ознакомьтесь с исследованием.

Все права на это исследование принадлежат его авторам. Также не забудьте подписаться на нас в Twitter, присоединиться к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наш новостной бюллетень. И не забудьте присоединиться к нашему сообществу в Reddit.

«`