«`html

Квантованные собственные векторные матрицы для 4-битной оптимизации второго порядка глубоких нейронных сетей

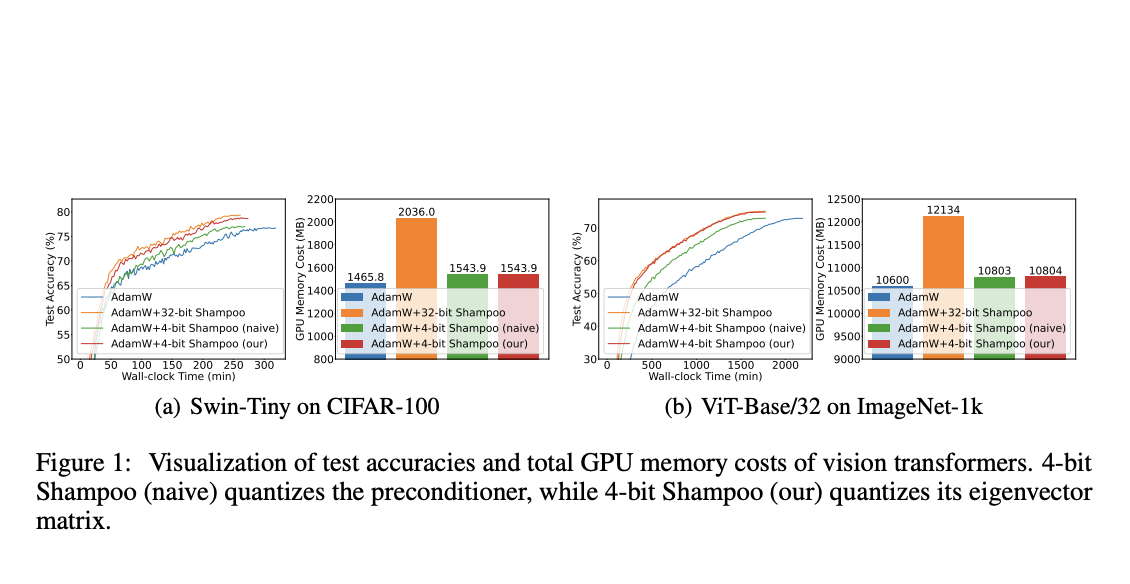

Глубокие нейронные сети (DNN) достигли значительных успехов в различных областях, включая компьютерное зрение, обработку естественного языка и распознавание речи. Однако эффективное обучение крупномасштабных моделей сталкивается с проблемами. Исследователи из университетов Пекина и Сингапура представляют первый 4-битный оптимизатор второго порядка, основанный на методе Shampoo, который обеспечивает сравнимую производительность с его 32-битным аналогом. Это открывает путь для широкого использования эффективных оптимизаторов второго порядка при обучении крупномасштабных DNN.

Практические решения и ценность

Использование квантованных собственных векторных матриц позволяет значительно сократить затраты памяти, сохраняя при этом производительность. Это открывает новые возможности для обучения крупномасштабных DNN с использованием оптимизаторов второго порядка, что может привести к улучшению процессов и результатов в вашей компании.

Для получения дополнительной информации ознакомьтесь с исследованием.

Все права на это исследование принадлежат его авторам. Также не забудьте подписаться на наш Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit и ознакомиться с нашей платформой AI Events.

Этот пост был опубликован на портале MarkTechPost.

«`