«`html

Недавние достижения в медицинских мультимодальных моделях больших языков (MLLM) показали значительный прогресс в принятии медицинских решений.

Проблема ограниченной практичности в клинических условиях

Многие модели, такие как Med-Flamingo и LLaVA-Med, разработаны для конкретных задач и требуют больших наборов данных и высоких вычислительных ресурсов, что ограничивает их практичность в клинических условиях.

Решение: Модель Mixture-of-Expert (MoE)

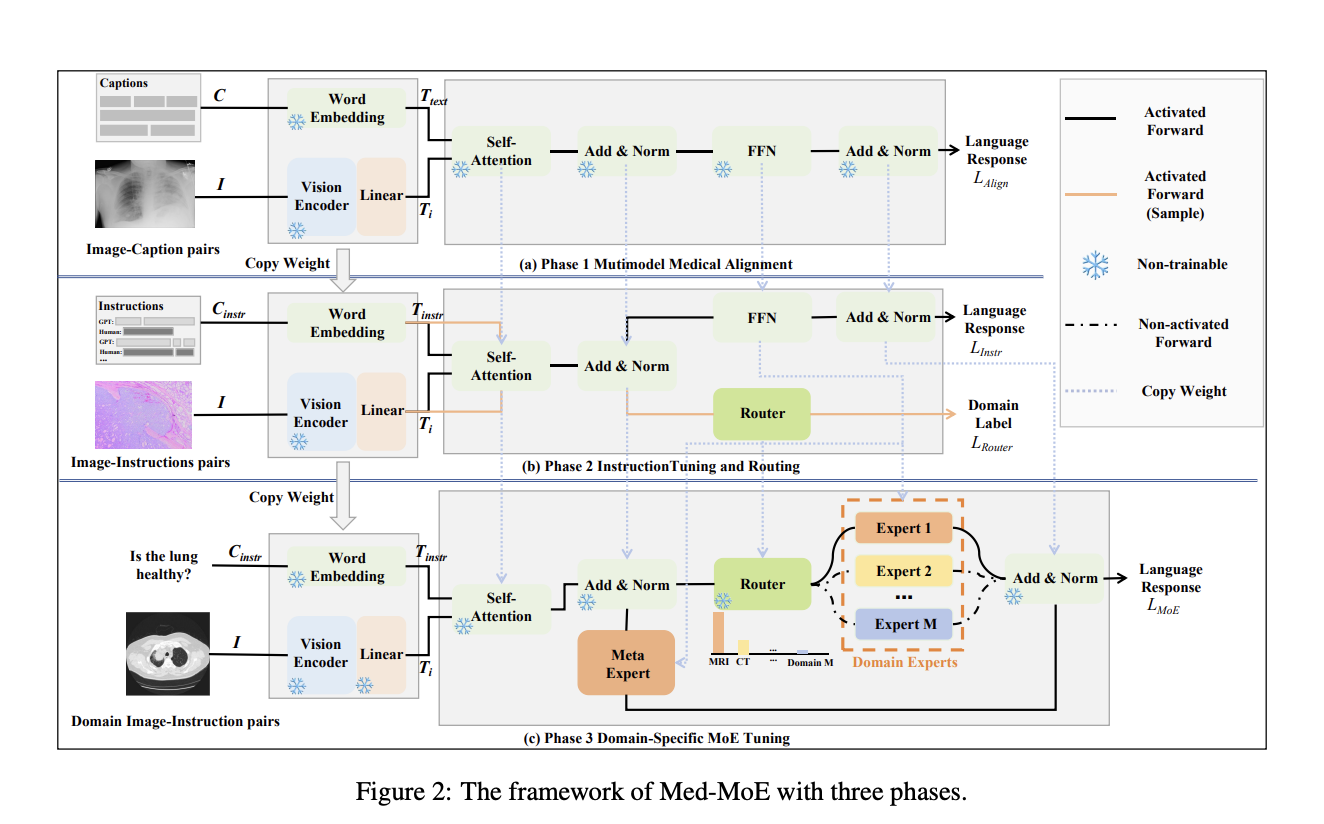

Стратегия Mixture-of-Expert (MoE) предлагает решение с использованием более маленьких, специфических модулей для снижения вычислительных затрат, что важно для более широкого применения в ресурсоограниченных клинических средах.

Практическое решение: Введение Med-MoE

Исследователи из Университета Чжэцзян, Национального университета Сингапура и Пекинского университета представили Med-MoE, легкую структуру для мультимодальных медицинских задач, таких как Med-VQA и классификация изображений.

Преимущества Med-MoE

Med-MoE превосходит или соответствует современным моделям, таким как LLaVA-Med, используя только 30%-50% активированных параметров. Он показывает сильный потенциал для улучшения медицинских решений в ресурсоограниченных условиях.

Применение в широком спектре задач

Применение Med-MoE в различных задачах и метриках показывает превосходную производительность в задачах VQA и классификации медицинских изображений.

Заключение

Med-MoE — это оптимизированная структура для мультимодальных медицинских задач, обеспечивающая современные результаты при снижении активированных параметров. Он предлагает практическое решение для продвинутого медицинского ИИ в ограниченных средах, но требует улучшений в масштабируемости данных и надежности модели.

«`