«`html

Решение для оптимизации моделей ИИ: Prompt Caching на Anthropic API

Проблема:

С ростом сложности моделей ИИ необходимы подробные контексты, что приводит к увеличению затрат и задержек в обработке. Особенно это актуально для таких случаев, как разговорные агенты, помощники по кодированию и обработка больших документов, где контекст необходимо повторно использовать.

Решение:

Anthropic API представляет новую функцию под названием «prompt caching», позволяющую разработчикам сохранять часто используемые контексты и повторно использовать их при вызове API. Это значительно снижает затраты и задержки, связанные с повторной отправкой больших контекстов.

Практическая ценность:

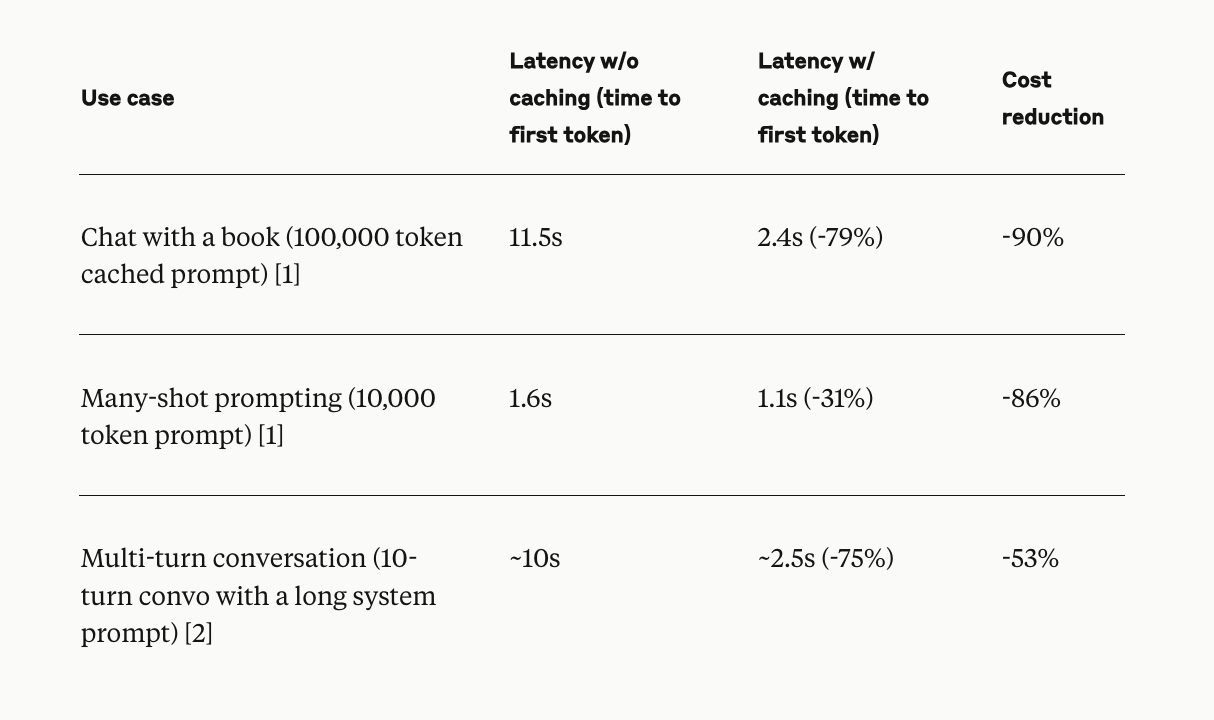

Это особенно эффективно в сценариях продолжительных разговоров, помощи в кодировании, обработке больших документов и поиске информации, где необходимо сохранять большое количество контекста. Цены на prompt caching спроектированы для экономии: запись в кэш увеличивает цену токена ввода на 25%, в то время как чтение из кэша стоит только 10% от базовой цены токена ввода.

Заключение:

Prompt caching решает проблему увеличения затрат и задержек в моделях ИИ, требующих подробных контекстов. Эта функция улучшает эффективность различных приложений, от разговорных агентов до обработки больших документов. Реализация prompt caching на Anthropic API предлагает многообещающее решение для вызовов, связанных с большими контекстами, что делает его значительным продвижением в области LLMs.

«`